Databricks Data Intelligence Platform

Databricks Data Intelligence PlatformDatabricks es una plataforma unificada de datos diseñada para simplificar y acelerar proyectos de IA, Data Science y Machine Learning en entornos empresariales. Su propuesta principal es ofrecer un espacio colaborativo donde equipos de científicos de datos, ingenieros de datos y analistas puedan trabajar de forma integrada, eliminando silos y reduciendo la complejidad operativa. La base de la solución es Apache Spark, lo que le permite manejar volúmenes masivos de datos con un rendimiento escalable en la nube.

Una de sus funcionalidades clave es el Lakehouse, un enfoque que combina lo mejor de los Data Lakes y los Data Warehouses, facilitando tanto el almacenamiento flexible de datos no estructurados como la gestión eficiente de datos estructurados para el análisis avanzado. Esto permite a las organizaciones centralizar sus datos en un mismo entorno y habilitar procesos de ETL, exploración y modelado con mayor agilidad. Además, Databricks integra de forma nativa notebooks colaborativos, librerías de ML y conectividad con entornos de desarrollo y herramientas externas como MLflow, TensorFlow o scikit-learn.

Otro punto diferencial es su capacidad de gestión de ciclos de vida de modelos de Machine Learning. La plataforma no solo facilita el entrenamiento y validación de modelos, sino también el seguimiento de experimentos, la gestión de versiones y el despliegue en producción. Esto convierte a Databricks en una solución que busca cubrir de extremo a extremo el flujo de trabajo en ciencia de datos, reduciendo la fricción entre investigación y operaciones. Su enfoque de escalabilidad en la nube (con soporte para AWS, Azure y Google Cloud) lo posiciona como una opción atractiva para empresas que necesitan flexibilidad y potencia en proyectos de analítica avanzada.

Funcionalidades de Databricks

Lakehouse Architecture

La funcionalidad central de Databricks es su arquitectura Lakehouse, que unifica en un solo entorno las ventajas de los Data Lakes y los Data Warehouses. Esto permite almacenar y procesar tanto datos estructurados como no estructurados, eliminando la necesidad de mantener sistemas duplicados. Gracias a esta convergencia, las organizaciones pueden centralizar el almacenamiento de datos, mejorar la gobernanza y habilitar analítica avanzada sin tener que mover constantemente la información entre plataformas diferentes.

Notebooks Colaborativos

Databricks ofrece notebooks colaborativos en la nube, donde equipos de científicos de datos, ingenieros y analistas pueden trabajar en tiempo real sobre el mismo proyecto. Estos notebooks soportan múltiples lenguajes de programación como Python, R, SQL y Scala, lo que favorece la colaboración entre perfiles técnicos diversos. Además, incluyen herramientas de visualización integrada, lo que facilita la exploración de datos y la creación de prototipos de modelos de manera rápida.

Machine Learning y MLOps

La plataforma integra un entorno completo para el desarrollo de modelos de Machine Learning y su operacionalización mediante MLOps. Esto incluye el entrenamiento distribuido de modelos, la optimización de hiperparámetros y el uso de librerías externas como TensorFlow, PyTorch o scikit-learn. A través de MLflow, Databricks permite llevar un control detallado de los experimentos, el versionado de modelos y la implementación en producción, reduciendo los tiempos de ciclo de vida y facilitando la reproducibilidad.

Procesamiento de Datos en Escala

Basado en Apache Spark, Databricks garantiza un procesamiento distribuido capaz de manejar grandes volúmenes de datos con alto rendimiento. Esta capacidad lo convierte en una herramienta ideal para cargas de ETL (Extract, Transform, Load), data streaming y batch processing. El motor permite ejecutar consultas complejas en segundos sobre petabytes de información, lo que da a las empresas la capacidad de explotar datos masivos sin depender de infraestructuras rígidas o limitadas.

Integración con Ecosistemas Cloud

Databricks está diseñado para funcionar en las principales plataformas cloud: AWS, Microsoft Azure y Google Cloud Platform. Esto otorga a las empresas flexibilidad en la elección de proveedor y les permite aprovechar servicios complementarios como almacenamiento en la nube, orquestadores de datos o servicios de seguridad y autenticación. Además, su integración con herramientas externas de BI (como Power BI o Tableau) facilita la conexión entre el trabajo de analítica avanzada y la toma de decisiones en entornos de negocio.

Seguridad y Gobernanza de Datos

Otro aspecto clave es la seguridad y gobernanza de datos, con capacidades como control de accesos a nivel de filas y columnas, auditorías de uso y cifrado de datos en tránsito y en reposo. Gracias a su módulo Unity Catalog, Databricks permite gestionar de forma centralizada la catalogación de datos, la trazabilidad y el cumplimiento normativo (por ejemplo, GDPR o HIPAA). Esto asegura que la explotación de los datos cumpla con los estándares empresariales y regulatorios.

Automatización y Optimización

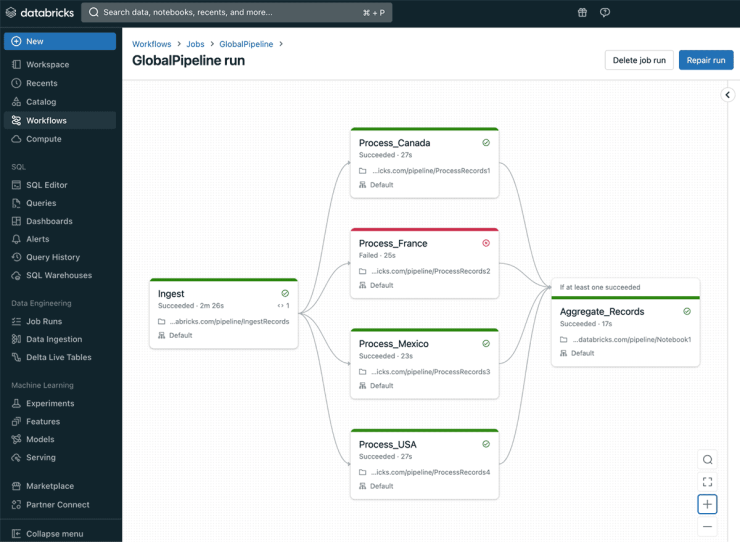

La plataforma incluye herramientas de automatización para tareas recurrentes, como la programación de pipelines de datos o la optimización automática de consultas SQL. Además, dispone de funcionalidades de autoescalado que ajustan dinámicamente los recursos de cómputo en función de la carga de trabajo. Estas características reducen los costes operativos y aumentan la eficiencia, ya que permiten ejecutar proyectos de IA y análisis masivos sin desperdiciar recursos.

Reseña técnica de Databricks

Databricks constituye una plataforma de análisis de datos e inteligencia artificial enfocada en unificar procesos de Data Science, Machine Learning y gestión de datos dentro de un mismo entorno. Su propuesta se orienta a organizaciones que manejan grandes volúmenes de información y requieren integrar procesamiento distribuido, colaboración en tiempo real y despliegue de modelos en producción con un alto nivel de escalabilidad.

La arquitectura Lakehouse combina lo mejor de los Data Lakes y los Data Warehouses, ofreciendo un modelo único de almacenamiento que admite tanto datos estructurados como no estructurados. Este enfoque reduce duplicidades, evita la fragmentación de sistemas y permite un acceso más ágil a la información. Además, el módulo Delta Lake garantiza consistencia transaccional, control de versiones y fiabilidad en la manipulación de datos críticos.

Los notebooks colaborativos representan un núcleo de trabajo para equipos multidisciplinares. Permiten programar en Python, R, SQL y Scala, además de integrar librerías gráficas para la visualización de resultados. La colaboración en tiempo real agiliza la validación de hipótesis, la depuración de código y la construcción de prototipos de modelos, lo que incrementa la productividad en proyectos complejos.

En el ámbito de Machine Learning, Databricks ofrece integración nativa con MLflow, facilitando el seguimiento de experimentos, la gestión de hiperparámetros y la implementación de modelos en diferentes entornos de ejecución. Esta capacidad acelera la transición del laboratorio a la producción y asegura la reproducibilidad de resultados en ciclos de vida completos.

El motor basado en Apache Spark habilita procesamiento masivo en paralelo, tanto en cargas de streaming como en batch, con tiempos de respuesta optimizados incluso en contextos de petabytes de datos. Esta potencia convierte a Databricks en una herramienta estratégica para ejecutar ETL, análisis exploratorios o entrenamiento de modelos de gran escala.

La integración con los principales proveedores cloud —AWS, Azure y Google Cloud— garantiza flexibilidad de despliegue, acceso a ecosistemas complementarios y elasticidad en el consumo de recursos. El autoescalado dinámico ajusta la infraestructura a la demanda, optimizando costes sin comprometer el rendimiento.

En materia de gobernanza y seguridad, el Unity Catalog centraliza la gestión de metadatos, el control de accesos y el cumplimiento de normativas como GDPR o HIPAA. El cifrado en tránsito y en reposo, sumado a la trazabilidad de operaciones, aporta confianza en proyectos con alta sensibilidad de datos.

Fortalezas y debilidades de Databricks

| Fortalezas | Debilidades |

|---|---|

| Arquitectura Lakehouse que unifica Data Lake y Data Warehouse. | Curva de aprendizaje pronunciada para nuevos usuarios. |

| Escalabilidad en la nube con soporte para AWS, Azure y Google Cloud. | Costes de uso elevados en entornos de gran escala. |

| Procesamiento distribuido con Apache Spark para grandes volúmenes de datos. | Dependencia de una infraestructura cloud robusta. |

| Integración con librerías y frameworks de Machine Learning y MLOps. | Menor enfoque en BI tradicional frente a plataformas como Snowflake. |

| Notebooks colaborativos para trabajo en equipo en tiempo real. | Complejidad en la gestión inicial y configuración avanzada. |

| Unity Catalog para gobernanza de datos, seguridad y cumplimiento normativo. | Menor atractivo para proyectos pequeños con bajo volumen de datos. |

Licenciamiento e instalación

Databricks se ofrece bajo un modelo de licenciamiento por suscripción (pago por uso o instancias reservadas), con una estructura SaaS y opciones de pago por consumo; está diseñado para empresas de todos los tamaños —desde pymes hasta grandes corporaciones y organizaciones enterprise—, y su tipo de instalación es completamente gestionada en la nube (AWS, Azure y Google Cloud) con capacidades multi-cloud, sin despliegue on-premise nativo pero compatible con entornos híbridos mediante conectores y redes privadas virtuales.

Preguntas frecuentes sobre Databricks

¿Qué es Databricks? Databricks es una plataforma unificada Lakehouse que integra data lake, data warehouse y procesamiento distribuido con Apache Spark.

¿Por qué elegir Databricks para proyectos de Data Science? Porque centraliza notebooks colaborativos, soporta múltiples lenguajes (Python, SQL, Scala, R) y facilita la colaboración entre equipos técnicos.

¿Cuáles son las principales fortalezas de Databricks? Unifica Data Lake y Data Warehouse con su arquitectura Lakehouse, ofrece escalabilidad elástica en AWS, Azure y GCP, habilita procesamiento distribuido con Apache Spark, facilita notebooks colaborativos y centraliza la gobernanza con Unity Catalog.

¿Cuáles son las principales debilidades de Databricks? Presenta una curva de aprendizaje pronunciada, los costes pueden ser elevados en despliegues grandes, depende de una infraestructura cloud robusta, la gestión de clústeres es compleja y su énfasis en IA/ML deja un menor enfoque en BI tradicional.

¿Cómo asegura la escalabilidad y el rendimiento? Ofrece autoscaling en la nube y un motor distribuido (Apache Spark) que procesa big data en tiempo real y por lotes.

¿Qué componentes de Machine Learning incluye? Incluye MLflow para gestión de experimentos, Feature Store para características y herramientas de MLOps para despliegue y monitorización de modelos.

¿Cómo gestiona la gobernanza y la seguridad de datos? A través de Unity Catalog que centraliza metadatos, permisos y cumple con normativas como GDPR y HIPAA.

¿Con qué nubes es compatible Databricks? Se integra de forma nativa con AWS, Azure y Google Cloud Platform, facilitando despliegues híbridos y multi-cloud.

Referencias

Página oficial de Databricks: Databricks: Data and AI Solutions for Enterprises