Amazon SageMaker es un servicio en la nube de AWS diseñado para facilitar el desarrollo, entrenamiento y despliegue de modelos de Machine Learning (ML) y Data Science. Su propuesta principal es ofrecer una plataforma integrada y gestionada que permite a equipos técnicos acelerar el ciclo de vida de los modelos, evitando la complejidad de configurar infraestructura desde cero. Desde un único entorno, los usuarios pueden acceder a herramientas de desarrollo, almacenamiento de datos, algoritmos optimizados y entornos de entrenamiento escalables.

Una de sus fortalezas es la capacidad de automatizar procesos críticos mediante funciones como Autopilot, que genera y entrena modelos automáticamente a partir de conjuntos de datos sin necesidad de programar código extenso. Además, incorpora soporte para frameworks populares como TensorFlow, PyTorch y Scikit-learn, lo que brinda flexibilidad a científicos de datos y desarrolladores. Al integrarse de manera nativa con el ecosistema de AWS, facilita la ingesta, preparación y análisis de grandes volúmenes de información mediante servicios complementarios como S3, Redshift y Glue.

En cuanto al despliegue, Amazon SageMaker ofrece opciones de implementación escalable y segura gracias a su compatibilidad con contenedores, endpoints en tiempo real y batch transform. La plataforma incluye también herramientas de monitorización, gestión de versiones y detección de sesgos, fundamentales en entornos de producción empresarial. En conjunto, se presenta como una solución robusta que busca equilibrar usabilidad, integración y escalabilidad para empresas que necesitan acelerar sus iniciativas de inteligencia artificial con un enfoque práctico y orientado a negocio.

Funcionalidades de Amazon SageMaker

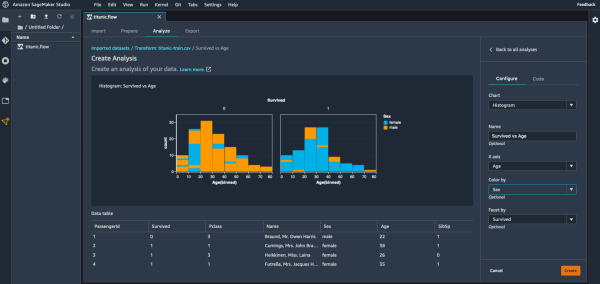

SageMaker Studio ofrece un entorno integrado tipo IDE para científicos de datos e ingenieros de ML, combinando notebooks, visualizaciones, seguimiento de experimentos y herramientas de despliegue en una única interfaz web que facilita la colaboración y la trazabilidad de todo el ciclo de vida del modelo.

Los notebooks gestionados permiten crear y ejecutar cuadernos Jupyter sobre instancias escalables sin preocuparse por la administración de infraestructuras; incluyen arranque rápido, acceso a datos en S3, snapshots reproducibles y la posibilidad de compartir entornos para colaboración reproducible entre equipos.

SageMaker Data Wrangler y las jobs de procesamiento facilitan el preprocesamiento de datos y la ingeniería de características mediante flujos visuales o scripts gestionados, reduciendo el tiempo de preparación de datos mediante transformaciones, muestreos, imputación y exportación directa a formatos listos para entrenamiento.

Ground Truth es la solución de etiquetado de datos integrada que combina etiquetado humano y automatización mediante workflows, herramientas de calidad y mecanismos de revisión, lo que permite crear datasets anotados de alta calidad y reducir costes mediante el aprendizaje activo y el autoetiquetado.

El Feature Store centraliza el almacenamiento, la gestión y la reutilización de features en producción y experimentación, soportando versiones, consistencia entre entrenamiento e inferencia, y consultas rápidas para servir características con baja latencia a endpoints de inferencia.

Las capacidades de entrenamiento gestionado permiten lanzar trabajos con frameworks populares (TensorFlow, PyTorch, Scikit-learn) sobre instancias GPU/CPU o clusters distribuidos, con soporte para contenedores personalizados, checkpoints a S3 y escalado automático para acomodar cargas de entrenamiento grandes.

El entrenamiento distribuido y el soporte para GPU multinodo facilitan el entrenamiento de modelos a gran escala (por ejemplo, modelos de lenguaje o visión) usando bibliotecas de paralelización, reducción de gradientes y optimizaciones de comunicaciones para minimizar el tiempo hasta convergencia.

El Ajuste automático de hiperparámetros (HPO) explora automáticamente configuraciones de hiperparámetros mediante algoritmos bayesianos o de búsqueda aleatoria, acelerando la optimización de modelos y proporcionando métricas comparables, trials y trazabilidad para elegir la mejor configuración reproducible.

SageMaker Pipelines ofrece orquestación nativa de pipelines de ML declarativos para integrar preparación de datos, entrenamiento, evaluación, registro y despliegue, con control de versiones, pasos condicionales y métricas que permiten construir CI/CD de modelos reproducibles y auditables.

El Model Registry centraliza versiones de modelos, metadatos, artefactos y estados del ciclo de vida (proposed, approved, deployed), facilitando revisiones, auditorías y despliegues controlados con gobernanza sobre qué versión pasa a producción.

Para despliegue e inferencia, SageMaker soporta endpoints de inferencia en tiempo real, batch transform para inferencias por lotes, y serverless inference para cargas esporádicas; además permite multi-model endpoints para alojar muchos modelos en una sola instancia y optimizar costes.

SageMaker Model Monitor realiza monitorización continua de modelos en producción, detectando drift en las distribuciones de entrada/salida, sesgos en predicciones y alertas configurables; incluye generación de informes para mantener la integridad y rendimiento del modelo a lo largo del tiempo.

SageMaker Debugger y Profiler capturan automáticamente métricas, trazas y tensores durante el entrenamiento, permitiendo identificar cuellos de botella de rendimiento, comportamiento anómalo del modelo y problemas de convergencia mediante reglas predefinidas o personalizadas sin modificar el código de entrenamiento.

SageMaker Clarify proporciona herramientas de explicabilidad y detección de sesgo, generando métricas de equidad, importancia de características y explicaciones locales/globales de predicciones (por ejemplo SHAP), ayudando a cumplir requisitos regulatorios y a interpretar decisiones de modelos complejos.

SageMaker Neo y las funcionalidades de edge deployment optimizan y compilan modelos para ejecutarse eficientemente en dispositivos de borde con diferentes arquitecturas, reduciendo latencia y consumo energético sin necesidad de reentrenar el modelo, facilitando despliegues IoT y embebidos.

SageMaker JumpStart ofrece modelos preentrenados, soluciones y notebooks de referencia listos para producir valor rápido, con plantillas para casos de uso comunes (NLP, visión, forecasting) que aceleran prototipado y reducen la barrera de entrada para equipos que desean resultados inmediatos.

Reseña técnica de Amazon SageMaker

Amazon SageMaker constituye una suite avanzada de Amazon Web Services enfocada en todo el flujo de vida de proyectos de Machine Learning y ciencia de datos, que abarca desde la adquisición de datos hasta la put (puesta en producción) de modelos en entornos empresariales. Su diseño modular permite combinar capacidades gestionadas de cómputo y almacenamiento con una interfaz unificada, lo que agiliza la iteración entre fases de exploración, entrenamiento y despliegue. Gracias a la integración nativa con servicios como S3, Redshift y Glue, los equipos técnicos logran orquestar pipelines de datos y modelos con alto grado de automación, reduciendo drásticamente la complejidad operativa.

Arquitectura y componentes

La arquitectura de SageMaker combina servicios gestionados y componentes reutilizables que facilitan la transición desde la experimentación hasta la producción. En el centro aparece SageMaker Studio, un entorno integrado que agrupa notebooks, herramientas de seguimiento de experimentos y paneles de despliegue en una única interfaz web. Complementan la experiencia elementos como SageMaker Data Wrangler para la preparación de datos, el Feature Store para la gestión de características, y el Model Registry para controlar versiones y estados del ciclo de vida. El diseño modular permite encadenar estos bloques mediante Pipelines, lo que facilita implementar procesos reproducibles y trazables desde la ingestión hasta la inferencia.

Preparación y tratamiento de datos

La preparación de datos suele consumir la mayoría del tiempo en proyectos reales, y en ese campo SageMaker ofrece herramientas que reducen fricción operativa. Data Wrangler facilita transformaciones visuales y exportes directos a formatos optimizados para entrenamiento, mientras que las jobs de procesamiento permiten ejecutar transformaciones en contenedores gestionados, integrando con S3 y otros orígenes de datos. Para etiquetado a escala, Ground Truth combina flujos humanos y automatizados, con controles de calidad y soporte para aprendizaje activo que reduce el coste por etiqueta. El resultado práctico: pipelines de datos que pueden llevarse a producción sin reescribir código en cada iteración.

Notebooks y experiencia de desarrollo

La experiencia de desarrollo pivota sobre notebooks gestionados, con integración directa a repositorios de código y a contenedores de ejecución. Eso favorece reproducibilidad: snapshots de entornos, kernels preconfigurados y la posibilidad de compartir instancias con permisos controlados. El enfoque mejora la colaboración entre perfiles mixtos —científicos y desarrolladores— y permite que experimentos avanzados se concreten en artefactos que puedan pasar al Model Registry con trazabilidad de dependencias y métricas.

Entrenamiento y escalado

En escenarios donde los modelos demandan potencia de cálculo, SageMaker ofrece entrenamiento gestionado en instancias GPU y CPU optimizadas, con soporte para entrenamiento distribuido multinodo. Las capacidades de checkpointing hacia S3 y la posibilidad de usar contenedores personalizados permiten adaptar pipelines para redes neuronales profundas, modelos de lenguaje y arquitecturas específicas. Otra pieza importante: el ajuste automatizado de hiperparámetros mediante algoritmos bayesianos o de búsqueda aleatoria que aceleran la convergencia y facilitan comparaciones reproducibles entre trials.

Optimización y reducción de costes

La flexibilidad para elegir tipos de instancias y la disponibilidad de escalado automático ayudan a optimizar costes, aunque la responsabilidad de control queda en manos del equipo: sin políticas de apagado automático, selección adecuada de tipos y monitoreo continuo, la factura puede crecer con rapidez. Herramientas como multi-model endpoints y serverless inference permiten empaquetar y servir múltiples modelos en una sola infraestructura o escalar a demanda en cargas esporádicas, reduciendo consumo en producción cuando la carga no justifica instancias dedicadas.

Despliegue y opciones de inferencia

El ecosistema de inferencia incluye endpoints de tiempo real, batch transform para tareas por lotes y opciones orientadas al borde mediante SageMaker Neo. Los endpoints gestionados permiten configuraciones de alto rendimiento con balanceo, auto-scaling y rotaciones de modelos desde el Model Registry, mientras que la inferencia por lotes simplifica procesar volúmenes elevados de datos sin mantener infraestructuras permanentes. Para aplicaciones IoT y embebidas, la compilación y optimización de modelos con Neo reduce latencia y consumo energético en hardware heterogéneo.

Gobernanza del modelo y gestión del ciclo de vida

En proyectos regulados o altamente auditables, la gestión de versiones y el control de estados cobran importancia. El Model Registry centraliza artefactos, metadatos, tags y aprobaciones, lo que facilita auditorías y despliegues controlados. Combinado con Pipelines, se pueden definir gates de calidad y pasos condicionales que automatizan partes del proceso de promoción a producción, con trazabilidad de métricas y metadatos para cada versión.

Monitorización, explicabilidad y control de drift

Una vez un modelo entra en producción, la visibilidad continua resulta crítica. Model Monitor captura distribuciones de entrada y salida, detecta desviaciones y permite establecer alertas basadas en umbrales o reglas. Para entender decisiones de modelos complejos, SageMaker Clarify ofrece métricas de equidad, detección de sesgos y explicaciones locales y globales (por ejemplo, SHAP), respaldando prácticas de ML responsables y cumplimiento normativo. En paralelo, Debugger y Profiler entregan información detallada durante el entrenamiento: tensores, anomalías y cuellos de botella que ayudan a diagnosticar problemas de convergencia o performance sin necesidad de instrumentar manualmente el código.

Feature Store y consistencia entre entrenamiento e inferencia

El Feature Store apunta a resolver un problema clásico: la discrepancia entre características generadas en entrenamiento y las usadas en inferencia. Al centralizar features con versiones y contratos, se facilita la reutilización y se reduce el riesgo de drift por transformaciones inconsistentes. Además, la capacidad de servir features con baja latencia permite integrar pipelines de inferencia en aplicaciones que requieren respuestas casi en tiempo real.

Seguridad y cumplimiento

En cuanto a seguridad, la plataforma integra controles propios de la nube: gestión de identidades y accesos con IAM, cifrado en reposo y en tránsito, y compatibilidad con VPC para aislar comunicaciones. Para empresas que manejan datos sensibles, la opción de ejecutar workloads dentro de redes privadas y aplicar cifrado de claves gestionadas por el cliente ofrece una capa adicional de protección que facilita la conformidad con estándares corporativos y regulatorios.

Integración con el ecosistema AWS y extensibilidad

SageMaker se beneficia de la estrecha integración con otros servicios de AWS: ingestión desde S3, orquestación con Step Functions, control de costes mediante Cost Explorer, y uso de servicios de registro y observabilidad nativos. Esa integración permite construir soluciones que combinan almacenamiento, streaming y análisis con poca fricción operativa. Al mismo tiempo, el soporte para contenedores personalizados y frameworks populares (TensorFlow, PyTorch, Scikit-learn, MXNet) facilita portar cargas de trabajo existentes sin reescribir librerías.

Casos de uso y ejemplaridad técnica

En empresas con necesidades de NLP, visión por computador o sistemas de recomendación, la plataforma acelera el time-to-market al ofrecer componentes listos para producción. JumpStart y modelos preentrenados permiten arrancar prototipos con mejores prácticas, mientras que las opciones de entrenamiento distribuido soportan el escalado cuando los volúmenes de datos o la complejidad del modelo lo exigen. En escenarios de alta criticidad operativa —por ejemplo, detección de fraude o sistemas de salud—, la combinación de monitorización, clarificación y registro de modelos aporta un marco práctico para mitigar riesgos.

Experiencia de uso y curva de aprendizaje

Desde la perspectiva del equipo técnico, la curva de adopción depende del conocimiento previo de AWS. Usuarios con experiencia en la nube encontrarán coherencia en la gestión de recursos y políticas; equipos nuevos en AWS afrontarán una fase de aprendizaje adicional asociada a la configuración de roles, permisos y networking. La abundancia de opciones y la flexibilidad en la configuración convierten a la plataforma en una herramienta potente para organizaciones con prácticas de ingeniería maduras, pero pueden sobrecargar a equipos pequeños que buscan soluciones llave en mano con mínima operativa.

Costes y decisiones de arquitectura económica

Los costes reales dependen de arquitectura y patrones de uso: entrenamiento en instancias GPU de alto rendimiento, almacenamiento de checkpoints, uso sostenido de endpoints en tiempo real y pipelines frecuentes incrementan el gasto. Opciones como spot instances para entrenamiento, serverless inference para cargas esporádicas, y multi-model endpoints para consolidar modelos ayudan a contener costes, siempre que se definan políticas de automatización que apaguen recursos o ajusten capacidad cuando la demanda varíe.

Limitaciones y puntos de fricción

Aun con su madurez, la plataforma no resulta perfecta para todas las situaciones. La dependencia del ecosistema AWS puede representar un bloqueo para arquitecturas multi-cloud o entornos on-premise estrictos. La granularidad de permisos y la configuración de red pueden convertirse en barreras administrativas para equipos con recursos limitados. Además, mientras que muchas funciones están altamente automatizadas, lograr una operación eficiente en producción exige inversión en procesos de ML Ops y en gobernanza de datos, tareas que requieren disciplina organizativa más que solo herramientas.

Comparativa práctica con alternativas

Frente a alternativas gestionadas como las plataformas propietarias de grandes nubes rivales o soluciones open-source empaquetadas por proveedores independientes, SageMaker destaca por la integración nativa con servicios cloud y la amplitud de componentes orientados a la producción. Las plataformas más especializadas pueden ofrecer menor latencia en inferencia edge o costes más ajustados en casos concretos, pero la riqueza funcional y la continuidad operativa que proporciona SageMaker suelen justificar la elección en empresas que ya operan dentro del ecosistema AWS.

Operaciones y observabilidad

Para equipos de ML Ops, la observabilidad no se limita a métricas de CPU/GPU: requiere trazabilidad de datos, registros de inferencia, y métricas de calidad del modelo. Las herramientas de Model Monitor, Debugger y los logs integrados en CloudWatch facilitan esta labor, aunque la integración con sistemas de terceros para alerting y paneles personalizados puede requerir trabajo adicional. En entornos críticos, conviene diseñar pipelines de inspección y pruebas A/B que permitan validar modelos antes de la promoción a producción.

Estrategias recomendadas para adopción

Para reducir riesgos, una estrategia gradual funciona mejor: comenzar con prototipos usando JumpStart o modelos base, validar pipelines de datos con Data Wrangler, y estandarizar features en el Feature Store antes de migrar cargas de entrenamiento a instancias multinodo. Establecer políticas de coste, configurar guardrails en el Model Registry, y automatizar apagado de recursos evita sorpresas en la factura. Finalmente, invertir en formación sobre IAM y networking minimiza problemas operativos futuros.

Futuro operativo y tendencias

La tendencia general del sector apunta hacia mayor automatización del ciclo de vida del modelo y un aumento de la demanda por soluciones que ofrezcan explicabilidad y cumplimiento. En ese contexto, las capacidades de Clarify, calidad de datos y pipelines declarativos consolidan el papel de plataformas integradas. Para las organizaciones que aspiran a desplegar modelos a gran escala, las mejoras en entrenamiento distribuido, soporte hardware especializado y optimizaciones de inferencia representarán factores clave en la siguiente ola de adopción.

En resumen

Para equipos técnicos con necesidades de producción y experiencia en la nube, Amazon SageMaker proporciona un conjunto amplio y coherente de herramientas enfocadas a resolver tanto problemas técnicos como operativos del aprendizaje automático industrial. La plataforma reduce tiempo de integración entre experimentación y despliegue, incorpora mecanismos de gobernanza y monitorización y facilita la optimización de costes mediante opciones variadas de inferencia y entrenamiento. No obstante, la adopción exigirá inversión en prácticas de ML Ops, disciplina en la gestión de recursos y un diseño arquitectónico que contemple la nube como plataforma primaria.

Fortalezas y debilidades de Amazon SageMaker

| Fortalezas | Debilidades |

|---|---|

| Integración con AWS: acceso nativo a S3, IAM, CloudWatch y servicios de orquestación. | Dependencia del ecosistema: migrar fuera de AWS implica esfuerzo y coste añadido. |

| Escalabilidad: soporte para instancias GPU/CPU y entrenamiento multinodo. | Coste creciente: facturación alta si no se optimizan instancias, checkpoints y endpoints. |

| Pipelines y MLOps: SageMaker Pipelines y Model Registry para gobernanza y trazabilidad. | Complejidad operativa: requiere procesos de ML Ops y disciplina organizativa. |

| Herramientas de datos: Data Wrangler, Ground Truth y Feature Store para preparar y etiquetar datos. | Curva de aprendizaje: configuración de roles, VPC y permisos puede ser confusa para nuevos usuarios. |

| Inferencia flexible: endpoints en tiempo real, batch transform y serverless. | Gestión de costes en inferencia: endpoints permanentes pueden resultar caros en cargas esporádicas. |

| Monitorización y diagnóstico: Model Monitor, Debugger y Profiler para producción. | Integración extra: paneles avanzados y alertas externas requieren trabajo adicional. |

| Explicabilidad y equidad: SageMaker Clarify para detección de sesgos y explicaciones (SHAP). | Limitaciones multi-cloud: funciones avanzadas no siempre disponibles fuera de AWS. |

| Modelos y aceleradores: JumpStart y contenedores personalizados para prototipos rápidos. | Overhead administrativo: gobernanza y control de versiones exigen políticas y revisiones. |

| Optimización para edge: Neo compila modelos para dispositivos heterogéneos. | Soporte on-premise limitado: despliegues híbridos pueden necesitar adaptaciones. |

| Compatibilidad de frameworks: TensorFlow, PyTorch, Scikit-learn y contenedores propios. | Gran abanico de opciones: demasiadas alternativas pueden confundir la elección arquitectónica. |

Licenciamiento e instalación

El licenciamiento de Amazon SageMaker se basa en un modelo de pago por uso como servicio PaaS, ideal para evitar costes fijos de licencias. En términos de tamaño de empresa, adapta su escalabilidad para pymes y grandes organizaciones, así como proyectos de investigación o startups en fase inicial.

En cuanto al tipo de instalación, opera principalmente como solución de nube gestionada, con capacidades de despliegue híbrido mediante VPN o AWS Outposts y opciones de instalación on-premise en centros de datos corporativos.

Preguntas Frecuentes (FAQ) sobre Amazon SageMaker

¿Qué es Amazon SageMaker?

Amazon SageMaker es una plataforma gestionada de Machine Learning y ciencia de datos que unifica preparación de datos, entrenamiento, validación y despliegue de modelos con herramientas para gobernanza y monitorización.

¿Para qué sirve SageMaker?

Sirve para acelerar el ciclo de vida de proyectos de IA: desde la ingestión y etiquetado de datos hasta el entrenamiento distribuido, la puesta en producción y la monitorización continua de modelos.

¿Cuánto cuesta usar SageMaker?

El coste depende del tipo de instancia, horas de entrenamiento, uso de endpoints de inferencia y almacenamiento; se factura por uso (pay-as-you-go) y puede reducirse con instancias Spot, serverless inference o multi-model endpoints.

¿Cómo empezar con SageMaker?

Empieza creando un proyecto en SageMaker Studio, usa JumpStart para prototipos, prepara datos con Data Wrangler y registra versiones en el Model Registry antes de desplegar un endpoint de prueba.

¿Qué frameworks y librerías soporta?

Soporta TensorFlow, PyTorch, Scikit-learn, MXNet y contenedores personalizados, lo que facilita portar cargas existentes sin reescribir código.

¿Puedo entrenar modelos a gran escala en SageMaker?

Sí: ofrece entrenamiento distribuido, instancias GPU multinodo, checkpointing a S3 y opciones para usar Spot Instances para reducir costes en entrenamientos largos.

¿Qué opciones de despliegue e inferencia ofrece?

Ofrece endpoints en tiempo real, batch transform para lotes, serverless inference para cargas esporádicas y SageMaker Neo para optimizar modelos en edge y dispositivos heterogéneos.

¿Cómo gestiona SageMaker la seguridad y el cumplimiento?

Integra IAM, cifrado en tránsito y en reposo, compatibilidad con VPC y claves gestionadas por el cliente (KMS) para cumplir requisitos regulatorios y de soberanía de datos.

¿Qué herramientas incluye para MLOps y gobernanza?

Incluye SageMaker Pipelines, Model Registry, seguimiento de experimentos, trazabilidad de artefactos y reglas de promoción que facilitan CI/CD para modelos y auditorías.

¿Cómo funciona el etiquetado de datos en SageMaker?

Ground Truth combina etiquetado humano, aprendizaje activo y autoetiquetado con controles de calidad para crear datasets anotados a escala.

¿Cómo detectar y mitigar sesgos y explicar modelos?

SageMaker Clarify proporciona métricas de equidad, detección de sesgos y explicaciones (p. ej. SHAP) tanto locales como globales para interpretar decisiones y cumplir normativas.

¿Qué alternativas existen a SageMaker?

Alternativas gestionadas incluyen Google Vertex AI, Azure Machine Learning y soluciones open-source como Kubeflow; la elección depende de la integración con nube, requisitos de coste y estrategia multi-cloud.

¿Es SageMaker adecuado para una PYME?

Para proyectos que buscan rapidez y escalabilidad, sí—especialmente usando JumpStart y configuraciones serverless—pero equipos pequeños deben valorar la curva de aprendizaje y la necesidad de gobernanza para no incurrir en costes inesperados.

¿Cómo puedo reducir los costes al usar SageMaker?

Aplica Spot Instances para entrenamiento, usa multi-model endpoints, activa apagado automático, monitoriza el uso y considera serverless inference para cargas no continuas.

¿Qué ventajas aporta el Feature Store?

El Feature Store garantiza consistencia entre entrenamiento e inferencia mediante features versionadas, reduce duplicidad de lógica y ofrece serving de baja latencia para aplicaciones en producción.

Referencias

Página oficial de Amazon SageMaker: https://aws.amazon.com/sagemaker/

- Printer-friendly version

- Log in to post comments