Google Vertex AI es la plataforma unificada de inteligencia artificial (IA) y machine learning (ML) de Google Cloud, diseñada para simplificar el ciclo de vida completo de modelos y proyectos de data science. Su propuesta principal es integrar en un solo entorno las fases de preparación de datos, entrenamiento de modelos, evaluación, despliegue y monitorización, reduciendo la complejidad de trabajar con múltiples herramientas aisladas. Vertex AI combina infraestructura escalable de Google con servicios gestionados, lo que permite a equipos técnicos centrarse más en la experimentación y menos en la administración.

La plataforma ofrece soporte tanto para modelos personalizados como para modelos preentrenados, incluyendo modelos generativos de última generación. Gracias a su integración nativa con otros servicios de Google Cloud, como BigQuery, Dataproc o Looker, facilita la conexión con fuentes de datos, el análisis a gran escala y la construcción de aplicaciones basadas en IA de manera ágil. Vertex AI también incluye herramientas de MLOps para gestionar la trazabilidad, versionado y automatización de pipelines, lo que refuerza la gobernanza y el cumplimiento en entornos corporativos.

Un punto destacado es su enfoque en la accesibilidad: Vertex AI ofrece una interfaz gráfica intuitiva para usuarios de negocio o analistas, y a la vez expone APIs y SDKs para perfiles más técnicos. Esto permite que diferentes roles dentro de la organización colaboren en la misma plataforma. La flexibilidad para trabajar en modo “low-code” o con programación avanzada convierte a Vertex AI en una opción versátil para empresas que buscan acelerar la adopción de soluciones de IA sin sacrificar control ni personalización.

Funcionalidades principales de Google Vertex AI

AutoML

Vertex AI ofrece AutoML, una funcionalidad que permite a usuarios sin conocimientos avanzados de programación o machine learning entrenar modelos personalizados a partir de sus propios datos. Con esta herramienta se pueden crear modelos de clasificación de imágenes, procesamiento de lenguaje natural (NLP) o predicciones tabulares de manera automatizada, optimizando arquitecturas y parámetros de forma transparente. Esto acelera la adopción de IA en empresas con equipos reducidos o perfiles más cercanos al negocio.

Entrenamiento de modelos personalizados

Además de AutoML, Vertex AI soporta el entrenamiento de modelos avanzados desarrollados con frameworks como TensorFlow, PyTorch o scikit-learn. El servicio gestiona la infraestructura subyacente, permitiendo escalar el entrenamiento en GPUs y TPUs sin que el usuario tenga que administrar servidores. Esto resulta esencial en proyectos de deep learning que requieren un alto poder de cómputo.

MLOps y pipelines

Con Vertex AI, los equipos pueden implementar MLOps de forma nativa gracias a su sistema de pipelines. Estos permiten automatizar tareas como el preprocesamiento de datos, el entrenamiento, la validación y el despliegue de modelos. Incluye funciones de versionado de datasets y modelos, seguimiento de experimentos y control de drift de datos, lo que asegura la trazabilidad y la gobernanza de proyectos en producción.

Despliegue y predicciones

Una vez entrenado, un modelo puede ser desplegado como un endpoint escalable dentro de Vertex AI. Esto habilita la realización de predicciones en tiempo real o en batch, con balanceo de carga automático y monitorización del rendimiento. Esta capacidad reduce los tiempos de entrega en aplicaciones empresariales que requieren IA en producción, como sistemas de recomendación, detección de anomalías o procesamiento de lenguaje natural.

Modelos generativos y preentrenados

Vertex AI integra el acceso a modelos generativos y modelos preentrenados de Google, como los de visión, lenguaje y conversación. Esto permite a los desarrolladores utilizar directamente APIs de IA generativa para construir aplicaciones de chatbots, resúmenes automáticos, traducción o análisis de sentimientos, sin necesidad de entrenar desde cero. Esta funcionalidad es clave para acelerar el desarrollo de aplicaciones de nueva generación.

Integración con BigQuery y fuentes de datos

Un valor diferencial de Vertex AI es su integración nativa con BigQuery, lo que facilita la extracción y transformación de datos a gran escala. También se conecta con Dataflow, Dataproc y otros orígenes de datos de Google Cloud, lo que elimina la fricción habitual en la preparación de datasets para entrenamiento. Esta interoperabilidad reduce los tiempos de preparación y permite trabajar con millones de registros de manera fluida.

Interfaz gráfica, APIs y SDKs

Vertex AI combina una interfaz gráfica intuitiva para usuarios no técnicos con APIs REST y SDKs en Python para desarrolladores. Esto crea un entorno de trabajo híbrido donde perfiles de data scientists, analistas y desarrolladores pueden colaborar en el mismo proyecto. La flexibilidad de trabajar en modo low-code o con código avanzado garantiza que la plataforma se adapte a diferentes niveles de madurez en IA.

Monitorización y seguridad

La plataforma incluye mecanismos de monitorización continua de modelos en producción, con alertas sobre desviaciones de rendimiento y drift de datos. Además, aprovecha la infraestructura de seguridad de Google Cloud, incorporando controles de acceso, auditoría y cumplimiento de normativas. Esto es crucial en sectores regulados como finanzas o salud, donde la confianza y el control sobre los modelos son obligatorios.

Reseña técnica de Vertex AI

Vertex AI es la plataforma unificada de Google Cloud orientada a cubrir de forma integral el ciclo de vida de proyectos de IA, Data Science y Machine Learning. En una sóla interfaz combina herramientas de entrenamiento (AutoML y entrenamiento personalizado), despliegue y monitorización, además de acceso a modelos y servicios de Generative AI y al catálogo de modelos de Google.

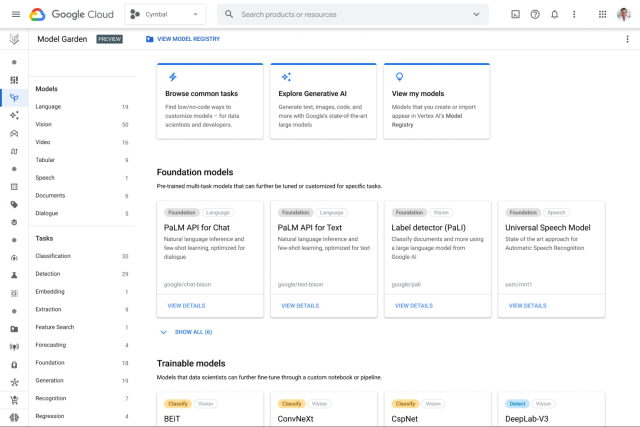

Arquitectónicamente, la propuesta gira en torno a módulos que facilitan la industrialización de modelos: Vertex AI Studio como área de trabajo, Model Registry para gestionar versiones, Feature Store para centralizar y servir características en línea y por lotes, y Pipelines para orquestar flujos reproducibles y auditables. Esa combinación permite trazar la lineage de artefactos, reproducir experimentos y mantener consistencia entre entrenamiento y serving. Los documentos oficiales detallan estas piezas y su integración con BigQuery y el resto de GCP.

En la práctica, Vertex AI ofrece dos caminos de trabajo: AutoML para equipos que buscan resultados rápidos sin entrar en el detalle del código, y custom training que admite contenedores y SDKs para quienes necesitan control fino sobre arquitecturas y optimizaciones. La plataforma incluye SDKs (por ejemplo, para Python) y soporte para frameworks populares, lo que facilita portar cargas heredadas y escalar entrenamiento con recursos gestionados.

La capacidad de orquestación y gobernanza es uno de sus puntos fuertes: Vertex AI Pipelines automatiza fases de preparación, entrenamiento y validación, almacena metadatos y facilita la inspección de runs y artefactos, lo que ayuda a implantar prácticas de MLOps reproducibles y auditables. Esto resulta especialmente útil en entornos regulados donde conviene demostrar trazabilidad.

Para la operativa en producción, la plataforma incorpora mecanismos de monitorización (deriva de datos, degradación de métricas), serving tanto en tiempo real como por lotes, y herramientas de explicabilidad que facilitan el análisis de decisiones del modelo. Esa capa reduce el riesgo de “drift” inadvertido y acelera la detección de regresiones tras un despliegue.

En el ámbito de Generative AI y LLMs, Vertex AI expone el Model Garden y soporte para modelos multimodales como Gemini, además de incorporar novedades de Google en modelos especializados para tareas como visión, texto y código; recientemente se han añadido capacidades de generación de vídeo (modelos Veo 3 / Veo 3 Fast) y se ha anunciado integración de terceros para ampliar la oferta de modelos. Esto convierte a la plataforma en una opción competitiva para proyectos que demandan generación de contenido a escala.

A nivel de integración, Vertex AI se conecta nativamente con BigQuery, Cloud Storage, IAM y redes VPC, lo que facilita incorporar pipelines que procesan datos a gran escala y mantienen controles de acceso centralizados. También existe soporte para bibliotecas y ecosistemas externos (por ejemplo, integración con Ray para escalado de entrenamiento), lo que simplifica la migración de cargas desde arquitecturas distribuidas.

No obstante, hay contrapartidas relevantes. La adopción intensiva puede implicar vendor-lock-in por la dependencia de APIs, formatos y servicios gestionados; la estructura de costes resulta compleja en proyectos con alto uso de entrenamiento y despliegues constantes; y la curva de aprendizaje para dominar pipelines, seguridad y optimización de costes exige inversión en talento. Para organizaciones con requerimientos estrictos de on-premise o latencia ultra-baja, parte de la flexibilidad se reduce frente a soluciones híbridas o self-hosted.

En resumen, Vertex AI aporta un stack maduro para acelerar la transición de prototipos a producción gracias a su integración con GCP, capacidades de MLOps y acceso a modelos generativos avanzados. Recomendable si la prioridad es escalar proyectos con control operativo y aprovechar modelos gestionados; menos aconsejable si el requisito principal es evitar dependencia de proveedor o maximizar control sobre infraestructura física. Para equipos técnicos que valoran trazabilidad, automatización y acceso a modelos de última generación, Vertex AI constituye una plataforma robusta para desplegar IA empresarial.

Tabla resumen de fortalezas y debilidades de Google Vertex AI

| Aspecto | Puntos fuertes | Puntos débiles |

|---|---|---|

| Integración | Conexión nativa con BigQuery, Dataproc, Dataflow, Looker | Dependencia fuerte del ecosistema Google Cloud, menos flexible en escenarios multicloud/híbridos |

| Plataforma | Entorno unificado: datos, entrenamiento, despliegue y monitorización en un solo lugar | Complejidad inicial: curva de aprendizaje alta para equipos nuevos en Google Cloud |

| Rendimiento | Escalabilidad con TPUs y GPUs, infraestructura optimizada de Google | Costes elevados en cargas intensivas de entrenamiento o grandes volúmenes de datos |

| MLOps | Pipelines, versionado, gestión de experimentos, monitorización de drift | Requiere expertise técnico para sacar todo el provecho de las funciones avanzadas |

| Modelos | Soporte para AutoML, modelos generativos y preentrenados | Catálogo más limitado frente a repositorios abiertos como Hugging Face |

| Usabilidad | Combina interfaz low-code/no-code con APIs y SDKs para desarrolladores | Comunidad externa menos madura que en ecosistemas open source |

Licenciamiento e instalación

En cuanto al licenciamiento, Vertex AI utiliza un modelo de pago por uso integrado en las suscripciones de Google Cloud; respecto al tamaño de empresa, resulta idóneo para medianas y grandes empresas que requieren escalabilidad y recursos avanzados, aunque también dispone de opciones accesibles para pymes.

En lo que se refiere al tipo de instalación, está completamente gestionado en la nube, sin versión on-premise, aunque ofrece SDKs para entornos híbridos.

Preguntas frecuentes sobre Vertex AI

¿Qué es Vertex AI?

Resumen: Plataforma de Google Cloud para diseñar, entrenar, desplegar y monitorizar modelos de IA a escala.

Vertex AI centraliza herramientas de MLOps, AutoML y entrenamiento personalizado, conectando servicios como BigQuery, Cloud Storage e IAM para facilitar la producción de modelos en entornos empresariales.

¿Para qué sirve Vertex AI?

Resumen: Para transformar datos en modelos desplegables que generan predicciones y aplicaciones de IA.

Se utiliza en todo el ciclo: ingesta y etiquetado de datos, experimentación, gestión de características (Feature Store), orquestación de pipelines, serving en tiempo real y monitorización de deriva y rendimiento.

¿Vertex AI incluye AutoML?

Resumen: Sí: ofrece rutas AutoML para crear modelos sin escribir código avanzado.

AutoML en Vertex AI facilita entrenar modelos para clasificación, regresión y visión, con pipelines gestionados y tuning automático de hiperparámetros; ideal para equipos con menor especialización en ML.

¿Qué frameworks y lenguajes soporta?

Resumen: Soporte nativo para TensorFlow, PyTorch y SDKs en Python; admite contenedores personalizados.

Los usuarios pueden ejecutar código propio en contenedores Docker, usar los SDKs Python de Vertex o integrar frameworks externos (ej. Ray) para escalado distribuido y trabajos de entrenamiento a medida.

¿Cómo se compara Vertex AI con AWS SageMaker o Azure ML?

Resumen: Competidor directo: similar en funcionalidad, con ventaja en integración GCP y acceso a modelos Google.

Elegir entre ellos depende de la nube corporativa dominante, requisitos de integración (BigQuery vs S3/Azure Data Lake), tolerancia al vendor-lock-in y particularidades de precios y servicios gestionados.

¿Cuánto cuesta usar Vertex AI?

Resumen: El coste varía: hay cargos por entrenamiento, serving, almacenamiento y servicios gestionados.

La facturación combina tarifas de cómputo (CPUs/GPUs/TPUs), almacenamiento, tráfico y funciones gestionadas (Feature Store, Pipelines). Conviene estimar cargas de entrenamiento y serving y monitorizar costes con presupuestos y alertas.

¿Vertex AI causa vendor-lock-in?

Resumen: Existe riesgo de vendor-lock-in por dependencias de APIs y servicios GCP.

Usar formatos abiertos, contenedores personalizados y separar datos (ej. BigQuery vs exportaciones) reduce el acoplamiento, pero funcionalidades propietarias (Model Garden, management APIs) incrementan la dependencia de Google Cloud.

¿Se puede usar Vertex AI on-premises o en ambientes híbridos?

Resumen: No es nativo on-prem; ofrece integraciones híbridas pero la experiencia plena requiere GCP.

Para entornos estrictos on-premise conviene explorar soluciones híbridas (Anthos, exportar modelos en contenedores) o combinar Vertex AI con infraestructuras locales para cumplir latencia y requisitos de datos sensibles.

¿Qué es el Feature Store en Vertex AI y por qué importa?

Resumen: Repositorio para gestionar y servir características consistentes entre entrenamiento y producción.

Un Feature Store garantiza que las mismas transformaciones y versiones de variables usadas en entrenamiento lleguen al serving, reduciendo errores por inconsistencias y mejorando reproducibilidad y trazabilidad.

¿Cómo monitorizar y detectar deriva (drift) en Vertex AI?

Resumen: Vertex integra monitorización de métricas y detección de deriva para modelos en producción.

Se configuran alertas sobre métricas clave, comparaciones entre distribuciones de entrenamiento y producción, y pipelines de reentrenamiento automatizado para responder a degradaciones de rendimiento.

¿Vertex AI soporta modelos de terceros y LLMs (Model Garden)?

Resumen: Sí: incluye un catálogo (Model Garden) y soporte para modelos gestionados, incluidos LLMs.

El catálogo facilita probar y desplegar LLMs y modelos multimodales (texto, visión), además de posibilitar integración de modelos externos mediante contenedores o APIs compatibles.

¿Cómo empezar con Vertex AI si tengo un pipeline en producción?

Resumen: Evaluar dependencias, exportar artefactos y plantear migración por fases con pruebas y control de costes.

Recomiendo mapear fuentes de datos, exportar modelos a contenedores, probar serving en entornos de staging, y automatizar pipelines con Vertex AI Pipelines para minimizar riesgos. Una migración por fases facilita comparación de rendimiento y costes.

Referencias

-

Página oficial de Vertex AI (Google Cloud): https://cloud.google.com/vertex-ai

- Printer-friendly version

- Log in to post comments