Introducción a Apache Spark

- Lee más sobre Introducción a Apache Spark

- Inicie sesión para enviar comentarios

Hoy vamos a hacer una introducción a Apache Spark, el nuevo motor del Big Data, se trata de un framework de computación paralela enfocando especialmente hacia la ciencia de datos.

Hay que destacar que Spark lleva incluidas librerías específicas para tratar datos estructurados (SparkSQL), integración con lenguaje R (Spark R), capacidades para el streaming de datos (Spark Streaming), machine learning (MLib) y computación sobre grafos (GraphX).

Esta primera introducción es una guía para su instalación, conceptos, estructura y el primer contacto que tendremos será la implementación de un Clúster Standalone con PySpark, las aplicaciones se ejecutan como un grupo independiente de procesos en el Cluster, dirigido por el programa principal.

El escándalo por las revelaciones de que Estados Unidos espía las comunicaciones y contenidos online de usuarios de todo el mundo mediante el programa Prism ha llevado a muchos usuarios a plantearse si su privacidad está a salvo en Internet. Te damos algunos consejos fáciles de aplicar para protegerte..

El escándalo por las revelaciones de que Estados Unidos espía las comunicaciones y contenidos online de usuarios de todo el mundo mediante el programa Prism ha llevado a muchos usuarios a plantearse si su privacidad está a salvo en Internet. Te damos algunos consejos fáciles de aplicar para protegerte..

.png) Con los nuevos tiempos surgen nuevas profesiones, o nuevas maneras de orientar profesiones ya existentes, y con la llegada de los Big Data la figura del analista de la información 'se reinventa', como dicen ahora, para convertirse en Experto en Big Data, que por lo que parece puede llegar a estar muy bien reconocido según esta infografía de FICO..

Con los nuevos tiempos surgen nuevas profesiones, o nuevas maneras de orientar profesiones ya existentes, y con la llegada de los Big Data la figura del analista de la información 'se reinventa', como dicen ahora, para convertirse en Experto en Big Data, que por lo que parece puede llegar a estar muy bien reconocido según esta infografía de FICO.. Si miramos alrededor nuestro, vemos que cualquier dispositivo que usamos genera datos, estos pueden ser analizados actualmente. De esta gran cantidad de datos que tenemos a nuestro alcance, sólo el 20% se trata de información estructura y el 80% son datos no estructurados. Estos últimos añaden complejidad en la forma que se tienen que almacenar y analizar.

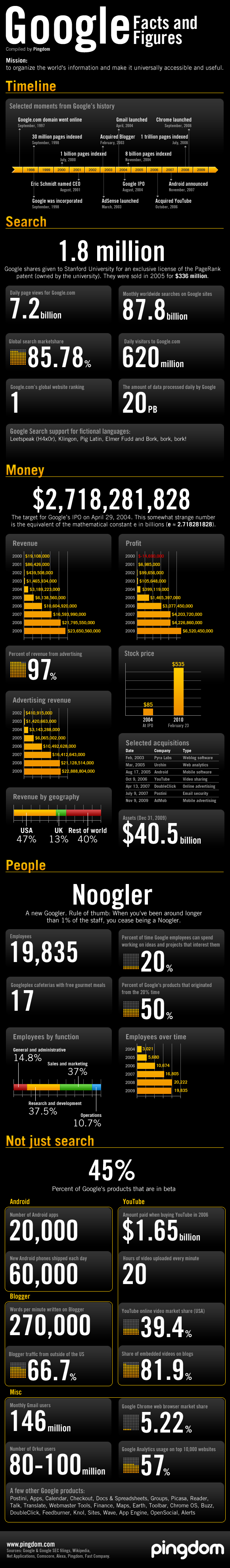

Si miramos alrededor nuestro, vemos que cualquier dispositivo que usamos genera datos, estos pueden ser analizados actualmente. De esta gran cantidad de datos que tenemos a nuestro alcance, sólo el 20% se trata de información estructura y el 80% son datos no estructurados. Estos últimos añaden complejidad en la forma que se tienen que almacenar y analizar. Para hacerte una idea del volumen de negocio que mueve Google nada mejor que la infografia que han preparado en pingdom, en la que recopilan en un mismo gráfico una timeline con los principales hitos de la compañia, impresionantes cifras sobre el buscador, evolución de los beneficios, cifras sobre los empleados de la compañía, y los datos más significativos sobre otros productos de éxito como Android, YouTube, Blogger, Gmail, Chrome, Orkut o Analytics.

Para hacerte una idea del volumen de negocio que mueve Google nada mejor que la infografia que han preparado en pingdom, en la que recopilan en un mismo gráfico una timeline con los principales hitos de la compañia, impresionantes cifras sobre el buscador, evolución de los beneficios, cifras sobre los empleados de la compañía, y los datos más significativos sobre otros productos de éxito como Android, YouTube, Blogger, Gmail, Chrome, Orkut o Analytics.