Manual para la solución de errores en las herramientas XAMPP, Pentaho y Saiku

Recomiendo un articulo en el cual se instalarán paso a paso las aplicaciones que se listan en la Figura 1, además de contener el detalle de despliegue y configuración inicial, se realiza un reporte de posibles errores y sus respectivas soluciones, a mi criterio es el último punto el valor agregado más grande de este documento.

Recomiendo un articulo en el cual se instalarán paso a paso las aplicaciones que se listan en la Figura 1, además de contener el detalle de despliegue y configuración inicial, se realiza un reporte de posibles errores y sus respectivas soluciones, a mi criterio es el último punto el valor agregado más grande de este documento.

.png) Una de las herramientas más maduras en el mundo Big Data es el framework de licencia libre Apache Hadoop. En este post exponemos de forma resumida la integración entre Hadoop y uno de los fabricantes líder en analítica de negocio: SAS.

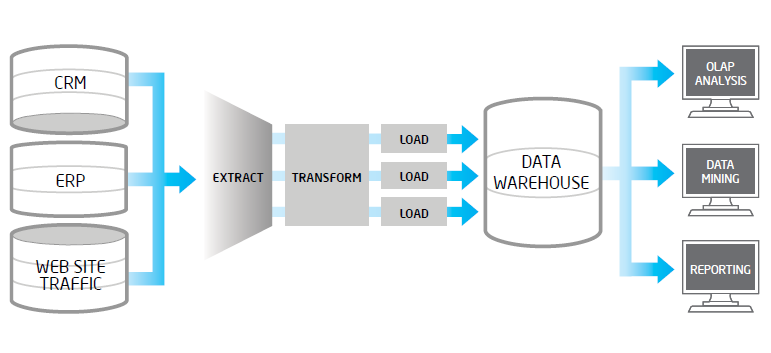

Una de las herramientas más maduras en el mundo Big Data es el framework de licencia libre Apache Hadoop. En este post exponemos de forma resumida la integración entre Hadoop y uno de los fabricantes líder en analítica de negocio: SAS. En el presente post pretendemos mostrar la problemática que con frecuencia encontramos en los procesos de extracción, validación y carga de datos en los entornos Big Data. Un proceso ETL tradicional, extrae datos desde múltiples fuentes origen, después los valida, normaliza, realiza determinadas transformaciones y vuelca los mismos en un entorno datawarehouse para su posterior análisis. Cuando en los datos fuentes, tenemos volúmenes altos, una frecuencia de actualización alta en origen o bien son datos no estructurados, estos procesos ETL suelen tener problemas..

En el presente post pretendemos mostrar la problemática que con frecuencia encontramos en los procesos de extracción, validación y carga de datos en los entornos Big Data. Un proceso ETL tradicional, extrae datos desde múltiples fuentes origen, después los valida, normaliza, realiza determinadas transformaciones y vuelca los mismos en un entorno datawarehouse para su posterior análisis. Cuando en los datos fuentes, tenemos volúmenes altos, una frecuencia de actualización alta en origen o bien son datos no estructurados, estos procesos ETL suelen tener problemas..  En muchas ocasiones nos encontramos en las compañías, información equivalente generada por diferentes departamentos, que aunque tenga diferentes matices y perspectivas de análisis (Ventas, Marketing, Control de Gestión) la información en su base debe ser la misma. Es habitual encontrarse con discrepancias, lo que nos hace dudar de la fiabilidad del dato y de los sistemas B.I. que los sustentan. Lo deseable es siempre disponer de maestros de datos que sirvan de fuente para todos los departamentos y de procesos sistemáticos de calidad del dato que garanticen su consistencia, integridad y trazabilidad.

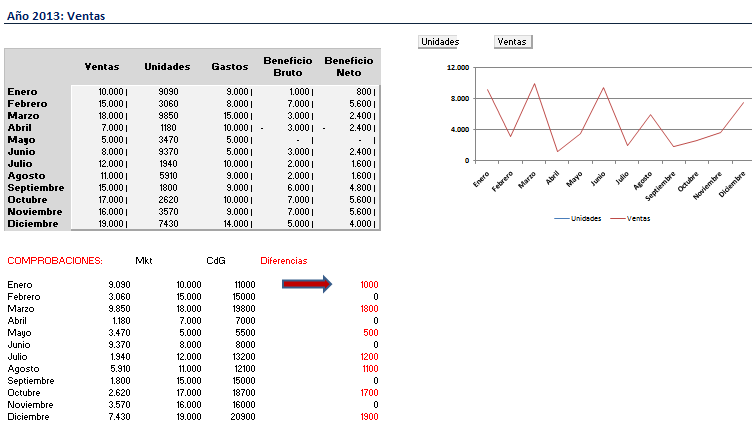

En muchas ocasiones nos encontramos en las compañías, información equivalente generada por diferentes departamentos, que aunque tenga diferentes matices y perspectivas de análisis (Ventas, Marketing, Control de Gestión) la información en su base debe ser la misma. Es habitual encontrarse con discrepancias, lo que nos hace dudar de la fiabilidad del dato y de los sistemas B.I. que los sustentan. Lo deseable es siempre disponer de maestros de datos que sirvan de fuente para todos los departamentos y de procesos sistemáticos de calidad del dato que garanticen su consistencia, integridad y trazabilidad.

.jpg)

Febrero se acaba con un nuevo sorteo! Conseguir uno de los 3 ejemplares del libro 'Busines Intelligence with MicroStrategy' es muy fácil! En este post de explicamos como! Sigue las instrucciones y... mucha suerte!

Febrero se acaba con un nuevo sorteo! Conseguir uno de los 3 ejemplares del libro 'Busines Intelligence with MicroStrategy' es muy fácil! En este post de explicamos como! Sigue las instrucciones y... mucha suerte!