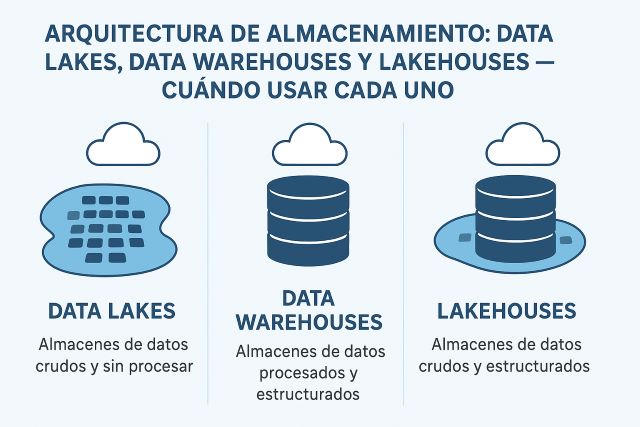

Arquitectura de almacenamiento: data lakes, data warehouses y lakehouses — cuándo usar cada uno

La decisión entre data lake, data warehouse o lakehouse no es una mera elección tecnológica: define cómo su organización almacenará, procesará y extraerá valor de los datos durante los próximos años. Esta arquitectura condiciona los tiempos de acceso, los costes operativos, la agilidad analítica y, en última instancia, la capacidad competitiva de la empresa.

Puntos clave que vamos a tratar:

- Las características fundamentales, ventajas y limitaciones de cada arquitectura

- Criterios técnicos y de negocio para seleccionar la estrategia adecuada

- Patrones híbridos y arquitecturas convergentes (lakehouse)

- Migración y coexistencia de múltiples paradigmas

- Errores comunes y antipatrones que debe evitar..

This article will describe the relevance of open source software and big data before describing five interesting and useful open source big data tools and projects.

This article will describe the relevance of open source software and big data before describing five interesting and useful open source big data tools and projects. Hoy vamos a hacer una introducción a Apache Spark, el nuevo motor del Big Data, se trata de un framework de computación paralela enfocando especialmente hacia la ciencia de datos.

Hoy vamos a hacer una introducción a Apache Spark, el nuevo motor del Big Data, se trata de un framework de computación paralela enfocando especialmente hacia la ciencia de datos.