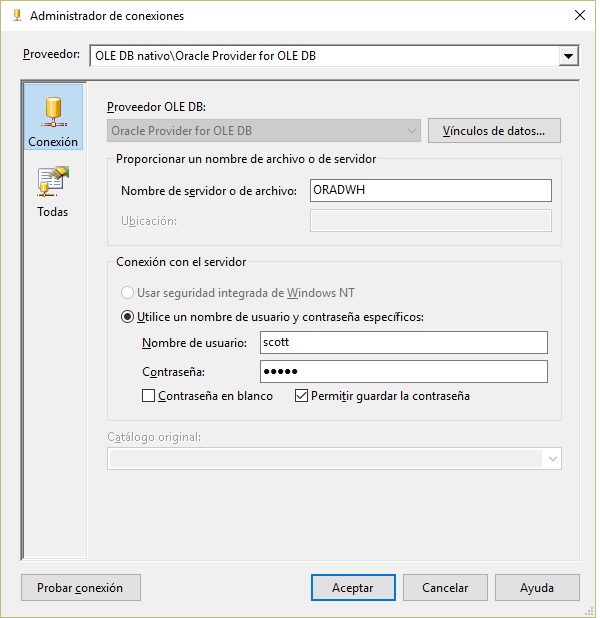

Cómo conectar desde Visual Studio y SSIS con bases de datos Oracle

- Lee más sobre Cómo conectar desde Visual Studio y SSIS con bases de datos Oracle

- Inicie sesión para enviar comentarios

Conectar flujos de datos de Integration Services con bases de datos Oracle es muy sencillo, siempre que tengas bien configurado el driver de Oracle que te va a permitir esta conexión.

Conectar flujos de datos de Integration Services con bases de datos Oracle es muy sencillo, siempre que tengas bien configurado el driver de Oracle que te va a permitir esta conexión.

Los drivers que vienen por defecto no suelen funcionar bien para conectar con Oracle, y lo más recomendable es instalar y utilizar los conectores que proporciona Oracle, el famoso cliente de Oracle, tanto para trabajar con SQL Server Integration Services, como para crear aplicaciones directamente con Visual Studio..

La gestión de los datos no estructurados se ha convertido en uno de los principales retos a los que hacen frente las compañías en lo relativo a gestión de información y Big Data. En este post damos una breve introducción al tratamiento de los mismos y las problemáticas más comunes en su gestión..

La gestión de los datos no estructurados se ha convertido en uno de los principales retos a los que hacen frente las compañías en lo relativo a gestión de información y Big Data. En este post damos una breve introducción al tratamiento de los mismos y las problemáticas más comunes en su gestión..

.jpg)