Herramientas ETL 2026: Guía Completa - Comparativa, Precios y Cómo Elegir

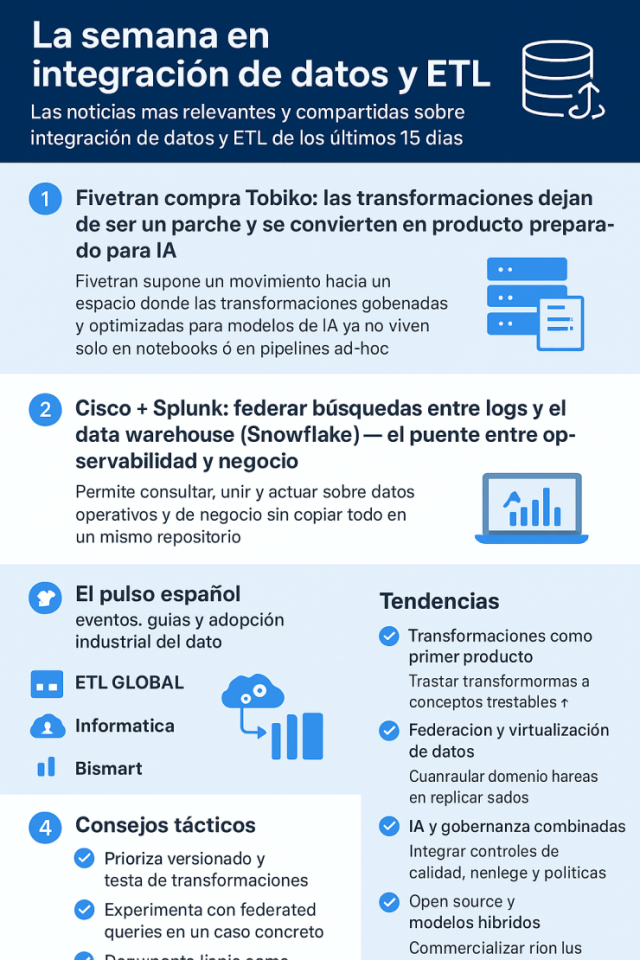

Las herramientas ETL son el pilar fundamental de cualquier estrategia de datos moderna. En un mundo donde se generan 463 exabytes de datos diariamente, elegir la herramienta ETL correcta puede marcar la diferencia entre insights accionables y un caos de datos dispersos.

En esta guía comparamos las mejores herramientas ETL de 2026, analizamos sus características, precios y te ayudamos a elegir la más adecuada para tu proyecto de Data Warehouse o Big Data..

Hace ya algún tiempo tuve la oportunidad de probar el software de Business Intelligence Crono, pero ha llovido bastante, y Crono ha evolucionado mucho desde entonces, así que aprovecho este post para ponerme al día sobre las nuevas características de este software de BI, y ahora también de ETL..

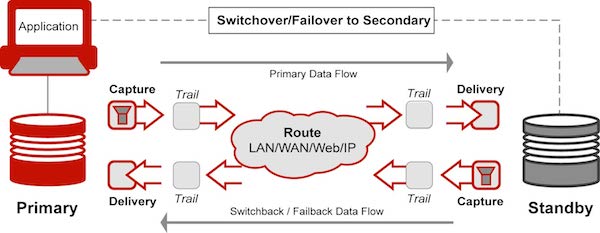

Hace ya algún tiempo tuve la oportunidad de probar el software de Business Intelligence Crono, pero ha llovido bastante, y Crono ha evolucionado mucho desde entonces, así que aprovecho este post para ponerme al día sobre las nuevas características de este software de BI, y ahora también de ETL.. Respuestas a 50 importantes cuestiones sobre Oracle GoldenGate, la ETL de Oracle para integración de datos de bases de datos heterogéneas en tiempo real.

Respuestas a 50 importantes cuestiones sobre Oracle GoldenGate, la ETL de Oracle para integración de datos de bases de datos heterogéneas en tiempo real. Los procesos ETL (Extracción, Transformación y Carga) son un elemento clave para la construcción y mantenimiento de sistemas de Data Warehouse en entornos de Business Intelligence.

Los procesos ETL (Extracción, Transformación y Carga) son un elemento clave para la construcción y mantenimiento de sistemas de Data Warehouse en entornos de Business Intelligence.