Azure Machine Learning es una plataforma en la nube de Microsoft diseñada para facilitar el desarrollo, entrenamiento, despliegue y gestión de modelos de inteligencia artificial (IA), ciencia de datos (Data Science) y aprendizaje automático (Machine Learning). Se integra de forma nativa con otros servicios de Azure, lo que permite a las organizaciones trabajar con entornos híbridos y escalar desde pruebas iniciales hasta soluciones empresariales en producción.

Uno de los principales puntos diferenciales de la plataforma es la combinación de herramientas de bajo código/no código con entornos avanzados de programación. Esto ofrece flexibilidad tanto a perfiles técnicos especializados como a analistas o científicos de datos que requieren rapidez en la creación de prototipos. Además, incluye funcionalidades como AutoML, que permite generar modelos de forma automatizada, y MLOps, para gestionar el ciclo de vida completo del modelo con buenas prácticas de integración y despliegue continuo.

En el plano empresarial, Azure Machine Learning destaca por su enfoque en seguridad, cumplimiento normativo y escalabilidad. Está diseñado para integrarse con sistemas de datos corporativos, aprovechar la infraestructura en la nube y garantizar la trazabilidad de los modelos. Esto lo convierte en una solución robusta para organizaciones que buscan no solo experimentar con IA, sino llevar proyectos de machine learning a entornos productivos de manera controlada y alineada con las necesidades del negocio.

Funcionalidades principales de Azure Machine Learning

Entornos de desarrollo flexibles

Azure Machine Learning ofrece entornos de desarrollo que combinan interfaces de bajo código con herramientas avanzadas de programación, permitiendo a distintos perfiles trabajar de manera eficiente. Los usuarios pueden utilizar Azure Machine Learning Studio para construir modelos de forma visual, o bien integrarse con Jupyter Notebooks y SDKs de Python y R para un control completo del flujo. Esta dualidad facilita la colaboración entre científicos de datos, desarrolladores y analistas de negocio, garantizando que todos puedan trabajar en un mismo ecosistema sin barreras técnicas.

Automated Machine Learning (AutoML)

La funcionalidad de AutoML permite crear modelos de machine learning de manera automatizada, seleccionando los mejores algoritmos y parámetros sin necesidad de un conocimiento profundo en programación o estadística. El sistema evalúa múltiples configuraciones y métricas para recomendar el modelo óptimo en cada caso de uso, reduciendo tiempos de experimentación y errores. Esto es especialmente útil en proyectos donde la velocidad de entrega y la precisión del modelo son fundamentales, como en la predicción de series temporales, clasificación de imágenes o análisis de texto.

MLOps e integración continua

Una de las mayores fortalezas de Azure Machine Learning es su enfoque en MLOps, que combina prácticas de DevOps con la gestión del ciclo de vida de los modelos. Con esta funcionalidad, es posible realizar versionado de modelos, monitorización en producción, detección de desviaciones de datos y reentrenamiento automatizado. Además, se integra con herramientas como Azure DevOps y GitHub Actions, lo que asegura que los flujos de desarrollo y despliegue sean consistentes y escalables, facilitando la gobernanza de proyectos de IA a gran escala.

Gestión de datasets y etiquetado de datos

La plataforma incorpora potentes herramientas de gestión de datasets, permitiendo organizar, versionar y reutilizar datos en distintos experimentos. Además, ofrece servicios de data labeling que permiten crear, validar y optimizar conjuntos de datos etiquetados para entrenar modelos supervisados. Este enfoque garantiza la trazabilidad de los datos y su uso responsable, lo que es crucial en entornos empresariales donde el cumplimiento normativo y la calidad del dato son determinantes.

Escalabilidad y entrenamiento distribuido

Gracias a su integración con la infraestructura de Azure, los usuarios pueden ejecutar entrenamientos de modelos en clusters de GPU o CPU, aprovechando la potencia del cloud computing para acelerar los procesos. Azure Machine Learning permite configurar entrenamiento distribuido, lo que significa que un modelo puede ser entrenado en múltiples nodos en paralelo, reduciendo drásticamente los tiempos de procesamiento. Esta capacidad de escalar de forma flexible resulta clave para proyectos que requieren trabajar con grandes volúmenes de datos o algoritmos complejos de deep learning.

Integración con servicios de Azure y ecosistema externo

La plataforma está pensada para funcionar de manera integrada con otros servicios como Azure Data Lake, Azure Synapse Analytics, Power BI y Azure Cognitive Services, creando un ecosistema completo de análisis y visualización. Además, soporta frameworks y librerías de código abierto como TensorFlow, PyTorch, Scikit-learn y ONNX, lo que facilita la migración de proyectos existentes o la combinación de tecnologías. Esta flexibilidad permite que los equipos puedan diseñar soluciones de IA adaptadas a sus necesidades sin quedar bloqueados en un entorno cerrado.

Seguridad y cumplimiento normativo

Uno de los aspectos más valorados en Azure Machine Learning es su enfoque en seguridad, privacidad y cumplimiento regulatorio. La plataforma ofrece cifrado de datos en reposo y en tránsito, gestión de identidades con Azure Active Directory y soporte para estándares como GDPR, HIPAA o ISO 27001. Estas características garantizan que los proyectos de IA no solo sean técnicamente sólidos, sino también confiables desde el punto de vista legal y corporativo, lo que resulta esencial para sectores como la banca, la salud o las telecomunicaciones.

Reseña técnica de Azure Machine Learning

Azure Machine Learning constituye una plataforma en la nube diseñada para gestionar el ciclo de vida completo de proyectos de inteligencia artificial, ciencia de datos y machine learning, integrando recursos de almacenamiento, cómputo acelerado, orquestación de pipelines, registro de modelos y mecanismos de gobernanza que permiten pasar de prototipos a producción a escala empresarial.

Arquitectura y diseño: workspace y componentes

La arquitectura gira alrededor de un workspace que actúa como contenedor lógico para activos de datos, experimentos, modelos y endpoints; este workspace se apoya en recursos gestionados de Azure (storage, compute, redes y registros de contenedores) para aislar responsabilidades y facilitar la auditoría. Entre los activos clava destacar los Datasets, Environments, Jobs, Models y Endpoints, cada uno pensado para reproducibilidad y versionado del trabajo de ciencia de datos. La capacidad de definir environments reproducibles mediante imágenes de contenedor o especificaciones Conda simplifica la transferencia de trabajo entre estaciones de desarrollo y clústeres de entrenamiento.

El plano de control mantiene metadatos y trazabilidad: cada ejecución registra métricas, artefactos y logs que luego alimentan el registro de experimentos y el model registry, facilitando comparativas entre ejecuciones y análisis post-mortem cuando un modelo en producción sufre drift. Esta trazabilidad resulta crítica en sectores regulados donde la documentación del ciclo de vida del modelo no admite ambigüedades.

Experiencia de desarrollo: code-first y no-code convivientes

El producto abraza dos mundos: la experiencia code-first (Python SDK y CLI v2) y la experiencia no-code/low-code mediante Studio y Designer. Para equipos de ingenieros que programan, la SDK v2 ofrece una API declarativa para definir jobs, componentes y pipelines como código, lo que facilita la integración con repositorios Git y las prácticas de CI/CD. Para usuarios menos técnicos, la interfaz visual permite componer pipelines con módulos preconstruidos y lanzar experimentos desde el navegador sin necesidad de escribir scripts complejos. Esto reduce la fricción para equipos mixtos y acelera la iteración en fases de prototipado.

La interfaz web de Azure ML Studio centraliza la gestión de assets, la exploración de experimentos y el despliegue de endpoints, lo que resulta práctico para Product Owners y analistas que requieren visibilidad sin acceder a la consola de desarrollo. A nivel corporativo, esa interfaz facilita el control de accesos basado en roles y la delegación de tareas entre ciencia de datos y operaciones.

Automatización y AutoML: democratización con control

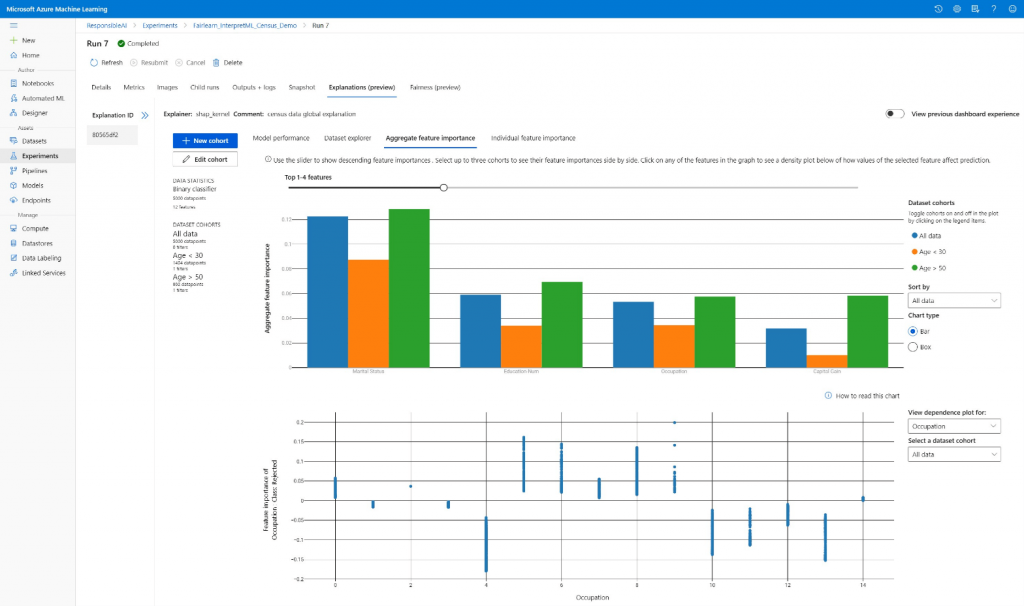

El módulo de AutoML permite generar pipelines candidato mediante búsquedas automatizadas sobre algoritmos, preprocesado y hiperparámetros, y añade explicabilidad básica sobre la importancia de features y comparativas entre runs. Su utilidad brilla en tareas estándar (clasificación, regresión, series temporales y visión por computador) donde acelerar el baseline resulta más valioso que exprimir cada décima de precisión con ingeniería manual. Para casos con restricciones de interpretabilidad o requisito de control fino sobre pasos de preprocesado, AutoML funciona como punto de partida para luego «industrializar» el mejor candidato.

AutoML incluye opciones para auditabilidad de las pruebas realizadas y para exportar pipelines resultantes como artefactos reproducibles, lo que facilita su incorporación en pipelines de validación y despliegue. En entornos donde la gobernanza manda, esto reduce la tentación de lanzar modelos a producción sin un rastro completo de decisiones y métricas.

Entrenamiento y escalabilidad: desde prototipos a modelos a gran escala

La plataforma admite entrenamiento en instancias GPU, clústeres gestionados y nodos multinodo para estrategias de entrenamiento distribuido; además ofrece patrones para trabajo embarrassingly parallel y para sincronización/parametrización distribuida, lo que permite tanto paralelizar búsquedas de hiperparámetros como entrenar redes neuronales de gran tamaño. La elección de tipos de máquina y el escalado automático aportan flexibilidad para ajustar coste vs. tiempo de entrenamiento.

Desde el punto de vista operativo, los compute targets funcionan como recursos reutilizables que pueden reservarse bajo demanda y compartirse entre proyectos. Para equipos que manejan cargas heterogéneas (desde modelos ligeros hasta entrenamientos con múltiples GPUs por nodo), esa capacidad reduce la duplicación de infra y facilita la gestión centralizada del gasto en cómputo.

Despliegue y MLOps: pipelines, registro y monitorización

La plataforma incorpora herramientas para construir pipelines reproducibles que encadenan preparación de datos, entrenamiento, evaluación y despliegue a endpoints gestionados. El Model Registry permite versionar artefactos, añadir metadatos y promover modelos entre estados (dev → staging → prod), mientras que las integraciones con GitHub Actions y Azure DevOps posibilitan flujos de CI/CD orientados a modelos. Estas capacidades constituyen la columna vertebral de un enfoque MLOps que no solo automatiza despliegues, sino que instrumenta el monitoreo de inferencia (latencia, errores, métricas de negocio) y la detección de drift.

La monitorización incluye recolección de telemetría y posibilidad de reentrenamiento programado o por evento, lo que reduce el tiempo medio hasta la corrección cuando un modelo deja de cumplir sus objetivos. En producción, los endpoints gestionados abstraen la infraestructura subyacente, aunque equipos con requisitos de latencia extrema o cumplimiento estricto pueden optar por despliegues en contenedores autoproporcionados.

Seguridad, cumplimiento y arquitecturas híbridas

En seguridad, la plataforma integra servicios de Azure como Azure Key Vault para gestión de secretos, Virtual Networks para segmentación de tráfico y control de acceso a recursos, y Azure Container Registry para almacenar imágenes. Para organizaciones con requisitos regulatorios se habilitan controles de auditoría, cifrado en reposo y en tránsito, y mecanismos de acceso basado en roles que facilitan demostrar cumplimiento. En entornos que demandan ejecución on-premises o en múltiples nubes, la combinación con Azure Arc permite extender la gestión del ciclo de vida de modelos fuera del cloud público, manteniendo políticas y telemetría centralizadas.

Este enfoque híbrido representa una ventaja competitiva para sectores como banca o salud, donde la sensibilidad de los datos impone restricciones sobre la ubicación del cómputo y los flujos de datos.

Integración con el ecosistema Azure y open source

Azure ML aporta su máximo valor cuando trabaja con el resto del ecosistema: ingestión y orquestación con Data Factory, análisis con Synapse, bases de datos con Azure SQL y servicios de inferencia complementarios como Azure OpenAI para tareas generativas. La compatibilidad con frameworks open source (PyTorch, TensorFlow, scikit-learn, XGBoost, LightGBM) facilita portar trabajo existente y reutilizar librerías de la comunidad, evitando vendor lock-in completo y acelerando la adopción por equipos ya familiarizados con esos stacks.

Además, la oferta incluye conectores y adaptadores que reducen el coste de integración en escenarios de datos masivos, ayudando a que pipelines complejos que combinan batch y streaming puedan articularse de forma ordenada.

Costes, gobernanza económica y control de gasto

El modelo comercial pivota alrededor de pago por uso: la plataforma en sí no añade un cargo fijo en muchos escenarios, mientras que los costes principales provienen de compute, storage y servicios complementarios (registro de contenedores, Key Vault, Application Insights). Para proyectos piloto esa estructura resulta atractiva; no obstante, en despliegues de producción con entrenamiento frecuente y endpoints altamente disponibles, el gasto puede escalar rápidamente si no se implantan controles de FinOps: cuotas, políticas de apagado automático y selección cuidadosa de tipos de instancia.

Herramientas internas y recomendaciones de Microsoft sugieren emplear reservas de capacidad o planes de ahorro para cargas estables y automatizar la escalabilidad para cargas variables. Para arquitectos financieros, la visibilidad sobre costes por experimento y por recurso resulta imprescindible.

Rendimiento y limitaciones técnicas

En escenarios de entrenamiento masivo, el rendimiento depende tanto del diseño del modelo como de la arquitectura de datos y la configuración de los nodos. Azure ML facilita el acceso a GPUs potentes y a patrones distribuidos, pero la optimización efectiva requiere atención a la partición de datos, la latencia de E/S y la serialización de artefactos. La plataforma automatiza muchos pasos, pero equipos con requisitos extremos (p. ej., modelos multimodales de última generación) pueden necesitar ajustes a nivel de contenedor o incluso infraestructuras dedicadas fuera del modelo estandarizado.

En cuanto a usabilidad, la curva de aprendizaje puede resultar marcada para equipos sin experiencia en Azure; la riqueza de opciones conlleva complejidad y la documentación oficial, aunque amplia, exige tiempo para dominar buenas prácticas de MLOps y seguridad. Para proyectos pequeños que buscan simplicidad máxima, la plataforma puede parecer excesiva.

Casos de uso típicos y ejemplos prácticos

Prototipado rápido: equipos de producto que necesitan validar hipótesis con modelos estándar encontrarán valor en AutoML y en la interfaz visual para iterar rápidamente.

Modelos empresariales en producción: compañías que demandan trazabilidad, controles de acceso y despliegue escalable hallarán en la combinación de Model Registry y pipelines una base sólida para MLOps.

Aplicaciones híbridas: organizaciones reguladas podrán ejecutar inferencia cerca de los datos mediante Azure Arc, manteniendo gobierno centralizado.

IA generativa y LLM: integraciones con servicios de modelos de lenguaje permiten combinar modelos propios con servicios gestionados para casos de chatbots, summarization o generación de contenidos, aportando flexibilidad arquitectónica.

Evaluación crítica: ¿para quién y cuándo elegirlo?

En el mapa actual de plataformas de machine learning, Azure Machine Learning aporta una solución integral con capacidad de producción, herramientas de MLOps y compatibilidad open source, lo que facilita a las organizaciones convertir experimentos en servicios operativos gestionados. La propuesta combina flexibilidad (SDK y Designer), escalabilidad (compute y entrenamiento distribuido) y gobernanza (registro, monitorización, políticas de seguridad), aunque demanda inversión en competencias operativas y control de costes para extraer su máximo rendimiento.

La plataforma resulta especialmente adecuada para equipos medianos y grandes con necesidad de gobernanza, reproducibilidad y despliegues en producción. Equipos pequeños o proyectos puntuales pueden preferir alternativas más simples si el objetivo principal consiste en obtener un prototipo sin gestionar infraescalado ni políticas de seguridad complejas.

En términos de trade-offs, la amplitud funcional compensa la complejidad operativa cuando el proyecto requiere continuidad, historial y cumplimiento; en cambio, para experimentos aislados, el coste de aprendizaje y gestión puede superar el beneficio inmediato.

Fortalezas y debilidades de Azure Machine Learning

| Fortalezas | Debilidades |

|---|---|

| Plataforma integral que cubre todo el ciclo de vida del Machine Learning | Curva de aprendizaje elevada para usuarios sin experiencia en la nube |

| Automatización con AutoML, que acelera la creación de modelos | Costes variables que requieren supervisión constante |

| Escalabilidad en GPU y CPU con entrenamiento distribuido | Configuración compleja en escenarios avanzados como clusters |

| MLOps integrado con versionado, trazabilidad y monitorización | Dependencia del ecosistema Azure, limitada en entornos multicloud |

| Seguridad y cumplimiento normativo con GDPR, HIPAA e ISO 27001 | Documentación extensa, pero con una entrada inicial densa para principiantes |

| Compatibilidad con frameworks open source como TensorFlow, PyTorch y Scikit-learn | Algunas funciones avanzadas requieren infraestructura costosa |

| Despliegue en tiempo real y por lotes mediante puntos finales gestionados. | Requiere una conexión a internet estable para acceder a los recursos y servicios en la nube. |

Preguntas frecuentes sobre Azure Machine Learning

¿Qué es Azure Machine Learning?

Azure Machine Learning es una plataforma en la nube de Microsoft para diseñar, entrenar, desplegar y operar modelos de IA, ciencia de datos y machine learning.

¿Cuánto cuesta Azure Machine Learning?

El modelo de precio es pago por uso: pagas por compute, storage y servicios gestionados; existen capas gratuitas y costes adicionales por endpoints y despliegues en producción.

¿Qué frameworks y lenguajes soporta?

Soporta PyTorch, TensorFlow, scikit-learn, XGBoost, LightGBM, además de R y .NET, facilitando la reutilización de código y modelos open source.

¿Qué es AutoML en Azure Machine Learning?

AutoML automatiza la selección de algoritmos, ingeniería de características y búsqueda de hiperparámetros para acelerar la creación de modelos sin necesidad de codificar todo desde cero.

¿Puedo desplegar modelos en tiempo real y por lotes?

Sí: Azure ML permite endpoints para inferencia en tiempo real y trabajos de inferencia por lotes, con escalado automático y opciones gestionadas.

¿Qué herramientas de MLOps tiene Azure Machine Learning?

Incluye pipelines, registro de modelos (Model Registry), monitorización de inferencia, trazabilidad de experimentos y fácil integración con CI/CD (GitHub Actions, Azure DevOps).

¿Qué es Designer (interfaz visual) y para quién es útil?

Designer es la interfaz no-code / low-code por arrastrar y soltar para crear pipelines y prototipos; ideal para analistas y equipos que quieren acelerar prototipos sin mucha programación.

¿Cómo se integra Azure ML con otros servicios de Azure?

Se integra con Azure Synapse, Azure Data Factory, Azure Key Vault, Azure Container Registry y servicios de datos para crear soluciones end-to-end.

¿Es seguro usar Azure Machine Learning en entornos regulados?

Sí: ofrece control de acceso, Azure Key Vault, redes virtuales y cumplimiento con certificaciones empresariales, adecuado para sectores regulados si se configuran controles adecuados.

¿Puedo entrenar modelos de forma distribuida?

Sí: soporta entrenamiento distribuido multinodo y estrategias para acelerar modelos grandes y entrenamientos en GPU/TPU.

¿Cómo monitorizo un modelo en producción?

Azure ML proporciona telemetría, métricas de rendimiento e integraciones para alertas y drift detection para garantizar la gobernanza y mantener la calidad de los modelos.

¿Se puede usar on-premises o en entornos híbridos?

Sí: mediante Azure Arc y opciones de infraestructura híbrida puedes ejecutar y gestionar cargas de Azure ML en entornos on-premises o multi-cloud.

¿Azure Machine Learning funciona con LLM y generación de texto?

Sí: permite trabajar con Modelos de Lenguaje Grande (LLM) y conectar con servicios de Azure OpenAI u otros modelos para desarrollar aplicaciones generativas.

¿Cómo empiezo un proyecto con Azure Machine Learning?

-

Crear una cuenta de Azure y un workspace de Azure ML.

-

Configurar compute y storage.

-

Registrar datos y crear experimentos/pipelines.

-

Entrenar, versionar y desplegar el modelo a un endpoint.

Referencias

-

Página oficial del producto — Azure Machine Learning: https://azure.microsoft.com/en-us/products/machine-learning

-

Documentación oficial (Microsoft Learn) — Azure Machine Learning: https://learn.microsoft.com/en-us/azure/machine-learning

- Printer-friendly version

- Log in to post comments