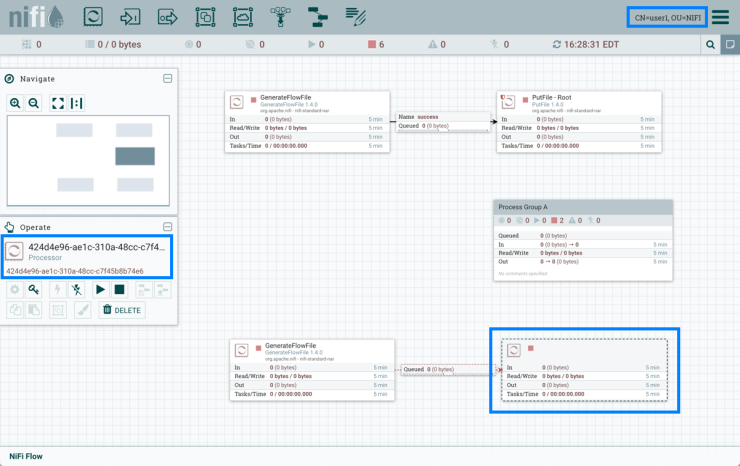

El projecte Apatxe Hadoop consisteix en el desenvolupament de programari lliure per a computació distribuída escalable i segura.

La llibreria de programari de Hadoop és un framework que permet el processament distribuído de jocs de dades de gran volum utilitzant clústers d'ordinadors o servidors, utilitzat models de programació senzilla.

Hadoop està dissenyat per a escalar fàcilment des de sistemes de servidors únics a milers de màquines.

La llibreria detecta i gestiona errors en el nivell d'aplicació per a no haver de dependre del maquinari i proporcionar així alta disponibilitat amb un clúster de servidors amb un alt nivell de tolerància a fallades en cadascuna de les màquines que componen el clúster.

Mòduls de Hadoop

El projecte Hadoop està compost per quatre mòduls principals:

Hadoop Common és un conjunt d'utilitats comunes per a la resta de mòduls.

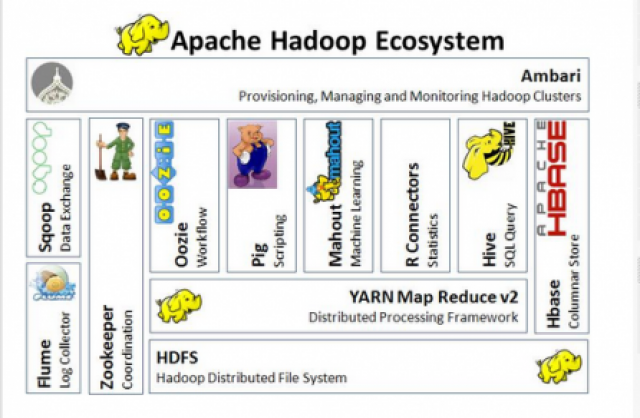

HDFS, Hadoop Distributed Files System és el sistema de fitxers distribuídos que proporciona accés d'alt rendiment a les dades d'aplicacions.

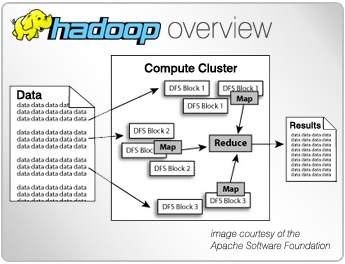

Hadoop YARN és un framework per a programació de tasques i gestió dels recursos clúster.

Hadoop MapReduce és un sistema per al processament en paral·lel de grans jocs de dades, basat en YARN.

Ecosistema de Hadoop

A part dels mòduls anteriors, la plataforma completa, o l'ecosistema de Hadoop inclou altres projectes relacionats com Apache Ambari, Apache Cassandra, Apache HBase, Apache Hive, Apache Mahout, Apache Pig o Apache Spark, entre altres.

Recursos sobre Apatxe Hadoop

Página principal del projecte Apache Hadoop

Tutorials y ajuda a la Wiki oficial d'Apache Hadoop

Página de descarrega d'Apache Hadoop

Publicacions sobre projectes Apatxe en Dataprix

- Log in to post comments