Administración, tips, SQL y utilidades sobre bases de datos SQL Server

Administración, tips, SQL y utilidades sobre bases de datos SQL Server Dataprix 15 Abril, 2022 - 12:16

Recopilación de dudas técnicas, db scripts y consultas de administración y desarrollo sobre bases de datos Microsoft SQL Server

Cómo crear un identificador secuencial en una tabla de SQL Server

Cómo crear un identificador secuencial en una tabla de SQL Server Carlos 3 Abril, 2020 - 18:57 Para crear un identificador único de secuencia en una tabla de SQL Server lo más sencillo es definir un campo de tipo Identity, y que se vaya generando sólo, pero si no se puede utilizar esta solución, o no es apropiada para un caso concreto, una solución muy sencilla para informar de manera puntual un campo con un número secuencial para cada fila es utlizar ROW_NUMBER() OVER para generar esa secuencia.

Para crear un identificador único de secuencia en una tabla de SQL Server lo más sencillo es definir un campo de tipo Identity, y que se vaya generando sólo, pero si no se puede utilizar esta solución, o no es apropiada para un caso concreto, una solución muy sencilla para informar de manera puntual un campo con un número secuencial para cada fila es utlizar ROW_NUMBER() OVER para generar esa secuencia.

Si, por ejemplo, queremos generar estos identificadores consecutivos para todas las filas de una tabla 'MyTable' en un campo 'MyRow_id' , sólo tenemos que hacer algo así:

-- Update MyRow_id with a sequential identifier ;WITH TableRanked AS( SELECT ROW_NUMBER() OVER(ORDER BY (SELECT NULL)) as rownumber, MyRow_id FROM MyTable ) UPDATE TableRanked SET MyRow_id=rownumber OPTION (MAXDOP 1)

Esta sería una solución puntual, otra cosa es si se desea mantener este campo actualizado..

buen dato, gracias por…

buen dato, gracias por aportar tu conocimiento, soy nueva por estos lares y agradezco toda la informacion aportada.

- Inicie sesión para enviar comentarios

Cómo crear una tabla con una select (CTAS) en SQLServer

Cómo crear una tabla con una select (CTAS) en SQLServer Carlos 4 Junio, 2012 - 17:24En Oracle, para crear fácilmente una tabla a partir de una consulta SQL se puede utilizar la siguiente sentencia:

CREATE TABLE NuevaTabla AS (SELECT * FROM OtraTabla);

Este tipo de sentencia se conoce como Create Table As Select (CTAS). Es muy útil para hacer pruebas rápidas con datos, para crear tablas de muchos campos que se parecen mucho a otras, o para 'materializar' una vista creando una tabla a partir de la select sobre la vista.

El caso es que en SQL Server también se puede hacer lo mismo, pero la sintaxis cambia bastante, y para el que esté más acostumbrado a la de Oracle puede serle útil saber que con SQL Server, para crear una tabla a partir de una sentencia SQL se puede utilizar una instrucción como esta:

SELECT * INTO NuevaTabla FROM OtraTabla;

Cómo recuperar los privilegios de administración (SYSADMIN) en SQLServer

Cómo recuperar los privilegios de administración (SYSADMIN) en SQLServer Carlos 26 May, 2012 - 11:39Si eres DBA y no puedes gestionar tus instancias de SQL Server porque no puedes entrar con el usuario 'sa', y no tienes ningún otro usuario con rol SYSADMIN, en el post How to connect to SQL Server if you are completely locked out, de MSSQLTips, nos explican una manera de recuperar el acceso a SQL Server como SYSADMIN.

Es algo parecido al método que explicaba il_masacratore para Recuperar la contraseña del usuario sys y system en Oracle, la clave está en entrar en la base de datos utilizando el usuario de sistema Administrador del servidor en el que está instalada.

Al conectar en modo 'single user' con un administrador local del servidor, podremos disfrutar de los permisos de administración de SYSADMIN para recuperar todo lo que haga falta, o asignar los privilegios necesarios a cualquier usuario.

Cómo reiniciar el valor de un campo identity de SQL Server

Cómo reiniciar el valor de un campo identity de SQL Server Carlos 26 Julio, 2012 - 22:30

Si una tabla de SQL Server tiene un campo de tipo identidad, o identity, en un momento dado puede interesar volverlo a dejar con su valor inicial, o a otro valor que interese para que siga autoincrementándose a partir del mismo.

Con un sencillo comando DBCC se puede dejar el valor actual del campo identity al que se desee, aunque hay que tener cuidado con no utilizar un valor que al incrementarse se pueda encontrar registros que ya existan con ese valor.

Lo más habitual es utilizar este comando cuando, por ejemplo, se eliminan todos los registros de una tabla, y se quiere volver a comenzar a insertar registros identificados por el campo autoincremental a partir de un valor inicial, normalmente 0. Si se utiliza para cualquier otra cosa hay que tener cuidado con los conflictos que puedan aparecer con registros existentes en la tabla.

Este es el comando para inicializar a cero el valor actual del autoincremental de un campo identity de la tabla 'mi_tabla', en una base de datos SQLServer: DBCC CHECKIDENT ('mi_tabla', RESEED,0) Espero que sea de utilidad,Muchas Gracias me funciono

Muchas Gracias me funciono perfectamente...!!

- Inicie sesión para enviar comentarios

Cómo restar dos fechas que contengan un parámetro de inicio y fin

Cómo restar dos fechas que contengan un parámetro de inicio y fin ariel 13 Abril, 2015 - 17:11Buenas tardes tengo una consulta a ver quien me la puede ayudar a resolver, tengo un tabla que tienen los siguientes datos:

id usuario nombre usuario feha y hora estado huellero 1 pepito 01/01/2015 08:00 inicio 1 1 pepito 01/01/2015 10:00 fin 1 1 pepito 01/01/2015 13:00 inicio 1 1 pepito 01/01/2015 13:10 fin 1 1 pepito 01/01/2015 13:50 fin 1 1 pepito 02/01/2015 08:00 inicio 1 1 pepito 02/01/2015 20:00 fin 1 1 pepito 03/01/2015 13:00 inicio 2 1 pepito 03/01/2015 13:50 fin 2 2 maria 01/01/2015 08:00 inicio 2 2 maria 01/01/2015 13:00 fin 2 2 maria 01/01/2015 21:00 fin 2 2 maria 02/01/2015 08:00 inicio 2

La idea es que la consulta me diga las horas transcurridas una persona teniendo en cuenta que el fin es cuando encuentre el siguiente inicio y que hay tener en cuenta que pueden ser de diferentes huelleros. Les agradezco me colaboren con esto que lo estoy necesitando urgente. gracias

Hola Me faltaria aclarar qué

- Inicie sesión para enviar comentarios

buenas noches si señor es un

- Inicie sesión para enviar comentarios

Entonces, asumiendo que de

Entonces, asumiendo que de cada día lo que te interesa es el primer fichaje de inicio y el último fichaje de fin, podrías solventar el problema de los registros de más modificando la consulta anterior por algo así:

select a.id, a.usuario, a.dia datediff(h,a.fecha,b.fecha) [Diferencia en horas] from (select id, usuario, estado, year(fecha)*10000+month(fecha)*100+day(fecha) dia, min(fecha) from tabla_fichajes where estado='inicio'group by id, usuario, estado, year(fecha)*10000+month(fecha)*100+day(fecha) ) tabla a

join (select id, usuario, estado, year(fecha)*10000+month(fecha)*100+day(fecha) dia, max(fecha)

from tabla_fichajes

where estado='fin'

group by id, usuario, estado, year(fecha)*10000+month(fecha)*100+day(fecha)) tabla b on a.idusuario=b.idusuario and a.dia=b.dia

Con esto, si no me equivoco, te quedarías en las tablas a y b con sólo el primer y el último fichaje diario de cada usuario, independientemente del huellero que utilicen, ¿es más o menos lo que buscabas?

- Inicie sesión para enviar comentarios

Contadores y Rangos o funcion Rank() en SQLServer

Contadores y Rangos o funcion Rank() en SQLServer hminguet 3 Octubre, 2011 - 14:40Crear contadores en SQLSERVER, simple pero útil.

1. Contador de registros:

select num = (select count(*) from d_Category r where r.id_Category<=t.id_category), t.* from d_category t

1.1. Con la función Ranking (sólo a partir del SQLSERVER 2005):

select rank() over (order by t.id_Category asc) as Ranking, t.* from d_category t order by 1

2. Contador por la suma del valor de un campo (por ranking).

En este caso obtendremos los 10 mejores clientes en ventas del 2010

select rank=count(*), s1.Customer, Val=round(s1.Val,0) from (select Customer, Val=round(sum(importe),0) from f_sales where year=2010 group by Customer) s1, (select Customer, Val=round(sum(importe),0) from f_sales where year=2010 group by Customer) s2 where s1.Val<= s2.Val group by s1.Customer having count(*)<11 order by 1

2.1. Con la función Ranking (sólo a partir del SQLSERVER 2005):

select * from ( select rank() over (order by importe desc) as Ranking, a.* from (select customer, sum(importe) as importe from f_sales where year=2010 group by Customer ) a ) F_TABLE where Ranking<=10y filtramos por los 10 primeros, por ejemplo.

Espero que os ayude.

Héctor Minguet.

Con respecto a la función

Con respecto a la función rank() over.., en lugar de necesitar una ordenación de todos los registros para sacar los 10 primeros, como en el último ejemplo, podemos necesitar una ordenación parcial de grupos de registros. Por ejemplo, en lugar de los 10 clientes con más importe pueden interesarnos los 10 clientes de cada zona con mayor importe, que es algo más habitual.

Ordenar registros agrupados con rank() over (partition by campo1 order by campo2)

Para ordenar agrupaciones de registros y quedarnos con los que nos interese (los primeros, los últimos..) lo único que hay que hacer es añadir a la sentencia la clausula 'partition by' de SQLServer para que nos haga las agrupaciones, y devuelva así el ranking, pero dentro de cada grupo o partición. Con el ejemplo anterior sería algo así:

select * from

(

select rank() over (partition by zona order by importe desc) as Ranking,

a.*

from (select zona, customer, sum(importe) as importe

from f_sales where year=2010 group by zona, Customer ) a

) F_TABLE

where Ranking<=10 Con esta consulta obtendríamos los 10 mejores clientes de cada zona, rankeados del 1 al 10 por su importe.

Eliminar duplicados en SQL Server con rank over y partition by

Este tipo de sentencias también puede ser muy útil para eliminar duplicados, y quedarnos sólo con un registro de varios. Sería algo tan simple como agrupar con partition by por los campos que queremos que nos definan los registros únicos, y quedarnos sólo con el primero de los que nos devuelva la ordenación.

Si, por ejemplo, sabemos que tenemos clientes duplicados porque se han hecho altas de clientes cuando estos ya existían, y el cliente bueno es el de la última fecha de alta, podemos 'librarnos' de los obsoletos con algo así:

select * from

(

select rank() over (partition by customer order by fecha_alta desc) as Ranking,

a.*

from (select customer, fecha_alta, sum(importe) as importe

from f_sales where year=2010 group by Customer, fecha_alta ) a

) F_TABLE

where Ranking=1

Eliminar duplicados en SQL Server con row_number over y partition by

El método con rank() para eliminar registros duplicados sólo tiene un problemilla, y es que el rank, si en el campo por el que ordena se encuentra dos valores iguales, devuelve la misma posición o rango a los dos registros del grupo, es decir, que si un cliente se diera de alta dos veces el mismo día, y esa fuera la fecha de alta más reciente, el rank nos devolvería un 1 para los dos registros, y nos quedaríamos con los dos, comiéndonos el duplicado.

Para evitar que nos pase esto, que además puede costar de ver, y generar bastantes problemas si se nos cuela el registro duplicado, en lugar de rank() se puede utilizar row_number(), que devuelve un número para cada registro del grupo, aunque el valor de la ordenación sea el mismo.

Siguiendo con el ejemplo anterior, para asegurarnos de que nos quedamos sólo con uno de los registros de cliente que se han podido dar de alta en varias ocasiones, sólo tenemos que cambiar rank() por row_number():

select * from

(

select row_number() over (partition by customer order by fecha_alta desc) as fila,

a.*

from (select customer, fecha_alta, sum(importe) as importe

from f_sales where year=2010 group by Customer, fecha_alta ) a

) F_TABLE

where fila=1 La sentencia anterior sería para hacer la selección de los registros que nos interesan, descartando los duplicados, y después se pueden guardar en una tabla con un insert, por ejemplo.

Pero si queremos eliminar los registros duplicados existentes en una tabla la sentencia SQL a utilizar sería diferente. La subselect del ejemplo ya no tiene sentido, ahora crearemos una sentencia SQL más sencilla trabajando directamente sobre todos los registros de una tabla customer_table.

Además, contaremos con la ayuda del ;with de CTE para eliminar los duplicados que no interesan, tal como se sugiere en este tema sobre borrado de registros duplicados:

;with duplicado as ( select row_number() over (partition by customer order by fecha_alta desc) as fila, c.* from customer_table c ) delete from duplicado where fila>1

Bueno, pues así ya tenemos controlados contadores, rangos, agrupaciones y duplicados en SQL Server, y tenemos algunos ejemplos de la función rank() de SQLServer, que cuesta un poco de entender, pero una vez que se aprende a utilizar nos puede evitar muchos quebraderos de cabeza con nuestras consultas, que de otra manera se pueden complicar bastante, y más si además queremos deshacernos de registros duplicados.

- Inicie sesión para enviar comentarios

Insert from select en SQL Server

Insert from select en SQL Server Carlos 10 Octubre, 2016 - 19:38 Insertar registros con una select

Insertar registros con una select

Para hacer un insert para añadir registros a una tabla a partir de una sentencia Select en SQL Server se puede hacer algo tan simple como esto:

insert into mi_tabla_destino select * from mi_tabla_origen

Insertar registros con nombre de campo o diferente número con una select

Eso siempre que los campos de ambas tablas sean iguales. Si no coinciden exactamente, en número, nombre, etc., en lugar de utilizar el * hay que indicar el nombre de los campos que vamos a utilizar en la tabla origen y la tabla destino:

insert into mi_tabla_destino (campo_destino1, campo_destino2, campo_destino3) select (campo_origen1, campo_origen2, campo_origen3)

Crear una nueva tabla a partir de una select (CTAS)

Esto si la tabla ya existe, si lo que se quiere es crear una nueva tabla a partir de los datos de una select sobre otras tablas, algo conocido como CTAS (Create As Select), la sintaxis de la sentencia cambia un poco:

SELECT * INTO dbo.Destination FROM dbo.SourceSELECT * INTO dbo.Destination FROM dbo.SourceSELECT * INTO dbo.Destination FROM dbo.SourceSELECT * INTO dbo.Destination FROM dbo.SourceSELECT * INTO dbo.Destination FROM dbo.Sourceselect * into mi_nueva_tabla_destino from mi_tabla_origen

UPDATE con JOIN en SQLServer

UPDATE con JOIN en SQLServer hminguet 8 Julio, 2008 - 10:25Supongamos que queremos actualizar en nuestra bbdd SQLServer el campo de costes de la tabla de hechos FAC_TABLE con el coste unitario de nuestra tabla de COSTES.

UPDATE FAC_TABLE SET COSTE_UNITARIO = ct.COSTE_UNITARIO FROM COSTES ct WHERE FAC_TABLE.id_articulo = ct.id_articulo

Algo más sencillo que en Oracle.

Espero que os ayude.

Héctor Minguet.

Reconozco que esta sentencia

Reconozco que esta sentencia de UPDATE a partir de una SELECT de otra tabla en SQLServer es simple y efectiva pero, aunque no lo parezca, para mi es más fácil de recordar, y te diría que más comprensible esta otra sentencia SQL de Update, que yo calificaría de más estandar, y en la que se separa la condición de Join de los filtros del Where:

UPDATE Fact SET coste_unitario = ct.coste_unitario FROM FAC_TABLE Fact INNER JOIN Costes ct ON Fact.id_articulo = ct.id_articulo WHERE Fact.idfecha > 20120101

Alguien conoce alguna sentencia SQL mejor, o diferente, para hacer un 'UPDATE FROM SELECT' con SQL Server?

- Inicie sesión para enviar comentarios

Holas yo soy muy partidario,

Holas

yo soy muy partidario, cuando se complica mucho la cosa, de los bloques cte (tambien para oracle), se ve muy claro todo:

;with fact_CTE as (

SELECT fact.coste_unitario,

ct.coste_unitario as coste_unitario_UPD

FROM FAC_TABLE Fact

INNER JOIN Costes ct ON Fact.id_articulo= ct.id_articulo

WHERE Fact.idfecha > 20120101 )

UPDATE fact_CTE set coste_unitario= coste_unitario_UPD

- Inicie sesión para enviar comentarios

Buena sugerencia. En

Buena sugerencia. En estos ejemplos de Updates con join las sentencias son bastante simples, pero con queries más complejas la utilización de bloques CTE con el with de SQL Server puede simplificar muchísimo la comprensión de la sentencia, y a veces también el rendimiento.

- Inicie sesión para enviar comentarios

esta claro y me sirvió muchas

- Inicie sesión para enviar comentarios

Libros de SQL Server ¿Quieres

Libros de SQL Server

¿Quieres profundizar más en Transact-SQL o en administración de bases de datos SQL? Puedes hacerlo consultando alguno de estos libros de SQL Server

También puedes revisar la lista completa de los últimos libros de SQL Server publicados en Amazon según lo que te interese aprender.

- Inicie sesión para enviar comentarios

Excelente post...me sirvió

Excelente post...me sirvió para solucionar un problemon (problema grande) en mi trabajo.

Gracias

- Inicie sesión para enviar comentarios

DBlink en sql server

DBlink en sql server gilson 12 Enero, 2010 - 20:12Mi pregunta es muuy sencilla, es posible crear un dblink en sql server, y si es posible, como lo hago, muchisimas gracias!

saludos a todos

En su última entrada de blog,

En su última entrada de blog, il_masacratore comentaba Cómo acceder a MySQL desde SQL Server utilizando un Servidor Vinculado de SQL Server, que sería el equivalente a un database link de Oracle.

Espero que esto ya te sirva.

- Inicie sesión para enviar comentarios

Para crear un linked server

Para crear un linked server de SQL Server que conecte con una base de datos Oracle primero hay que instalar el conector OLEDB de Oracle, y después crear y configurar el linked server con T-SQL, o con SSMS.

Instalar el conector OLEDB de Oracle

Si no lo tienes, hay que instalar un cliente de Oracle que incluya este conector. Ojo porque el Instant client, el cliente básico de Oracle no lo incluye, se puede instalar el cliente, y después un paquete de complemento que lo incluya, pero lo más recomendable es instalar el paquete ODAC (Oracle Data Access Components), que sí que incluye el proveedor OLEDB de Oracle.

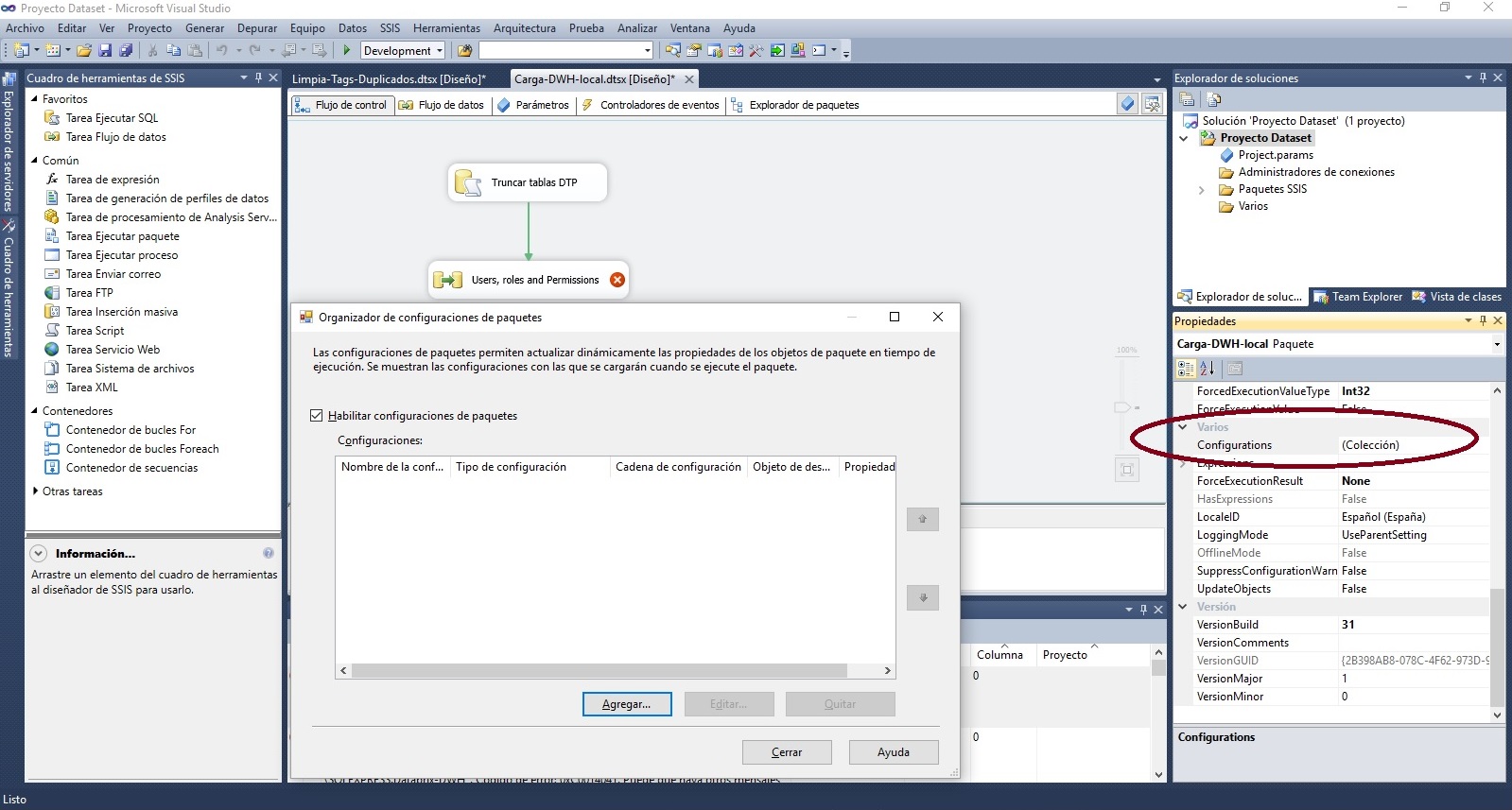

Si tienes un SQLServer de 64 bits en teoría es mejor que utilices los conectores de 64 bits que incluye este ODAC 64 bits de Oracle, pero si vas a conectar desde Visual Studio o desde SSIS curiosamente a día de hoy sólo te funcionarán los conectores de 32 bits, que puedes descargar desde la versión ODAC with Oracle Developer Tools for Visual Studio, de 32 bits. Según lo que vayas a hacer puede que lo mejor sea instalar los dos.

Apps de 32 bits en Ordenador con Windows 10 de 64bits y SQL Server de 64bits

Si tienes algún problema con esta instalación, otra opción que no suele fallar es instalar directamente un Oracle XE en tu máquina cliente, que también incluye el driver OLEDB, y no ocupa mucho más que el ODAC con las Tools. Nunca está de más disponer de una pequeña base de datos Oracle en la máquina que se va a conectar al server, aunque sólo sea para hacer pruebas. Puedes descargar el instalador de Oracle XE 11g desde aqui. Elige la versión de 32 o 64 bits con el mismo criterio que para las ODAC, si vas a conectar también Visual Studio/SSIS, aunque tu sistema y tu SQL Server sean de 64 bits instala la BD Oracle de 32 bits.

Crear el linked server a Oracle en SQL Server

Si ya tienes bien instalado el proveedor OLEDB de Oracle esta debería ser la parte más fácil. Se puede hacer desde el entorno gráfico de SQL Server Management Studio, utilizando el botón derecho sobre la carpeta 'Servidores vinculados' para crear un nuevo linked server que utice OLEDB para conectar con una BD Oracle.

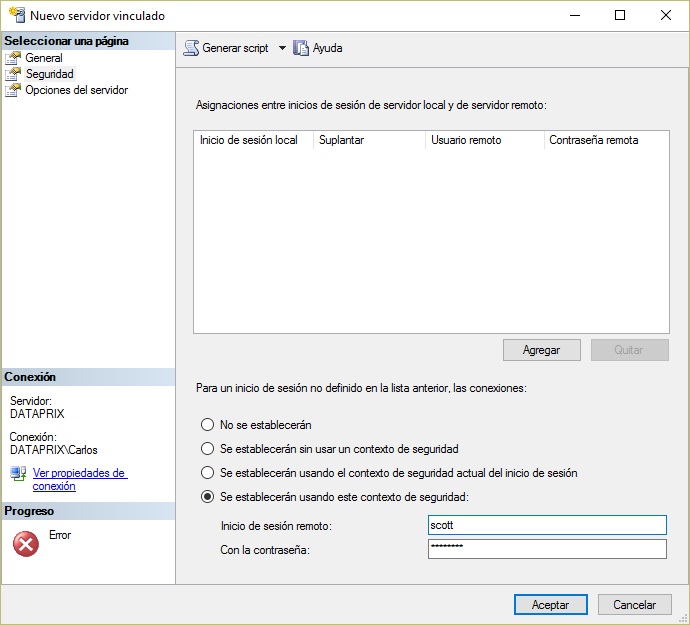

Enlazo un sitio que lo explica bastante bien, y te dejo dos pantallazos de ayuda para la parte donde te pueden surgir más dudas.

- Inicie sesión para enviar comentarios

Limitaciones en las funciones de SQL Server

Limitaciones en las funciones de SQL Server Carlos 21 Diciembre, 2016 - 17:22 Las funciones de usuario de SQL Server tienen bastantes limitaciones comparadas con otras funciones de otras bases de datos, como Oracle, o con lo que se puede hacer en los procedimientos almacenados.

Las funciones de usuario de SQL Server tienen bastantes limitaciones comparadas con otras funciones de otras bases de datos, como Oracle, o con lo que se puede hacer en los procedimientos almacenados.

Las principales limitaciones, bajo mi punto de vista, son estas dos:

- Dentro de una función de SQL Server no se pueden ejecutar sentencias de actualización de datos como INSERT, UPDATE o DELETE, es decir, que una función de usuario NO puede modificar valores de las tablas de una base de datos.

- Las funciones de T-SQL no permiten el tratamiento de excepciones con bloques TRY CATCH

Es importante recordar estas limitaciones antes de comenzar a desarrollar funciones personalizadas, porque es bastante habitual terminar creando un procedure porque alguna cosa no se puede hacer o controlar con una función.

¿Conoces más limitaciones de las funciones de usuario de TSQL?

SQL Dinámico con retorno de valores en procedimientos de SQL Server

SQL Dinámico con retorno de valores en procedimientos de SQL Server Carlos 30 Diciembre, 2016 - 08:51 Si necesitas parametrizar algo más que los valores de los campos que se introducen en la parte del WHERE en una sentencia T-SQL de un procedimiento almacenado seguramente vas a tener que utilizar SQL dinámico, aunque si se puede hacer lo mismo sin SQL dinámico siempre es mejor, más seguro y más eficiente.

Si necesitas parametrizar algo más que los valores de los campos que se introducen en la parte del WHERE en una sentencia T-SQL de un procedimiento almacenado seguramente vas a tener que utilizar SQL dinámico, aunque si se puede hacer lo mismo sin SQL dinámico siempre es mejor, más seguro y más eficiente.

Ejemplo de sentencias que se pueden hacer dentro de un procedure con SQL 'Estático'

INSERT INTO estadisticas(idFecha,fecha,bd,tabla,campo,filtro,funcion,valor) values (@idfecha,getdate(),@bd,@tabla,@campo,'','COUNT',@valor) SELECT @valor= valor FROM estadisticas WHERE bd=@bd and tabla=@tabla and campo=@campo

Ejemplos de sentencias que se pueden hacer dentro de un procedure con SQL dinámico

Si es necesario parametrizar el nombre de la tabla de la query, o partes de la sentencia fuera del WHERE, se puede utilizar SQL dinamico con la opción poco recomendada porque el motor no puede optimizar nada, y porque se corre el peligro de sufrir un ataque de SQL Injection de montar la sentencia en un string, y ejecutarlo directamente con EXEC.

Un ejemplo de lo que se puede hacer, pero es mejor evitar:

SET @SQLQuery= 'SELECT ' + cast(@funcion as NVARCHAR(50)) + '('+ cast(@campo as NVARCHAR(50)) +')

FROM ' +cast(@bd as NVARCHAR(50))+ '.' + cast(@tabla as nvarchar(50))

EXECUTE(@SQLQuery)Un ejemplo para obtener el mismo resultado, pero de manera más segura y eficiente. Se define además una variable de salida para recuperar un valor de la query.

Sin duda esta es la opción más recomendada para ejecutar SQL dinámico en procedures de T-SQL:

DECLARE

@Tabla sysname,

@Funcion nvarchar(50),

SET @SQLQuery='SELECT @valor=' + @funcion + '(' + @campo + ') FROM ' + QUOTENAME(@tabla)

EXECUTE sp_executesql @SQLQuery, N'@campo nvarchar(50),@valor bigint OUTPUT',

@campo=@campo,@valor=@valor OUTPUT

SELECT @valor as valor

Destacar que @tabla y @funcion son variables locales que se pueden preparar dinámicamente dentro del procedure, e incluirlas directamente en la sentencia y que @campo sería, por ejemplo, un parámetro del procedure.

@Tabla es de tipo sysname porque se utiliza como nombre de tabla en el FROM, si se definiera como NVARCHAR en algunos casos podrían producirse errores de ejecución.

Referencias de otros sitios con más detalles y ejemplos: MSQLTips, Codeproject

Herramientas de administración para DBA's de SQL Server

Herramientas de administración para DBA's de SQL Server Carlos 22 Septiembre, 2016 - 18:39 Con SQL Server Management Studio se gestiona bastante bien la administrción básica de SQL Server, pero siempre hay herramientas que pueden ayudar a hacer las cosas más fáciles.

Con SQL Server Management Studio se gestiona bastante bien la administrción básica de SQL Server, pero siempre hay herramientas que pueden ayudar a hacer las cosas más fáciles.

Mi idea es dejar aquí una lista de las que consideremos más útilles, y así podamos consultarla en cuanto tengamos que hacer alguna cosa específica.

Las primeras que propongo son gratuítas, o tienen versión free, al menos para una instancia, sin caducidad:

Herramientas y scripts complementarios gratuítos para SQLServer

- SQLSentry Plan Explorer

Perfecta para optimizar consultas, y mucho más completa que el analizador de Management Studio. Además se puede agregar como Add-In de SSMS para poder llamarla directamente desde un plan de ejecución de SSMS. - Toad for SQL Server

La versión free para mi no aporta mucho más que SSMS, pero en un listado de software freeware para DBA'a creo que no debe faltar Toad :) - Redgate SQL Search

Un Add-in superútil de redgate para SQL Server Management Studio que permite realizar búsquedas sobre los objetos y de la base de datos y localizar fragmentos de código SQL en tablas, vistas, procedimientos almacenados, funciones, vistas, jobs.. - Idera SQL Check

Útil herramienta para monitorización del rendimiento cuya versión gratuíta se puede utilizar con un servidor y para monitorizar hasta 20 métricas, sin necesidad de instalar ningñun agente. - Who is active (sp_whoisactive)

Procedimiento almacenado para monitorización de actividad y optimización del rendimiento - SQL Server Maintenance Solution

Scripts de Ola Hallengren para mantenimiento de bases de datos SQL Server (DatabaseBackup.sql, DatabaseIntegrityCheck.sql, IndexOptimize.sql, CommandExecute.sql y CommandLog.sql)

¿Utilizas otras herramientas complementetarias para administrar tus bases de datos SQL Server? Dinos cuáles son y haremos crecer la lista..

Ssmstools, sp_whoisactive y

Ssmstools, sp_whoisactive y los scripting de olla hallegreen.

- Inicie sesión para enviar comentarios

Gracias por tu aportación, he

Gracias por tu aportación, he incluído SP_Whoisactive y SQLServer MaintenanceSolution en la lista de herramientas y scripts gratuítos.

SSMS Tools Pack también parece muy útil, pero no es gratuíta, aunque es bastante barata, así que la dejo aquí enlazada. La licencia de demo sirve para 60 días de prueba.

- Inicie sesión para enviar comentarios

Gracias por el Aporte, y

- Inicie sesión para enviar comentarios

¡Gracias por esta

¡Gracias por esta información!

Me gustaría añadir que existe una herramienta más que puede acelerar la escritura de códigos SQL, ofrecer sugerencias inteligentes basadas en el contexto, realizar formateo y refactorización automáticos, mejorar la legibilidad del código, aumentar la productividad y reducir los costos.

- Inicie sesión para enviar comentarios

Access to sql

Access to sql MrAlex 11 Septiembre, 2015 - 20:14Hola Alex Ante todo, no pidas

Hola Alex

Ante todo, no pidas disculpas por participar en el foro, todas las aportaciones adecuadas a la temática de los foros de Dataprix son bienvenidas, y tu consulta encaja perfectamente, seguro que no eres el primero que migra de Access a SQL Server :)

Entrando en el tema que planteas, la decisión que has de tomar a la hora de migrar las bases de datos de Access a SQLServer depende de muchos factores, y has de evaluar tu mismo pros y contras y decidir. Para mi los factores que más te pueden influir son el diseño, el rendimiento y la seguridad. Te comento lo que veo de cada punto:

- Diseño: Si las bases de datos tienen relación lógica entre ellas, o normalmente son compartidas por la misma aplicación, conexiones o usuarios te puede simplificar bastante la gestión y el desarrollo unificarlas en una sola. Si tienes muchas tablas vinculadas seguramente es que estarían mejor unificadas.

- Rendimiento: A nivel de rendimiento, como no son bases de datos grandes, si todas van a estar en el mismo servidor no creo que notes mucha diferencia entre mantenerlas separadas y utilizar servidores vinculados para compartir la información de las tablas en las consultas, o tener todas en la misma base de datos y olvidarte de servidores vinculados. Pero ya te digo, si necesitas utilizar muchos linked servers para las consultas es que puede que los datos no tendrían que estar tan separados, no? Donde sí podrías notar alguna diferencia de rendimiento, según cómo se gestionen las conexiones en tus aplicaciones es al abrir las conexiones, no es lo mismo abrir una que cuatro.

- Política de Seguridad: Si las bases de datos van a compartir usuarios y aplicaciones puede que sea más fácil tener una sola. Si no es así, y hay usuarios de base de datos, o de aplicaciones, que es mejor que sólo tengan acceso a tablas de alguna de las bases de datos, entonces asignar una base de datos a cada usuario te simplificaría la gestión de la política de seguridad porque lo harías a nivel de base de datos, y no de tablas u objetos.

Espero haberte ayudado con estas reflexiones, ya nos contarás si al final haces la migración desde los Access dejando las bases de datos separadas, o las unificas en una sóla base de datos de SQL Server.

- Inicie sesión para enviar comentarios

Hola. De acuerdo a tu duda,

Hola. De acuerdo a tu duda, considero que todo depende de como tengas funcionando tu BD, si la utilizas para diferentes ambientes, por ejemplo una base de datos para insertar en la pantalla persona y otra base de datos para registrar ventas y sí te ha funcionado no hay ningun problema para migrarlo a SQL incluso te daría un mejor performance, estabilidad y un futuro para tu aplicación.

Solo debes checar que la BD tenga concordancia y cumpla con un diseño correcto para que pueda funcionarte correctamente.

Si afecta a tus tablas si deberías considerar la opci+on de restructurar y ponerla en una sola Base de Dato

Espero te haya servido mi comentario.

- Inicie sesión para enviar comentarios

Almacenar usuario y dominio

Almacenar usuario y dominio jatb 23 Junio, 2013 - 04:53Hola a todos,

Espero me puedan ayudar, quiero guaradar el historial de los usuarios que visualizan los reportes, los parametros del reporte son los parametros que pasan por el sp en sql, ahora lo que quiero es guaradar en una tabla que usuario y el dominio esta generando el reporte.

Como se puede lograr esto?

Dentro del sp incluye un

Dentro del sp incluye un insert into tabla_custom con todos los valores hora de ejecucion y demas.

Suele usarse este metodo mas para debug añadiendo bloque try catch, pudiendo detectar errores no reportados por el usuario.

- Inicie sesión para enviar comentarios

Auditoria de bases de datos SQL Server 2008

Auditoria de bases de datos SQL Server 2008 GabrielMartinez1987 19 Enero, 2012 - 18:39

Existen herramientas ya definidas en SQL Server que sirvan para llevar adelante una auditoria de una base de datos?

Entiendo que podemos definir triggers para registrar inserciones, actualizaciones y demas operaciones sobre los datos, pero quiero saber si ya existen herramientas para esto.

Saludos.

Gracias

La herramienta predefinida

La herramienta predefinida para auditar la base de datos SQL Server es SQL Server Audit, y la puedes utilizar desde el mismo SQL Server Management Studio.

Te enlazo la página de Descripción de SQL Server Audit de MSDN, y el artículo An Introduction to SQL Server 2008 Audit, del blog SQL Aloha, que explica muy bien lo que puede hacer la herramienta, y te da un ejemplo sobre cómo utilizarla.

Según lo que tengas que hacer, si también te interesa realizar análisis de la distribución o perfilado de los datos, otra herramienta muy útil de SQL Server 2008 es la Data Profile Task de SSIS, y el Data Profile Viewer para visualizar los resultados. Te enlazo el artículo Data profiling con SQL Server 2008, en el que explico cómo se utilizan.

- Inicie sesión para enviar comentarios

Base de datos de una web sincronizada con BBDD de locales

Base de datos de una web sincronizada con BBDD de locales Carlos 27 Agosto, 2009 - 11:57Jorge pregunta en otro tema lo siguiente:

[quote=jorgebcl] Hola, Carlos esta genial el ETL, te hago otra consulta, esta muy bueno el tema, ya que esto es de base de datos, como funciona un pagina que se dedica a vender articulos por intenet en cuanto a la base de datos?, la idea aqui es que todos los locales esten en linea y haci usar esa base de datos para la venta en WEB, pero la linea dedicada es muy costasa y no estoy viendo el retorno por ninguna parte(ya que las ventas por intenet de nuestros articulos uqe son neumaticos es una idea que quizas mas adelante funcion como tirerack), la pregunta es como lo hacen las empresas que tiene esta figura, no seria mejor hacre un respaldo cada una hora por ejemplo y usar estos respaldos de locales para que la web se conexte a esta base de respaldo, lo que tendria baja probabiilidad de no tener stock, y ahorrarmen la linea dedicada. Saludos Jorge [/quote]

Hola Jorge

Si no tienes la necesidad de mantenerlo todo sincronizado en tiempo real puede que sea buena idea ahorrarte la línea dedicada. Tal como comentas, si tienes locales y una web puedes mantener una base de datos centralizada que se vaya actualizando con los datos de todos los puntos de venta, y esta actualización no es necesario que sea en tiempo real. Supongo que también tendrás que pensar en una actualización en sentido contrario.

- Lo más sencillo sería trabajar con descargas de datos cada cierto tiempo. El stock deberías actualizarlo más a menudo, pero los datos maestros como artículos y tarifas pueden actualizarse diariamente, por ejemplo. En la parte de la base de datos centralizada/ servidora de la web puedes tener un SQL Server y utilizar SSIS para incorporar los datos que provengan de los locales.

- Si la tecnología de la aplicación de punto de venta te lo permite también podrías plantearte la utilización de web services para mantener el stock lo más actualizado posible.

- Y si pudieras utilizar bases de datos SQL Server en el punto de venta podría funcionarte muy bien, y sin tener que pagar más licencias, utilizar SQL Server Express en los locales y realizar la sincronización entre la BD servidora y las locales mediante el mecanismo de replicación de SQL Server. En el sentido de BD local a BD Servidora seguramente tendrías que seguir utilizando SSIS, por las limitaciones de uso de la versión Express.

Aparte de la reducción de los costes de la linea, ten en cuenta que de esta manera también independizas el funcionamiento de todos los puntos de venta, ya que cada uno tiene su propia base de datos que funciona independientemente de lo que pase fuera. Si un TPV se queda sin ADSL podrá seguir vendiendo sin problemas hasta que recupere la conexión.

Bueno, parece que tienes otro proyecto interesante entre manos, ya nos contarás por qué tecnología te decides y cómo te va..

Ola carlos, me comentan aca

Ola carlos, me comentan aca que por diseño del sistema que se desarrollo esta, estubo pensando siempre para que este en linea, por lo que la base de datos es solo una, para hacer lo que tu me dijiste habria que tener fotos de toda esta informacion, al parecer habria que hacerlo asi, estan cotizando tener en los locales Ancho de banda mayor. Yo no estaba al inicio del proyecto, pero me parece que demoraria mucho un replantamiento del tema......el problema con esto que llevar demasiado tiempo

Saludos

- Inicie sesión para enviar comentarios

Si todo está diseñado para

Si todo está diseñado para trabajar con una base de datos servidora está claro que cambiar a un funcionamiento con ésta más bases de datos locales supone un cambio importante que tiene sus ventajas, pero también sus costes e inconvenientes.

Al menos tienes un plan B en mente por si tuvieras algún problema con la 'opción online'.

- Inicie sesión para enviar comentarios

Consulta sobre enviar Suscripciones SSRS

Consulta sobre enviar Suscripciones SSRS hanamichito 10 Enero, 2014 - 17:11Estimados,

Buenas, hace tiempo que no posteo en esta gran comunidad y en esta oportunidad quisiera preguntarles si saben del procedimiento o job que se ejecuta el momento de enviar una suscripcion esto lo pregunto ya que estoy trabajando en una aplicacion que debe de cumplir la tarea que hace automaticamente el SQL SERVER...

muchisimas gracias!!!!

y quedo atento a sus comentarios y les dejo mi contacto ...

Pablo Meneses Leiva

Ingeniero Magister en Informatica

ya encontre la solución,

ya encontre la solución, todo pasa por una tabla de eventos que tiene la bbdd de Report y luego de eso hay un proceso que escucha esta tabla y lo que este en ella lo envia por correo electronico...

muchas gracias!!!!!!!!!

saludos!!!

- Inicie sesión para enviar comentarios

Hola Pablo Muchas gracias por

Hola Pablo

Muchas gracias por compartir la solución. Si no es molestia, puedes decirnos cómo se llama la tabla de eventos?

Saludos,

- Inicie sesión para enviar comentarios

deben de crearse la

deben de crearse la siguiente VIEW en la base ReportServer...

GO

/****** Object: View [dbo].[vw_reportes_suscripciones] Script Date: 01/27/2014 16:13:23 ******/

SET ANSI_NULLS ON

GO

SET QUOTED_IDENTIFIER ON

GO

ALTER view [dbo].[vw_reportes_suscripciones]

as

SELECT Subscriptions.SubscriptionId

,Subscriptions.Description AS SubscriptionName

,Schedule.ScheduleID AS JobID

,Catalog.Name AS ReportName

FROM dbo.Subscriptions

INNER JOIN dbo.ReportSchedule

ON ReportSchedule.SubscriptionID = Subscriptions.SubscriptionID

INNER JOIN dbo.Schedule

ON ReportSchedule.ScheduleID = Schedule.ScheduleID

INNER JOIN dbo.Catalog

ON ReportSchedule.ReportID = Catalog.ItemID

SALUDOS Y ESPERO LES SIRVA!!!!

- Inicie sesión para enviar comentarios

Crear en SQL Server un rol adicional para ejecutar stored procedures

Crear en SQL Server un rol adicional para ejecutar stored procedures Carlos 21 Noviembre, 2017 - 20:12 Cómo crear un rol en SQL Server para poder dar a los usuarios fácilmente permisos para ejecutar stored procedures.

Cómo crear un rol en SQL Server para poder dar a los usuarios fácilmente permisos para ejecutar stored procedures.

En SQL Server no existe un rol predefinido para que un usuario pueda ejecutar stored procedures, aparte del db_owner.

Si se trabaja con stored procedures y se quiere permitir a usuarios que no tengan porqué ser owners de una base de datos ejecutar procedimientos almacenados de la misma, se puede crear un rol específico con un grant de permisos de ejecución 'EXECUTE'.

Así después sólo hay que asignar ese rol a los usuarios que tengan que ejecutar stored procedures de una base de datos.

Es tan fácil como hacer algo así:

-- Crea un nuevo rol para ejecutar stored procedures CREATE ROLE db_execute -- Asigna permisos de ejecución de procedimientos almacenados al rol GRANT EXECUTE TO db_execute -- Agrega un usuario al recién creado rol db_execute role EXEC sp_addrolemember 'db_execute', 'usuario'

Después de esto 'usuario' ya podrá ejecutar stored procedures de la base de datos en la que se ha creado el rol aunque no sea 'db_owner' de esa base de datos..

Esquemas en Sql Server 2005

Esquemas en Sql Server 2005 GabrielMartinez1987 25 Noviembre, 2011 - 15:28Hola buen dia.

Soy nuevo en la pagina y ademas recien arranco con Sql Server 2005, escuche hablar sobre Esquemas y la verdad no se cual es el motivo por el cual se usan. Es decir, para que sirven y cuando tengo que usarlos.

Agradeceria su ayuda para solventar esta duda. Muchas gracias de antemano.

Saludos. Gabriel

Gabriel, te he montado una

Gabriel, te he montado una defición de esquemas de SQL Server, obtenida de las librerías de microsoft:

Un esquema simplemente es un contenedor de objetos. Cada esquema es un espacio de nombres distinto que existe de forma independientemente del usuario de base de datos que lo creó. Cualquier usuario puede ser propietario de un esquema, y esta propiedad es transferible.

A partir de SQL Server 2005, los esquemas son entidades explícitas reflejadas en los metadatos y, como resultado, los esquemas solo pueden tener un propietario. Sin embargo, un único usuario puede poseer muchos esquemas.

Los esquemas te sirven sobretodo para organizar los objetos, y también la seguridad de la base de datos, especialmente cuando tengas varios usuarios. Si un usuario posee un esquema, tiene por defecto permisos sobre los objetos de ese esquema que no tendrán otros usuarios, a menos que se les hayan concedido expresamente.

- Inicie sesión para enviar comentarios

Hola Carlos. Muchisimas

Hola Carlos. Muchisimas gracias por responderme. Me quedó muy claro todo.

Espero poder seguir preguntando.

Saludos Gabriel.

- Inicie sesión para enviar comentarios

Hola Amigo, Tengo una

Hola Amigo,

Tengo una pregunta a tu respuesta con respecto a los esquemas en SQL Server. Crear muchos esquemas puede realentizar la Base de datos? o puede hacer que se consuman más recursos? la idea es crear un esquema por cada sistema que manejamos, y asi mantener los objetos de cada uno separados.

Gracias por tu respuesta.

Saludos

- Inicie sesión para enviar comentarios

No te puedo decir exactamente

No te puedo decir exactamente la incidencia que tiene en el rendimiento de la base de datos la existencia de diferentes esquemas en lugar de uno sólo, pero ha de ser insignificante con respecto a otros aspectos a tener en cuenta, más de ventajas/desventajas de organización y seguridad.

Supongo que tampoco tendréis tantos sistemas, por lo que por lo que cuentas a mi me parece una buena práctica crear un esquema para cada uno.

Piensa que además, si se asignan ficheros físicos diferentes a los diferentes esquemas, puedes obtener muchas ventajas de cara al mantenimiento, backups, restauraciones, etc. Incluso, según los datos que tengas en cada sistema, puede llegar a ser más eficiente que estén separados.

- Inicie sesión para enviar comentarios

Muchas gracias por su tan

Muchas gracias por su tan pronta respuesta.

Seguré sus consejos.

Saludos

- Inicie sesión para enviar comentarios

Hola, hay algun query o algun

Hola, hay algun query o algun SP que me permita ver el contenido de los esquemas?

- Inicie sesión para enviar comentarios

Hola Angel El esquema

Hola Angel

El esquema INFORMATION_SCHEMA guarda información sobre la estructura de objetos de SQL Server como tablas y vistas.

Para comenzar a explorarlo puedes probar con sentencias sencillas como:

SELECT * FROM INFORMATION_SCHEMA.TABLES; SELECT * FROM INFORMATION_SCHEMA.COLUMNS; SELECT * FROM INFORMATION_SCHEMA.VIEWS;

Espero que sea lo que buscas

- Inicie sesión para enviar comentarios

Generación de codificación geográfica y zona de tiempo a partir de direcciones en SQL Server con PowerShell, T-SQL y GoogleMaps

Generación de codificación geográfica y zona de tiempo a partir de direcciones en SQL Server con PowerShell, T-SQL y GoogleMaps Carlos 26 Septiembre, 2016 - 15:21 Generar las coordenadas geográficas a partir de una dirección utilizando la API de Web Services de Google Maps, y todo dentro de SQL Server, me parece algo tan útil como técnicamente interesante.

Generar las coordenadas geográficas a partir de una dirección utilizando la API de Web Services de Google Maps, y todo dentro de SQL Server, me parece algo tan útil como técnicamente interesante.

Como estoy seguro de que no tardaré en probarlo o necesitarlo para algo, enlazo aquí el post de MSSQLTips sobre cómo hacerlo para saber dónde encontrarlo como lo necesite, y me guardo la función de llamada a la API:

#

# Name: Get-Geo-Coding

# Purpose: Use Google api 4 address 2 location calc.

#

function Get-Geo-Coding {

[CmdletBinding()]

param(

[Parameter(Mandatory = $true)]

[String] $ServiceKey,

[Parameter(Mandatory = $true)]

[string] $FullAddress

)

# Create request string

[string]$ApiUrl = ""

$ApiUrl += "https://maps.googleapis.com/maps/api/geocode/xml?address="

$ApiUrl += $FullAddress

$ApiUrl += "&key="

$ApiUrl += $ServiceKey

# Make request

$Request = [System.Net.WebRequest]::Create($ApiUrl)

$Request.Method ="GET"

$Request.ContentLength = 0

# Read responce

$Response = $Request.GetResponse()

$Reader = new-object System.IO.StreamReader($Response.GetResponseStream())

# Return the result

return $Reader.ReadToEnd()

}

Importar base de datos desde Oracle

Importar base de datos desde Oracle gilson 21 Enero, 2010 - 14:24Buenas a todos, tengo una base de datos en oracle 9i, y me gustaria migrar esa base de datos a sql server 2008, ojala alguien podria ayudarme con esto, desde ya estoy muy agradecido.

saludos a todos

buenas, sin saber bien el

buenas,

sin saber bien el motivo y exacamente lo que quieres hacer exactamente ten en cuenta esta herramienta...

Saludos

- Inicie sesión para enviar comentarios

buenas, resulta que estoy

buenas, resulta que estoy tomado un curso de transact sql en la universidad y quiero probar, muchas gracias por tu ayuda!

saludos!

- Inicie sesión para enviar comentarios

Instalacion de SQL SERVER 2008 EN xp con SP2

Instalacion de SQL SERVER 2008 EN xp con SP2 gilson 18 Enero, 2010 - 13:12Buenas a todos, tengo un problema al instalar el motor, me sale un error al iniciar el mismo, les comento que anteriormente tenia el sql 2005 que al parecer no lo desinstale correctamente, por que al iniciar mi pc me sale un error del sql dumper, que podria hacer para solucionar este problema?, es posible descargar nuevamente la utilidad sql dump, o que me dices ustedes?..

Muchisimas gracias por su ayuda

Saludos

Podrías especificar el error

Podrías especificar el error que comentas que te sale al iniciar SQL Server? También sería útil saber la versión de SQL Server que has instalado, si es Express, Standard o Enterprise. No creo que sea el caso, pero recordemos que la Enterprise, por ejemplo, se ha de instalar sobre un Windows Server.

De todas maneras puedes consultar en la web de Soporte de Microsoft el artículo Cómo desinstalar manualmente una instancia de SQL Server 2005, puede que así encuentres lo que se haya quedado sin desisntalar.

Otra cosa que también te podría ser de utilidad, sobretodo si has detectado que algo en concreto se ha quedado sin desinstalar es la herramienta Windows Installer CleanUp Utility, que se suele utilizar cuando los desinstaladores estandar no terminan bien su trabajo

- Inicie sesión para enviar comentarios

Los campos identity se saltan 1000 números aleatoriamente

Los campos identity se saltan 1000 números aleatoriamente Carlos 23 May, 2014 - 18:49En el grupo SQL Server Si! de Linkedin, me han hecho una consulta sobre un funcionamiento anormal de los campos Identity de una base de datos SQL Server. La traslado aquí porque es algo que a mi nunca me ha pasado.

En un SQL Server 2012 sp1 las claves primarias definidas como campos identity, en distintas tablas, y de manera aleatoria, cada semana en una, por ejemplo, se saltan 1000 registros de la secuencia.

Como digo es algo que nunca me he encontrado, así que si alguien tiene idea de lo que puede estar ocurriendo en esta base de datos le agradezco que lo comparta.

Desde Twitter, Daniel Trabas

Desde Twitter, Daniel Trabas (@DaniT20), ha sugerido que podrían ser registros que se eliminen, o transacciones sucias.

Lo de los registros que se eliminen parece demasiado simple, pero tiene mucho sentido, podría haber algún proceso, procedure, aplicación etc. que por alguna razón fuera eliminando esos 1.000 registros, ¿habéis comprobado si os faltan datos o están todos y el hueco está sólo en la numeración?

Yo nunca he visto algo así, pero otra opción que se me ocurre es que por bloqueos o algo así os estén fallando algunas operaciones de insert, pero el contador se incremente igual. ¿Tenéis definidos triggers en las tablas o son todo inserts sin más? Con los triggers podrían pasar cosas de este tipo..

- Inicie sesión para enviar comentarios

En otros foros ha realizado

En otros foros ha realizado la misma consulta, y es un problema que trae sqlserver 2012 sp1, se de colocar en el parametro del trace flag 272, (-t272) con ello desaparece el problema

- Inicie sesión para enviar comentarios

Gracias Hans, ya tenemos otro

Gracias Hans, ya tenemos otro misterio de SQL Server resuelto :)

Enlazo uno de los blogs que he encontrado al buscar 'trace flag 272' donde explican cómo utilizar el parámetro, y también otra manera de evitar el problema, gracias a la opción NOCACHE en la creación de la secuencia:http://jamessql.blogspot.com.es/2013/07/gap-issue-in-sql-server-2012-id…

- Inicie sesión para enviar comentarios

Tengo este problema y no he

Tengo este problema y no he podido solucionarlo alguien me puede comentar si ya lo pudieron solucionar y como?

saludos

- Inicie sesión para enviar comentarios

Esto sucede siempre que se

Esto sucede siempre que se reinicia el computador mientras está funcionando (grabando o leyendo datos) el motor de SQL, y se daña la secuencia de las tablas que estaban en uso. Hasta ahora no he encontrado solución. Me ha tocad siempre que sucede esto, reparar los datos y reinicializar la numeración.

- Inicie sesión para enviar comentarios

Buenas tardes Respecto al uso

Buenas tardes

Respecto al uso de columnas con propiedad Identity.

Valores consecutivos después de un reinicio del servidor u otros errores: SQL Server podría almacenar en memoria caché los valores de identidad por motivos de rendimiento y algunos de los valores asignados podrían perderse durante un error de la base de datos o un reinicio del servidor. Esto puede tener como resultado espacios en el valor de identidad al insertarlo.

Si no es aceptable que haya espacios, la aplicación debe usar mecanismos propios para generar valores de clave. El uso de un generador de secuencias con la opción NOCACHE puede limitar los espacios a transacciones que nunca se llevan a cabo. https://docs.microsoft.com/es-es/sql/t-sql/statements/create-table-transact-sql-identity-property

- Inicie sesión para enviar comentarios

Tiene mucho sentido, desde

Tiene mucho sentido, desde luego si no hay manera de garantizar que nunca se generen estos saltos y es crítico que los id's sean siempre consecutivos, hay que pensar en utilizar otras soluciones, como un mantenimiento independiente de las secuencias en estructuras, o una consulta del último valor para poder generar el siguiente antes de cada inserción, más ineficiente, pero más seguro, gracias por las dos sugerencias.

- Inicie sesión para enviar comentarios

Particionamiento de tablas en SQLServer 2005

Particionamiento de tablas en SQLServer 2005 josimac 18 May, 2008 - 01:05Hola a todos.

Es sabido por todo el mundo de las capacidades de particionamiento que posee Oracle desde sus mas antiguos releases. En Sql Server 2000 existia una especie de "chapuza" para poder hacerlo mediante restricciones "CHECK" en los campos y utilizando vistas mediante UNIONS.

El panorama en SQL Server 2005 a mejorado un poco respecto a eso.

No puedo dar fe absoluta sobre las ventajas de utilizar dicho particionamiento (lo usé en una tabla de hechos con pocos millones de registros) pero al menos es una tecnología más reciente que las "vistas".

PASO 1: Crear una función de partición

CREATE PARTITION FUNCTION [MiFuncionDeParticion] (char(15))

AS RANGE LEFT FOR VALUES ('VALOR1', 'VALOR2', 'VALOR3')

PASO 2: Crear un schema para la partición con el grupo de archivos SQL a utilizar

CREATE PARTITION SCHEME [MiNombreDeSchema]

AS PARTITION [MiFuncionDeParticion] ALL TO ([PRIMARY]) <------- Nombre del grupo de archivos de SQL Server.

PASO 3: Se crea la tabla que va a ser particionada

CREATE TABLE [dbo].[MiTabla] (

[CAMPO1] [int] NOT NULL,

[CAMPO2] [int] NOT NULL,

[CAMPO3] [char](15) COLLATE Modern_Spanish_CI_AS NOT NULL,

[CAMPO4] [char](15) COLLATE Modern_Spanish_CI_AS NOT NULL,

[CAMPO5] [float] NULL

) ON [MiNombreDeSchema] ([CAMPO3])

Existen mas valores de configuración para realizar este tipo de particiones.

Si alquien quiere saber mas...... en la documentación de SQL hay más información y si no, pues podeis preguntar lo que querais.

Saludos,

Yo tengo una tabla con 45

Yo tengo una tabla con 45 millones de registros. Como hago para hacer la particíon con SQL Server 2005? En el ejemplo veo que creas la tabla pero se puede hacer sobre una ya creada?

- Inicie sesión para enviar comentarios

Las tablas particionadas

Las tablas particionadas almacenan los registros separados por particiones, por lo que pasar de una tabla normal a una particionada implicaría mover físicamente todos los datos. No creo que exista ninguna opcion de ALTER TABLE que te permita hacer esto, y si la hubiera seguramente lo que haría es recrear la tabla completa.

Precisamente por el gran volumen de registros que tienes yo te recomendaría crear una tabla vacía particionada, y hacer después una migración de los datos insertándolos en esta tabla particionada, y sin tocar la original, por si algo no sale como esperabas.

Esto además, dependiendo de las condiciones del entorno, te permitirá hacer alguna prueba de rendimiento sobre ambas tablas para comprobar que el particionamiento realmente te beneficia.

Ya nos explicarás..

- Inicie sesión para enviar comentarios

carlos wrote: Las tablas

[quote=carlos]

Las tablas particionadas almacenan los registros separados por particiones, por lo que pasar de una tabla normal a una particionada implicaría mover físicamente todos los datos. No creo que exista ninguna opcion de ALTER TABLE que te permita hacer esto, y si la hubiera seguramente lo que haría es recrear la tabla completa.

Precisamente por el gran volumen de registros que tienes yo te recomendaría crear una tabla vacía particionada, y hacer después una migración de los datos insertándolos en esta tabla particionada, y sin tocar la original, por si algo no sale como esperabas.

Esto además, dependiendo de las condiciones del entorno, te permitirá hacer alguna prueba de rendimiento sobre ambas tablas para comprobar que el particionamiento realmente te beneficia.

Ya nos explicarás..

[/quote]

Exacto...

Particionar una tabla que ya contiene registros los veo una temeridad y más con semejante volumen de registros.

En cualquier caso, creo que no se puede hacer sobre una tabla ya existente.

Saluditos,

- Inicie sesión para enviar comentarios

Ok. Voy a realizar la

Ok.

Voy a realizar la prueba.

Se puede realizar partición sobre cualquier tipo de datos?

Por ej me serviria realizar la particion por un campo "usuario" que es un varchar.

Si me aparecen nuevos usuarios en la tabla, puedo agregar nuevas particiones?

- Inicie sesión para enviar comentarios

Para particionar la tabla has

Para particionar la tabla has de definir los rangos en los que se han de agrupar los registros. Para ello se utiliza la función de particionamiento, que te permite definir estos grupos a partir de los valores de campos de los registros.

Estos campos pueden ser de diferentes tipos de datos. Puedes utilizar campos varchar, de fecha, enteros, etc.

Los nuevos registros entrarán en la partición que les toque según tengas definida la función de particionamiento.

Lo normal es crear rangos, por fechas, o por orden alfabético o numérico.

Aunque se puede hacer, yo no te aconsejaría crear una partición para cada usuario. Primero por lo que tu mismo dices, con cada nuevo usuario tendrías que crear una nueva partición. Segundo, seguro que la distribución de registros por usuario no es muy homogénea, lo más eficiente es que no haya demasiadas diferencias de volumen entre las particiones.

- Inicie sesión para enviar comentarios

Veo que el post tiene ya algo

Veo que el post tiene ya algo de tiempo.. pero espero obtener alguna respuesta. De qué manera puedo establecer la partición de una tabla alfabéticamente, de forma que en una partición se acomoden todos los resgistros que empiecen de la a "a" a la "f", por ejemplo.. es posible hacer eso?

- Inicie sesión para enviar comentarios

Hola Xóchitl Selene Los

Hola Xóchitl Selene

Los valores que pongas en la función de partición son utilizados como rangos SIEMPRE.

Es decir, si miras el siguiente ejemplo:

Crear una función de partición

CREATE PARTITION FUNCTION [MiFuncionDeParticion] (char(1))

AS RANGE RIGHT FOR VALUES ('A', 'G', 'M', 'Z')

Se comportará creando 5 grupos:

1.) < 'A'

2.) >= 'A' y < 'G' (es decir, de la A a la F)

3.) >= 'G' y < 'M'

4.) >= 'M' y < 'Z'

5.) >= 'Z'

Esto te funcionará seguro.

Saludos,

- Inicie sesión para enviar comentarios

Muchas gracias josimac me ha

Muchas gracias josimac me ha servido mucho :).

Tengo otra consulta..

Para hacer un particionamiento vertical como sería??.. Entiendo en teoría q ese particionamiento es para dividir una tabla en varias con menos campos en una relación 1:1, y que juntándolas se forma la misma tabla inicial.. Pero esto significa crear nuevas tablas con los campos divididos??.. No se puede hacer esto de forma lógica tal como se hace en el particionamiento horizontal?? o cómo podría hacerlo para no tener q crear nuevas tablas?

De antemano muchas gracias..

- Inicie sesión para enviar comentarios

Hola de nuevo. Si me permites

Hola de nuevo.

Si me permites la pregunta, ¿para que quieres hacer algo así?

Desde el punto de vista transaccional vas ha incrementar las escrituras en bbdd.

Desde el punto de vista de reporting o dw te verás en la obligación de hacer un diseño lógico del tipo snow-flake con lo que eso comporta (más joins para desnormalizar las tablas).

Si lo que quieres es "particionar" esos datos para , por ejemplo, crear diferentes orígenes de datos que alimenten un cubo OLAP puedes hacerlo mediante vistas de la tabla.

Si nada de que lo que te he dicho te convence.... entonces necesito que me contestes la primera pregunta que te hago.

Saludos,

- Inicie sesión para enviar comentarios

Gracias. Es parte de una

Gracias. Es parte de una práctica de bases de datos distribuidas :). Supongo que tendré que recurrir a la creación de las nuevas tablas.

Por otra parte, regresando al script de particionamiento.. despues de crear la funcion y el esquema de partición he intentado crear la tabla de la siguiente manera:

CREATE TABLE articulos

(

ArtID int identity(1,1) NOT NULL,

ArtLetra char(1) COLLATE Modern_Spanish_CI_AS NOT NULL,

CONSTRAINT PK_Art PRIMARY KEY(ArtID)

) ON practicalAbcDistributionScheme(ArtLetra);

GO

pero al ejecutar me muestra el siguiente mensaje:

La columna 'ArtLetra' es una columna de particionamiento del índice 'PK_Art'. Las columnas de particionamiento de un índice único deben ser un subconjunto de la clave de índice.

--

le quito la linea que hace referencia al campo llave ( CONSTRAINT PK_Art PRIMARY KEY(ArtID) )

y el script es ejecutado de manera correcta.. por qué sucede eso??

Mi solución es declarar los campos sin llaves y después modificarlas para indicarles los campos llave.. pero como se hace para no tener que hacerlo así?

- Inicie sesión para enviar comentarios

Cuando declaras el campo

Cuando declaras el campo "ArtID" como autoincremental le estás asignando una primary key. Cuando la función de particionamiento genere más de una tabla vas a tener codigos iguales en distintas tablas que no van a servirte para nada.

Si quieres utilizar claves surrogadas las vas a tener que gestionar en tiempo de carga, es decir, calcularlas tu. Creo que se queja de eso.

- Inicie sesión para enviar comentarios

Hola, Mi caso es parecido

Hola,

Mi caso es parecido sólo que las particiones están en función de la fecha. Tenemos una tabla ya particionada con unos 40 mill de registros. El caso es que sólo debemos guardar 6 meses, quizás me explico mejor con un ejemplo. Pongamos que estamos en Junio del 2010, mi tabla tendrá 6 particiones ordenadas por fecha que serán las correspondientes a enero, febrero, marzo, ..., y junio, pero al llegar julio, debemos desprendernos de enero para así seguir teniendo 6 particiones que irían desde febrero hasta julio.

¿Me podríais orientar cómo puedo hacer este proceso de reciclado de particiones?

Muchas gracias.

- Inicie sesión para enviar comentarios

Tendrás que hacerlo mediante

Tendrás que hacerlo mediante un script que elimine la partición del mes más antiguo, y cree la del nuevo mes.

Es fácil decirlo, pero no tan trivial de implementar. La eliminación de la partición de ha de hacer de una manera eficiente, sobretodo la tabla particionada es grande, como es tu caso. Hay que evitar que se termine haciendo un delete de cada registro.

Te enlazo algunas entradas del blog de Dan Guzman, que presenta una solución para mover la partición a una tabla auxiliar, sobre la que después se puede hacer un truncate, e incluye los scripts para hacerlo:

Sliding Window Table Partitioning

Automating Sliding Window Maintenance

Automating RANGE RIGHT Sliding Window

Te enlazo de paso Partition Details and Row Counts, que te puede ser de utilidad para obtener información de las particiones.

- Inicie sesión para enviar comentarios

Hola Saludos Se que el post

Hola

Saludos

Se que el post es viejo pero como se hace esto:

Tengo una tabla de ventas con 15.000.000 Millones de registros, dentro de mi tabla hay un campo FechaHora que es la fecha donde se realizo la venta.

Requiero que se haga una particion de la tabla por cada mes del año

Como podria hacer esto ?

En el ejemplo que colocas tu usas RANGE LEFT FOR VALUES ('VALOR1', 'VALOR2', 'VALOR3')

Como podria usar el campo de FechaHora de mi tabla para realizar esta particion?

Estoy usando SQL SERVER 2008 R2

y que significa o que haces con esto

CREATE PARTITION SCHEME [MiNombreDeSchema]

AS PARTITION [MiFuncionDeParticion] ALL TO ([PRIMARY]) , osea esto es el archivo MDF y de LOG de la base de datos?

- Inicie sesión para enviar comentarios

quiero que me ayudes en un

- Inicie sesión para enviar comentarios

Problema con funcion escalar

Problema con funcion escalar gilson 2 Marzo, 2010 - 12:35buen dia a todos, tengo un problema con una funcion escalar, lo que quiero es que me devuelva un tipo de dato money pero al ejecutar la funcion me retorna 0.00, y no se por que esta sucediendo eso

aqui les dejo la codificacion de la funcion

USE [sisfinan]

GO

/****** Object: UserDefinedFunction [dbo].[obtener_total_interes_sistema_aleman] Script Date: 03/02/2010 00:00:08 ******/

SET ANSI_NULLS ON

GO

SET QUOTED_IDENTIFIER ON

GO

create function [dbo].[obtener_total_interes_sistema_aleman]

(

@deuda money,

@plazo smallint,

@tasa real,

)

returns money

as

begin

declare @monto_interes money,@id_cuota smallint, @total_interes money

select @id_cuota = 1;

while @id_cuota <= @plazo

begin

select @monto_interes = @monto_interes + @deuda *(@tasa/100),

@total_interes = @total_interes + @monto_interes,

@deuda = @deuda - @capital

select @id_cuota = @id_cuota +1;

end;

return isnull(@total_interes,0);muchas gracias por su ayuda

saludos

Creo que lo que te falta es

Creo que lo que te falta es inicializar las variables que utilizas en los cálculos. Seguramente intervienen en las operaciones con valor nulo, y por eso el resultado también es nulo.

Asígnale valor inicial 0 a monto_interes y a total_interes, y asegúrate de que deuda se pasa también con un valor definido.

- Inicie sesión para enviar comentarios

hola carlos, ayer justamente

hola carlos, ayer justamente inicialize las variables y me funciona perfectamente, muchas gracias por tu ayuda, ahora tengo

otro pequeño problema, al ejecutar un procedimiento me sale este error Mens 2732, Nivel 16, Estado 1, Procedimiento

sp_ins_propuesta, Línea 449 El número de error 8134 no es válido. El número debe estar comprendido entre 13000 y 2147483647 y no puede ser 50000.,

a que se debera este error por que todos los errores capturo con raiserror('mensaje',16,1)

muchisimas gracias por tu ayuda

saludos

- Inicie sesión para enviar comentarios

Habría que ver el código del

Habría que ver el código del PROCEDURE, pero en algún lugar se tiene que estar asignando el número 8.134 como código de error. Puede que sea en alguna función o procedure a los que llame el principal.

Deberías poder encontrarlo y cambiar ese número por uno mayor que 13.000.

- Inicie sesión para enviar comentarios

ok carlos voy a buscarlo,

ok carlos voy a buscarlo, agradezco mucho tu ayuda, saludos

lo raro es que uso el mismo raiserror para un procedimiento que inserta personas y no tengo ningun problema con ese procedure

- Inicie sesión para enviar comentarios

Problemas con SQL Server 2000

Problemas con SQL Server 2000 gustavoagk 13 Noviembre, 2014 - 08:59Hola;

El motivo de mi tema, es un problema que se ha estado presentando en una aplicación que utiliza SQL Server 2000.

En nuestra empresa, contamos con una aplicación que se desarrollo en Visual basic 5.0, y la DB se encuentra en sql server 2000.

Resulta que hace ya varias semanas ciertos usuarios han tenido problemas de conexion desde la aplicacion de su pc a la DB.

Les indica que la aplicacion no responde, y errroes de conectividad.

Lo que me gustaria saber, que pruebas podria analizar o determinar en el sevidor de base de datos para poder determinar el performance de la DB y corregir en caso de que sea el servidor.

Agracederia su apoyo con respecto a esta problematica.

Saludos

Hola Falta mucha informacion,

Hola Falta mucha informacion, pero a grandes rasgos:

- En que estado se encuentra el servidor?

- Cómo se ha configurado?

- Cual ha sido su mantenimiento?

- Cual es la estrategia de indexación, tratamiento de datos obsoletos?

- Como y en que medida crecen los transaccionales?

- Se ha cambiado/actualizado algo en hard/soft en pc cliente, servidor?

- Que tipo de servicios ha de aguantar el ancho de banda y, cual es la proporción de cada uno de ellos?

Revisa los informes de sql y añadir trazas, revision de monitor y revsion de esperas.

Respondiendo alguna de estas preguntas y posiblemente alguna mas, esta la respuesta:

Lo muy fácil seria actualizar a ,minimo, 2005 y redimensionar el hardware. Pero suena a típico problema de arquitectura, diseño y nulo mantenimiento (los planes de mantenimiento por si mismos son insuficientes), pero en esto ultimo estoy especulando.

Un saludo DBA

- Inicie sesión para enviar comentarios

Problemas en conexiones remotas a servidores de SQL Server

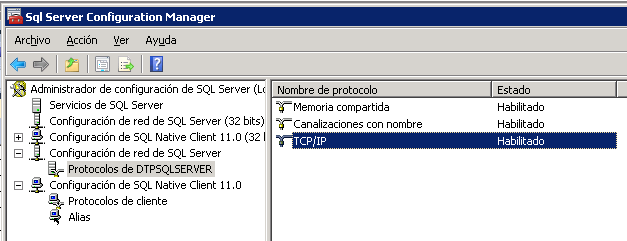

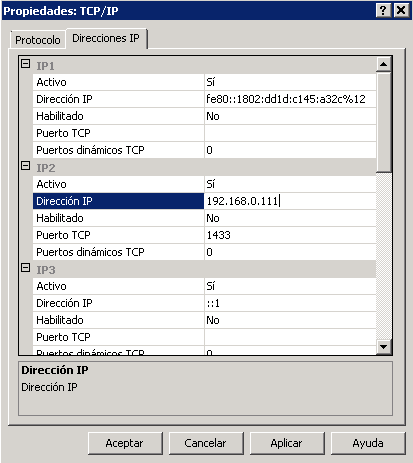

Problemas en conexiones remotas a servidores de SQL Server Carlos 4 May, 2016 - 20:24Recientemente he tenido problemas para establecer una conexión remota a un servidor SQL Server 2012 de mi red. La conexión estaba bien definida, los puertos estaban abiertos, el server permitía conexiones remotas y, sin embargo, no había manera de conectar desde otra máquina, con SQL Server Management Studio, por ejemplo.

Después de mucho revisar descubrí que el problema venía de las opciones de configuración de red de SQL Server, que no estaban bien definidas en el servidor. Lo apunto aquí por si le pasa a alguien más. En mi caso tenía deshabilitado el protocolo 'Canalizaciones con nombre', y ha de estar habilitado, y en las propiedades del protocolo TCP/IP faltaba incluir la IP del servidor, y el puerto TCP, normalmente el 1433.

Todo esto se configura abriendo el 'Administrador de configuración de SQL Server' o 'SQL Server Configuration Manager' desde el menú de aplicaciones de Microsoft SQL Server, subcarpeta 'Herramientas de configuración'.

Como una imagen vale más que 1.000 palabras, esta es la captura de pantalla de la configuración que me ha resuelto el problema de conexión remota a SQL Server.

Espero que sirva de ayuda!

Sos Grande Amigo Gracias por

Sos Grande Amigo Gracias por tu aporte. Mi problema era una conexion que se desconectaba, pero desde otro segmento de la red. En el local si funcionaba, el remoto por vpn NO, me ayudo mucho tu aporte para revisar...

- Inicie sesión para enviar comentarios

Hola Emmanuel, me alegro que

Hola Emmanuel, me alegro que te haya servido de ayuda!

Enlazo un post donde explico con más detalle cómo configurar el server SQL para permitir conexiones remotas

- Inicie sesión para enviar comentarios

Muy buenas

Muy buenas noches,

Anteriormente yo tuve el mismo problema, solo que en mi caso y, al utilizar un equipo con Windows, tuve que hacer una configuración adicional en el "Firewall de Wondows". El cual consistia en generar una regla de entrada y una regla de salida con el puerto 1433. El procedimiento es el siguiente:

- Hay que entrar en Panel de Control - Firewall de Windows.

- Después situarse en configuración avanzanda.

- Seleccionamos la opción de regla de entrada/Nueva regla.

- Dentro de la ventana que aparece (Tipo de regla) seleccionamos "Puerto" y le damos siguiente.

- Apare la ventana con titulo "Protocolo y puertos", aquí se deja la opción de TCP seleccionada y escribimos el mismo puerto que se habilito en 'Administrador de configuración de SQL Server", es decir, el 1433 y damos siguiente.

- Se selecciona permitir la conexión y se da siguiente.

- El siguiente punto o ventana que aparece es Perfil se deja como esta y se presiona "Siguiente".

- Posteriormente pide se asigne un nombre al puerto, en mi caso le puse "SQL Giro", que es el sistema de nóminas con el que estamos trabajando.

- Por último damos en finalizar.

- Ahora tenemos que ir al apartado de "Reglas de salida" y damos de nueva cuenta "Nueva Regla" e iniciamos con los mismos pasos antes mencionados.

De esta manera yo desde mi lugar de trabajo, el cual esta en otra oficina aunque en el mismo edificio pude acceder a la Base de Datos de SQL Server, aunque en nuestro caso es 2008.

Hay otra opción que te pudiera recomendar, el cual es mediante una NoIP realizar la triangulación de acceso a tu servidor, pero para ello se debe de hacer una configuración previa en el router que se utiliza y conectarte por ejemplo desde tu casa.

Para que quede un poco mas claro lo anterior, pongo un tutorial donde viene explicado lo que menciona Carlos y la configuración adicional que les comento.

Video:

Saludos.

Martín Flores.

- Inicie sesión para enviar comentarios

Gracias por tu aportación

Gracias por tu aportación Martín.

Aprovecho para añadir que, aunque no es lo habitual, si en un mismo servidor se instala más de una instancia de SQL Server el servicio 'SQL Server Browser' ha de estar habilitado, ya que este servicio dirige las conexiones entrantes hacia el puerto correspondiente según la instancia de la conexión.

Tener SQL Server Browser deshabilitado es otra posible causa de error de conexión remota en servidores con varias instancias de SQLServer. Este servicio también necesita disponer de un puerto UDP abierto en el firewall, por defecto el 1434.

Saludos!

- Inicie sesión para enviar comentarios

SQL Server

SQL Server lagunas876 17 Diciembre, 2015 - 16:46Me sale el siguiente mensaje de error cuando una aplicación envía una consulta:

Msj 605, nivel 21, estado 3, línea 1

Intentar recuperar la página lógica (1: 224) en la base de datos de 11 fracasado. Pertenece a la unidad de asignación no 72058253744865280-72057594040287232

¿Que esta mal?

Si DBCC CHECKDB o CHECKTABLE

Si DBCC CHECKDB o CHECKTABLE informa de un error (que debe ser Msj 2533), la página está dañado o una página incorrecta. Usted debe restaurar desde una copia de seguridad para resolver el problema. Si no puede restaurar desde una copia de seguridad, utilice las opciones de reparación con DBCC CHECKDB. Para encontrar la causa de este problema se debe utilizar técnicas como lo haría con otros errores de corrupción de base de datos que incluye:

Compruebe si hay problemas de hardware o de nivel de sistema (Una herramienta como SQLIOSim puede ser útil para hacer esto. Barcos SQLIOSim con SQL Server 2008 y SQL Server 2008 R2 y no requiere una descarga por separado)

Asegúrese de que tiene la opción de base de datos = CHECKSUM PAGE_VERIFY encendido. Si bien es posible todavía encontrar un 605 error Msj con suma de verificación habilitado (Ex. "Escribidor" problema o una página incorrecta proporcionada desde el sistema de E / S), lo que permite la suma de comprobación puede proporcionar la prueba definitiva de que la página fue modificada de forma incorrecta en el que el sistema de E / S .

Trate de restaurar una copia de seguridad de base de datos que sabe que será "limpio" (sin errores de CHECKDB) y copias de seguridad del registro de transacciones sabes abarcan el momento en que se encuentra el error. Si usted puede "reproducir" este problema mediante la restauración de una copia de seguridad de base de datos "limpios" y los registros de transacciones póngase en contacto con soporte técnico de Microsoft para obtener ayuda.

Para obtener más información acerca de los problemas de corrupción de base de datos ver aquí:

Recovery Toolbox for SQL Server https://sql.recoverytoolbox.com/es/

- Inicie sesión para enviar comentarios

Saltarse las constraints en SQL Server

Saltarse las constraints en SQL Server Anonimo (no verificado) 8 Septiembre, 2009 - 18:13Tengo que hacer una carga masiva de datos en muchas tablas de SQL Server que tienen definidas bastantes constraints, sobretodo claves foráneas (FK) entre tablas.

He intentado seguir un orden para cargarlas para que no me devuelva errores de restricciones de integridad, pero son tantas que no consigo encontrar el orden correcto.

Estoy pensando ya en eliminar las FK de todas las tablas, pero seguro que hay alguna manera mejor de solucionarlo.

Alguien me puede ayudar?

Las constraints de una tabla

Las constraints de una tabla de SQL Server se pueden desactivar temporalmente con la opción NOCHECK CONSTRAINT ALL de ALTER TABLE.

El comando quedaría así:

ALTER TABLE tabla NOCHECK CONSTRAINT ALL;

Con esto se desactivan y puedes hacer la carga de datos sin que te molesten las FK

Después, para volver a activarlas sólo tienes que hacer este otro ALTER TABLE:

ALTER TABLE tabla WITH CHECK CHECK CONSTRAINT ALL;

Reactiva las constraints chequeando que los datos de las tablas las cumplan

Si quieres volver a habilitarlas sin validar los datos que hayas cargado, aunque no es muy recomendable también se puede hacer:

ALTER TABLE tabla CHECK CONSTRAINT ALL;

Espero que te sea de ayuda,

- Inicie sesión para enviar comentarios

¿Y no habrá ningun tipo de

¿Y no habrá ningun tipo de problema en cuanto los datos/registros que hayas modificado una vez vuelvas a activar las CONSTRAINTS?

Por ejemplo si yo cambio el valor de un campo, el cual lo esta cogiendo de una primary key de otra tabla, al volver a a activar las CONSTRAINTS, ¿No habrá conflictos?

- Inicie sesión para enviar comentarios

Justamente al desactivar los

Justamente al desactivar los constraints pierdes la garantía de que los datos respetan el modelo relacional, y entonces la responsabilidad es tuya con las modificaciones que hagas, que una vez terminadas han de seguir manteniendo la integridad referencial del modelo, o al menos de los constraints que haya definidos.

Es decir, que tendrás conflictos al reactivarlos sólo si no respetas las reglas que definen los constraints.

- Inicie sesión para enviar comentarios

Utilización del monitor del sistema para supervisar recursos

Utilización del monitor del sistema para supervisar recursos Carlos 21 Julio, 2010 - 00:53En el tema de Scripts y consultas útiles de Oracle Fernando pregunta cómo consultar con una query los cursores abiertos en la base de datos.

No sé si se puede hacer directamente con una consulta, como en Oracle, pero como mínimo se puede utilizar la utilidad Monitor del sistema para controlar temas de rendimiento, y consultar indicadores y medidas de rendimiento sobre cursores y otros objetos de la base de datos y del sistema.

Para abrir la aplicación hay que ejecutar en el Windows donde esté instalada la instancia de SQL Server, desde el menú inicio o desde linea de comandos el programa perfmon.

Enlazo la ayuda en linea de Microsoft TechNet donde se hace referencia a los objetos de SQL Server que se pueden monitorizar, y también a la parte que concreta los indicadores del objeto Cursor Manager by Type, cuyo primer contador es el número de cursores activos.