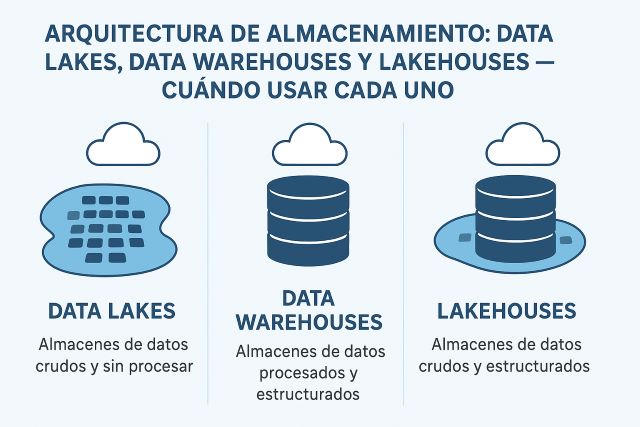

1. El contexto histórico: de silos a lagos

Durante décadas, el data warehouse reinó como paradigma central del almacenamiento analítico. Empresas como Teradata, Oracle e IBM construyeron imperios sobre sistemas MPP (Massively Parallel Processing) optimizados para consultas SQL sobre datos estructurados. El proceso era claro: extraer datos operacionales, transformarlos según un esquema rígido (schema-on-write) y cargarlos en el data warehouse para su análisis.

Este modelo funcionó brillantemente hasta que no lo hizo. La explosión de datos no estructurados —logs de aplicaciones, datos de IoT, contenido multimedia, flujos de eventos— reveló las limitaciones del data warehouse tradicional. No solo resultaba prohibitivamente caro almacenar petabytes de datos semiestructurados, sino que la rigidez del esquema impedía la experimentación ágil que demandaban los científicos de datos.

En 2010, James Dixon acuñó el término "data lake" para describir un repositorio que almacena datos en su formato nativo, permitiendo exploración flexible sin transformación previa. La promesa era seductora: almacenamiento barato en sistemas distribuidos (típicamente Hadoop HDFS o S3), schema-on-read, y libertad para que analistas y científicos de datos exploraran sin las restricciones del warehouse.

Sin embargo, muchos data lakes derivaron en "data swamps": repositorios caóticos sin gobernanza, donde los datos se acumulaban sin catálogo, calidad ni lineage. La pendiente de expectación de Gartner se cumplió: tras el pico de expectativas infladas vino el valle de la desilusión.

Ahora, en 2025, asistimos a una convergencia. El lakehouse emerge como arquitectura que combina la flexibilidad del lake con las garantías transaccionales y el rendimiento del warehouse, usando formatos abiertos como Delta Lake, Apache Iceberg o Apache Hudi.

2. Data Warehouse: el clásico optimizado

2.1 Características fundamentales

Un data warehouse es un sistema diseñado específicamente para análisis. Sus principios arquitectónicos incluyen:

Schema-on-write: Los datos se transforman y estructuran al momento de carga según un modelo dimensional (típicamente estrella o copo de nieve). Esto garantiza consistencia pero requiere esfuerzo de modelado previo.

Optimización para lecturas complejas: Almacenamiento columnar, índices especializados, particionado inteligente y estadísticas automáticas. Motores como Snowflake, BigQuery o Redshift aplican técnicas de compresión y pruning agresivas.

Rendimiento predecible: Los SLAs son claros. Una consulta sobre 100 millones de filas debe completarse en segundos, no minutos.

Gestión integrada: Copias de seguridad automáticas, recuperación point-in-time, gestión de concurrencia y gestión de cargas de trabajo.

Coste por rendimiento: Históricamente alto. Los data warehouses on-premise requerían inversión en hardware especializado. Las soluciones cloud han democratizado el acceso, pero el coste por TB procesado sigue siendo superior al del almacenamiento del objeto.

2.2 Cuándo elegir un data warehouse

Esta arquitectura destaca en escenarios donde se dan:

Consultas estructuradas predecibles: Si su organización ejecuta dashboards recurrentes, informes financieros o análisis con patrones conocidos, el warehouse ofrece un rendimiento óptimo.

Gobernanza estricta: Industrias reguladas (banca, salud, seguros) valoran la trazabilidad, auditoría y control de acceso granular que ofrecen los data warehouses modernos.

Usuarios de negocio como consumidores principales: Los analistas de negocio prefieren interfaces SQL y herramientas BI tradicionales. El data warehouse proporciona una capa semántica clara con métricas ya calculadas.

Volumetría manejable de datos estructurados: Si su volumen de datos analíticos no supera decenas de TBs y es principalmente estructurado (transacciones, CRM, ERP), el data warehouse es suficiente y eficiente.

2.3 Limitaciones y consideraciones

Coste en escala: Snowflake o BigQuery pueden resultar económicos para volúmenes moderados, pero los costes se disparan con petabytes. El precio por consulta ejecutada puede generar sorpresas desagradables.

Rigidez en esquemas: Modificar el modelo dimensional requiere planificación. Aunque los data warehouses modernos soportan datos semiestructurados (JSON en columnas VARIANT), la experiencia no es óptima.

Vendor lock-in: Migrar de un warehouse a otro es complejo. Las sintaxis SQL difieren, las optimizaciones son propietarias, y las integraciones con herramientas BI están profundamente acopladas.

3. Data Lake: flexibilidad y economía a escala

3.1 Principios arquitectónicos

Un data lake almacena datos en formato nativo (CSV, JSON, Parquet, Avro, logs sin procesar) en sistemas de almacenamiento distribuido baratos: S3, Azure Data Lake Storage (ADLS), Google Cloud Storage (GCS), o HDFS.

Schema-on-read: El esquema se interpreta al momento de consulta. Esto permite almacenar datos sin transformación previa, agilizando la ingesta.

Separación de almacenamiento y cómputo: A diferencia de los data warehouses tradicionales, en un datalake puede escalar el almacenamiento (S3) independientemente de las capacidades de procesamiento (Spark, Presto, Athena).

Multimodalidad: El lake admite datos estructurados, semiestructurados y no estructurados: tablas relacionales, logs JSON, imágenes, vídeos, documentos PDF.

Economía: El coste de almacenamiento en S3 Standard es ~$0.023/GB/mes. Con tiering (S3 Intelligent-Tiering, Glacier), puede reducirse aún más. Esto contrasta con los $10-50/TB/mes típicos de un data warehouse gestionado.

3.2 Cuándo elegir un data lake

Datos no estructurados o semiestructurados: Si ingiere logs de aplicaciones, streams de eventos IoT, contenido multimedia o documentos, el datalake es prácticamente obligatorio.

Exploración y ciencia de datos: Los científicos de datos necesitan libertad para experimentar. El data lake permite iterar sobre datos brutos sin el cuello de botella de ETL previa.

Archivo histórico: Para cumplimiento regulatorio o análisis retrospectivo, el lake permite almacenar años de datos históricos a un coste marginal.

Workloads diversos: Si diferentes equipos necesitan procesar los mismos datos con herramientas variadas (Spark para ML, Presto para SQL ad-hoc, herramientas especializadas para logs), el lake centraliza sin prescribir el motor.

3.3 Los riesgos del data swamp

Sin gobernanza, el data lake degenera rápidamente:

Pérdida de catalogación: Sin gestión de metadatos, los usuarios no encuentran los datos. ¿Qué contiene el bucket s3://data-prod/events/2023/? ¿Quién lo creó? ¿Está actualizado?

Calidad inconsistente: Los datos duplicados, corruptos o desactualizados se acumulan. Sin validación en la ingesta, basura entra, basura sale.

Rendimiento impredecible: Una consulta sobre Parquet bien particionado vuela. La misma consulta sobre JSONs sin comprimir se muere. La variabilidad frustra a los usuarios.

Seguridad laxa: El datalake tradicional carece de control de acceso granular a nivel de fila o columna. Típicamente se protege a nivel de bucket o prefijo, insuficiente para datos sensibles.

Ausencia de transacciones ACID: Hasta la aparición de formatos como Delta Lake, los lakes no garantizaban atomicidad. Una escritura fallida podía dejar archivos parciales. Las lecturas concurrentes durante escrituras generaban inconsistencias.

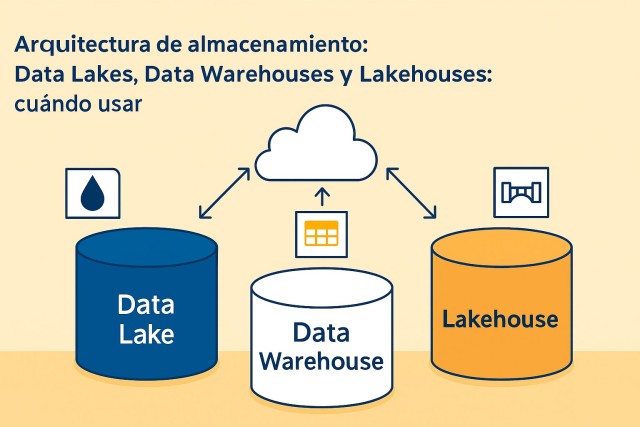

4. Lakehouse: la convergencia

4.1 La propuesta de valor

El lakehouse busca combinar la economía y flexibilidad del datalake con las garantías y rendimiento del data warehouse. Los tres proyectos principales que habilitan esta arquitectura son:

Delta Lake (Databricks): Formato de almacenamiento sobre Parquet que añade una capa transaccional. Garantiza ACID, time travel, evolución de esquemas y operaciones merge . Databricks lo impulsa como estándar abierto.

Apache Iceberg (Netflix, posteriormente Apache Foundation): Formato de tabla que gestiona metadatos separados del almacenamiento. Soporta evolucion de esquemas, evolución d particiones, y operaciones eficientes como UPDATE y DELETE sobre data lakes.

Apache Hudi (Uber, posteriormente Apache Foundation): Diseñado para upserts incrementales eficientes. Permite ingestar streams continuos con baja latencia y mantener tablas actualizadas en el lake.

Estas tecnologías comparten principios:

- ACID sobre object storage: Transacciones garantizadas usando logs de transacciones y metadata versionada.

- Time travel: Consultar el estado de una tabla en cualquier punto temporal histórico.

- Schema evolution: Añadir, renombrar o cambiar tipos de columnas sin reescribir todos los datos.

- Rendimiento comparable a data warehouses: Mediante técnicas como Z-ordering, compactación de ficheros o estadísticas de columnas.

4.2 Arquitectura técnica del lakehouse

Un lakehouse típico se compone de:

Capa de almacenamiento: S3, ADLS o GCS almacenan archivos Parquet/ORC con metadata transaccional.

Capa de metadata: Un catálogo (Hive Metastore, AWS Glue Catalog, Unity Catalog) registra tablas, esquemas y particiones.

Motor de consulta: Spark, Trino/Presto, o motores nativos como Databricks SQL ejecutan consultas sobre las tablas.

Capa de gobernanza: Unity Catalog, Apache Ranger o AWS Lake Formation proporcionan control de acceso fino, auditoría y linaje de datos.

El flujo típico:

- Datos brutos ingresan al lake en zona "bronze" (raw).

- Pipelines Spark transforman y escriben a zona "silver" (cleaned/conformed) usando Delta Lake para garantizar atomicidad.

- Agregaciones de negocio se materializan en zona "gold" (business-ready) con modelos dimensionales o esquema en estrella.

- Los usuarios consultan tablas gold con herramientas BI o SQL. El rendimiento es comparable a un data warehouse.

4.3 Cuándo elegir lakehouse

Necesidad de economía + rendimiento: Si su organización tiene petabytes de datos pero no puede asumir costes de data warehouse a esa escala, el lakehouse permite almacenamiento barato con queries rápidas sobre subconjuntos.

Workloads mixtos: Combina ciencia de datos (notebooks sobre raw data) con BI tradicional (SQL sobre tablas curadas). Un único repositorio sirve a ambos casos.

Requerimientos de gobernanza avanzada: Unity Catalog y similares ofrecen RBAC a nivel de columna, enmascaramiento dinámico de datos sensibles y auditoría completa.

Modernización gradual: Puede migrar desde un data warehouse tradicional sin tirar todo. Coexisten durante la transición.

4.4 Retos y consideraciones

Complejidad operacional: Gestionar un lakehouse requiere expertise en Spark, formatos transaccionales, compactación de archivos y tuning de metadatos. No es plug-and-play.

Madurez del ecosistema: Aunque Delta Lake y Iceberg son estables, la integración con herramientas BI tradicionales aún está madurando. No todas las herramientas soportan todas las características.

Lock-in de formato: Aunque Delta, Iceberg y Hudi son "open", cada uno tiene peculiaridades. Migrar entre ellos no es trivial.

Rendimiento vs warehouse puro: Un Snowflake o BigQuery optimizados siguen siendo más rápidos para ciertas consultas complejas. El lakehouse es "suficientemente rápido" para la mayoría de casos, pero no siempre el más rápido.

5. Matriz de decisión: ¿qué arquitectura para qué escenario?

| Criterio | Data Warehouse | Data Lake | Lakehouse |

|---|---|---|---|

| Coste almacenamiento ($/TB/mes) | Alto ($50-200) | Muy bajo ($1-5) | Bajo ($2-10) |

| Rendimiento consultas estructuradas | Excelente | Variable (malo a bueno) | Bueno a muy bueno |

| Soporte datos no estructurados | Limitado | Excelente | Muy bueno |

| Garantías ACID | Nativas | No (tradicionalmente) | Sí (con Delta/Iceberg/Hudi) |

| Gobernanza y seguridad | Madura | Básica (nivel bucket) | Avanzada (con catálogos modernos) |

| Facilidad de uso (BI users) | Alta (SQL estándar) | Baja | Media-alta |

| Complejidad operacional | Baja-media (gestionado) | Media-alta | Alta |

| Flexibilidad para data science | Baja | Alta | Alta |

| Vendor lock-in | Alto | Bajo | Medio |

| Time-to-production | Rápido (soluciones maduras) | Medio (requiere setup) | Medio-largo (requiere expertise) |

La elección impacta directamente en CapEx, OpEx y time-to-insight. Un data warehouse tradicional puede costar 10-15× más por TB que un data lake, pero ofrece rendimiento predictible. Un lakehouse promete lo mejor de ambos mundos, pero requiere madurez técnica. No existe una solución única: la mayoría de empresas maduras operan arquitecturas híbridas.

5.1 Casos de uso por arquitectura

Data Warehouse puro:

- Empresa de retail mediano (500 tiendas) con análisis de ventas, inventario y finanzas estructurados.

- Startup fintech en crecimiento con datasets < 10 TB y foco en dashboards ejecutivos.

- Organización gubernamental con requisitos estrictos de auditoría sobre datos estructurados.

Data Lake puro:

- Plataforma de streaming de video que almacena petabytes de contenido multimedia y logs de visualización.

- Empresa industrial con IoT: millones de sensores generando telemetría continua que se procesa batch.

- Centro de investigación biomédica con datasets genómicos, imágenes médicas y datos clínicos heterogéneos.

Lakehouse:

- E-commerce global con catálogo de productos (estructurado), logs de clickstream (semiestructurado) y recomendaciones ML.

- Banco digital que necesita análisis regulatorio (warehouse-like) y detección de fraude en tiempo real (ML sobre streams).

- Empresa de logística con tracking de envíos (estructurado), imágenes de paquetes (no estructurado) y optimización de rutas (data science).

6. Arquitecturas híbridas y coexistencia

La realidad en empresas maduras raramente es binaria. Las arquitecturas híbridas son la norma:

6.1 Warehouse + Lake (dos capas)

Patrón: El data lake almacena datos brutos y archivos. Pipelines ETL cargan subconjuntos al data warehouse para análisis de negocio.

Ventaja: Segrega cargas de trabajo. El data warehouse ofrece rendimiento predecible para reporting; el data lake permite experimentación sin impactar en producción.

Reto: Duplicación de datos, sincronización compleja y potencial inconsistencia temporal.

Ejemplo: Una aseguradora mantiene 10 años de pólizas históricas en S3 (acceso infrecuente). Los últimos 18 meses se cargan a Snowflake para análisis actuarial diario.

6.2 Lakehouse con warehouse especializado

Patrón: El lakehouse es el repositorio central. Un warehouse pequeño (ej. Snowflake con datasets específicos) sirve casos de altísima concurrencia o queries críticas.

Ventaja: Economía del lakehouse con rendimiento premium para casos de uso selectos.

Reto: Complejidad en la orquestación y sincronización.

Ejemplo: Una empresa de medios almacena todo en Delta Lake. Las métricas de audiencia en tiempo real se replican a BigQuery para dashboards ejecutivos con SLA < 1 segundo.

6.3 Multi-warehouse para jurisdicciones

Patrón: Data warehouses separados por región para cumplimiento (GDPR, residencia de datos). El data lake centraliza datos no sensibles.

Ventaja: Cumplimiento y gobernanza por región sin duplicar toda la infraestructura.

Reto: Gestión de políticas de acceso cross-region y agregaciones globales.

Ejemplo: Una multinacional europea mantiene warehouses en EU, US y APAC para datos de clientes, pero centraliza datos de producto en un lakehouse global.

7. Migración: del warehouse al lakehouse (o viceversa)

7.1 Estrategia de migración warehouse → lakehouse

Fase 1: Inventario y priorización

- Catalogar tablas, volumetría, patrones de acceso y consumidores.

- Priorizar tablas por ROI: alto volumen + bajo uso → migrarse primero (máximo ahorro).

Fase 2: Implementación de PoC

- Seleccionar 2-3 tablas no críticas.

- Replicar a Delta Lake/Iceberg en el lake.

- Comparar rendimiento, coste y complejidad operacional.

Fase 3: Migración por oleadas

- Dividir en zonas: bronze (raw replication), silver (transformaciones), gold (modelos de negocio).

- Mantener data warehouse operativo en paralelo durante 6-12 meses.

- Migrar consumidores gradualmente: primero data science, luego BI.

Fase 4: Decommission del warehouse

- Una vez validado que todos los workloads funcionan en lakehouse, apagar data warehouse.

- Mantener backups durante periodo de retención regulatorio.

Errores comunes:

- Migrar todo de golpe sin validación.

- Subestimar el esfuerzo de reescribir SQL (dialectos difieren).

- No capacitar a los equipos en las nuevas herramientas.

7.2 Estrategia de migración lake → warehouse (casos de consolidación)

A veces, la decisión correcta es ir en sentido contrario:

Caso: Una startup creció rápidamente usando un lake Hadoop on-premise. Ahora, con 50 empleados y datasets manejables (5 TB), la complejidad operacional del lake no se justifica.

Estrategia:

- Auditar calidad de datos en el lake.

- Diseñar modelo dimensional en Snowflake/BigQuery.

- Construir pipelines ELT desde S3 al warehouse usando dbt.

- Desactivar cluster Hadoop, mantener S3 como archivo.

Resultado: Reducción de 60% en OpEx (adiós a administradores Hadoop), mejora en SLAs de queries, mayor satisfacción de usuarios de negocio.

8. Selección de software: criterios prácticos

8.1 Data Warehouses gestionados

Snowflake:

- Fortalezas: Escalado automático, separación cómputo/almacenamiento, marketplace de datos, multicloud.

- Debilidades: Coste puede dispararse con uso intensivo. Pricing por segundo de cómputo.

- Ideal para: Empresas que priorizan facilidad de uso y no quieren gestionar infraestructura.

Google BigQuery:

- Fortalezas: Serverless total, pricing por TB escaneado, integración nativa con GCP, ML integrado (BigQuery ML).

- Debilidades: Menos control sobre ejecución de queries, algunos límites en concurrencia.

- Ideal para: Organizaciones en Google Cloud que valoran simplicidad y capacidades ML integradas.

Amazon Redshift:

- Fortalezas: Integración profunda con AWS, Redshift Spectrum permite queries sobre S3, coste más predecible con nodos reserved.

- Debilidades: Requiere más tuning que Snowflake, menos ágil en el escalado.

- Ideal para: Empresas AWS-first con equipos expertos en tuning de bases de datos.

Azure Synapse Analytics:

- Fortalezas: Unifica data warehouse con Spark, integración con Power BI y Azure ML.

- Debilidades: Complejidad en configuración, curva de aprendizaje.

- Ideal para: Empresas Microsoft-centric que necesitan integración end-to-end.

8.2 Plataformas lakehouse

Databricks:

- Fortalezas: Plataforma completa con Delta Lake nativo, Unity Catalog para gobernanza, Databricks SQL para BI, MLflow para ML.

- Debilidades: Coste premium, vendor lock-in (aunque Delta es open, la plataforma no).

- Ideal para: Organizaciones que buscan una plataforma todo-en-uno con fuerte foco en data science.

AWS Lake Formation + Athena/EMR:

- Fortalezas: Flexibilidad total, compatible con Iceberg/Hudi, coste bajo para queries ad-hoc (Athena es serverless).

- Debilidades: Requiere ensamblar múltiples servicios (Glue, Athena, EMR, S3), complejidad operacional.

- Ideal para: Equipos AWS con expertise técnico que prefieren componentes best-of-breed.

Azure Fabric (antes Synapse):

- Fortalezas: Integración de lakehouse + BI + ML en una plataforma, OneLake como almacenamiento unificado.

- Debilidades: Aún en evolución, menor madurez que alternativas.

- Ideal para: Clientes Azure que apuestan por la visión unificada de Microsoft.

Starburst/Trino:

- Fortalezas: Query engine federado que puede consultar múltiples orígenes (data lake, data warehouse, bases de datos operacionales) sin mover datos.

- Debilidades: No es un lakehouse completo, requiere otros componentes para escritura transaccional.

- Ideal para: Arquitecturas heterogéneas que necesitan capa de consulta unificada.

8.3 Criterios de selección

Al evaluar plataformas, considere:

- Cloud strategy: ¿Single cloud o multicloud? Snowflake y Databricks ofrecen multicloud; BigQuery y Redshift no.

- Volumetría y crecimiento proyectado: Warehouses son competitivos hasta ~50-100 TB. Más allá, el lakehouse ofrece mejor economía.

- Skills del equipo: ¿Tienen expertise en Spark? Un lakehouse tiene sentido. ¿El equipo es principalmente SQL? Un warehouse será más productivo.

- Workloads críticos: Si tiene SLAs estrictos (< 1 segundo para dashboards ejecutivos), un warehouse puro puede ser necesario para esos casos.

- Necesidades de gobernanza: ¿Requiere control de acceso a nivel de celda, enmascaramiento dinámico, auditoría forense? Evalúe las capacidades de gobernanza de cada plataforma.

- Budget: Solicite PoCs con datasets reales y mida costes. Las calculadoras de precios son orientativos; los patrones reales de uso revelan la verdad.

9. Antipatrones y errores comunes

9.1 El "lakehouse" que es solo un lake mal gobernado

Síntoma: Anuncian migración a lakehouse, pero solo almacenan Parquet en S3 sin capa transaccional, sin catálogo actualizado y sin métricas de calidad.

Consecuencia: Usuarios frustrados por rendimiento inconsistente, datos duplicados, ausencia de lineage.

Solución: No basta con usar Parquet. Debe implementar Delta Lake/Iceberg/Hudi, establecer políticas de compactación, y mantener el catálogo actualizado.

9.2 Mantener dos copias sincronizadas manualmente

Síntoma: Tienen data warehouse y data lake, replican datos entre ambos con scripts cron frágiles. Desincronización frecuente.

Consecuencia: Informes con números diferentes según la fuente consultada. Pérdida de confianza en los datos.

Solución: Elegir una fuente de verdad (single source of truth). Si necesita ambos, usar CDC o herramientas de replicación automática con alertas de lag.

9.3 Sobre-ingenierizar para volumetría actual

Síntoma: Startup con 100 GB de datos implementa lakehouse complejo con Spark, Airflow, Delta Lake y Unity Catalog.

Consecuencia: Overhead operacional enorme, equipo de datos dedicado 70% del tiempo a mantener infraestructura.

Solución: Arranque simple. Con volúmenes pequeños, un PostgreSQL o BigQuery es suficiente. Evolucione la arquitectura cuando el dolor lo justifique.

9.4 Ignorar data tiering

Síntoma: Todos los datos históricos en almacenamiento hot (S3 Standard), aunque raramente se consultan.

Consecuencia: Costes innecesarios. Con 1 PB en S3 Standard ($23k/mes) vs S3 Glacier Deep Archive ($1k/mes), el ahorro es sustancial.

Solución: Implementar políticas de lifecycle en S3/ADLS. Datos no consultados en 90 días → tier frío. Datos legales > 7 años → Glacier.

9.5 No probar consultas reales antes de migrar

Síntoma: Basarse en benchmarks sintéticos (TPC-H) para decidir plataforma.

Consecuencia: Sorpresas post-migración. La query que corría en 10 segundos en el data warehouse ahora tarda 2 minutos en el lakehouse.

Solución: PoC con consultas reales, datasets reales y patrones de concurrencia reales. 2-4 semanas de pruebas ahorran meses de frustración.

10. Caso real: migración lakehouse en una fintech latinoamericana

10.1 Contexto

Empresa: Fintech de créditos al consumo, 2M de clientes, 200 empleados.

Situación inicial (2022):

- Redshift con 18 TB de datos transaccionales.

- Coste mensual: $8,500 (nodos reserved) + $2,200 (Spectrum sobre S3).

- Pain points: costes crecientes lineales con datos, dificultad para integrar modelos ML, lag de 6 horas en reportes de riesgo.

Objetivo: Reducir costes 40%, habilitar ML en tiempo cuasi-real, mejorar agilidad del equipo de data science.

10.2 Estrategia adoptada

Decisión: Migrar a lakehouse con Databricks + Delta Lake sobre S3.

Fases (9 meses):

Mes 1-2: PoC y diseño

- Replicar 3 tablas críticas (transacciones, clientes, scoring) a Delta Lake.

- Benchmark de queries críticos: 8 dashboards ejecutivos, 5 modelos ML.

- Resultado: rendimiento comparable, coste proyectado 50% menor.

Mes 3-5: Implementación de bronze/silver

- Replicación CDC desde PostgreSQL (producción) a Delta Lake bronze usando Debezium.

- Pipelines Spark transforman bronze → silver con validaciones de calidad.

- Unity Catalog para control de acceso.

Mes 6-7: Migración de consumidores

- Científicos de datos migran primero (acceso directo a silver/bronze).

- Materializan tablas gold con modelos dimensionales para BI.

- Herramienta BI (Looker) conecta a Databricks SQL sobre tablas gold.

Mes 8: Validación y switchover

- Operación dual: Redshift y lakehouse en paralelo.

- Comparación diaria de métricas críticas: discrepancias < 0.01%.

- Switchover en fin de semana: apagar Redshift, redirigir todo al lakehouse.

Mes 9: Decommission y optimización

- Desactivar Redshift.

- Optimizar compactación Delta, Z-order en claves de lookup frecuente.

10.3 Resultados (6 meses post-migración)

Coste mensual: $4,800 (reducción de 55%).

- Databricks compute: $3,200

- S3 storage (30 TB con tiering): $600

- Data transfer y otros: $1,000

Rendimiento:

- Queries de dashboards: mejora de 15% (gracias a Z-ordering).

- Lag de reportes de riesgo: de 6 horas a 20 minutos (pipelines streaming).

- Time-to-market de modelos ML: de 3 semanas a 1 semana (acceso directo a raw data).

Lecciones aprendidas:

- La fase de validación dual (mes 8) fue crítica. Detectaron 2 discrepancias en lógica de agregación que habrían causado una crisis si switcheaban sin validar.

- El equipo de data science adoptó rápidamente. El equipo de BI tuvo curva de aprendizaje más pronunciada (Databricks SQL difiere sutilmente de Redshift).

- Unity Catalog simplificó gobernanza, pero requirió 2 semanas de capacitación inicial.

Recomendación del CIO: "No habríamos podido hacer esta migración sin un sponsor ejecutivo claro y un equipo dedicado full-time durante 9 meses. Intentar hacerlo 'en el lado' habría fracasado."

11. Checklist operativo

Para evaluar su situación actual:

□ Inventariar volumetría de datos por tipo (estructurado, semiestructurado, no estructurado).

□ Calcular coste total actual (TCO): licencias, cómputo, almacenamiento, personal operativo.

□ Identificar pain points críticos: ¿performance? ¿coste? ¿rigidez? ¿escalabilidad?

□ Mapear patrones de acceso: ¿quiénes consumen datos? ¿con qué frecuencia? ¿qué herramientas?

□ Evaluar madurez del equipo: ¿expertise en SQL? ¿en Spark? ¿en infraestructura cloud?

□ Auditar gobernanza actual: ¿tienen catálogo? ¿lineage? ¿control de acceso granular?

□ Proyectar crecimiento: volumetría y complejidad analítica a 12, 24 y 36 meses.

Para decidir arquitectura objetivo:

□ Si volumetría < 10 TB y workloads principalmente SQL → considerar data warehouse gestionado.

□ Si volumetría > 100 TB o datos mayormente no estructurados → considerar data lakehouse o data lake.

□ Si necesitan ML intensivo + BI tradicional → lakehouse es probable mejor opción.

□ Si gobernanza estricta es crítica → validar capacidades específicas de cada plataforma.

□ Si tienen múltiples clouds → opciones multicloud (Snowflake, Databricks) tienen ventaja.

□ Si quieren evitar vendor lock-in → arquitectura basada en formatos abiertos (Iceberg) + query engines open-source (Trino).

Para ejecutar migración:

□ Definir sponsor ejecutivo y equipo dedicado (mínimo 2-3 FTEs durante 6-12 meses).

□ Establecer métricas de éxito: reducción coste %, mejora rendimiento %, adopción usuarios %.

□ Implementar PoC con 2-3 casos de uso representativos (4-6 semanas).

□ Diseñar arquitectura objetivo detallada: zonas (bronze/silver/gold), herramientas, flujos.

□ Establecer plan de migración por oleadas: priorizar por ROI y riesgo.

□ Implementar pipelines de replicación/sincronización para operación dual.

□ Planificar período de validación (mínimo 4 semanas) con métricas comparativas.

□ Desarrollar runbooks de rollback en caso de problemas críticos.

□ Capacitar equipos: sesiones técnicas para ingenieros, talleres para analistas de negocio.

□ Comunicar hitos y cambios a stakeholders: transparencia reduce resistencia.

□ Post-migración: monitorizar costes semanalmente durante 3 meses (curva de aprendizaje).

□ Optimizar continuamente: compactación, particionado, Z-ordering, tiering.

Para operación continua:

□ Establecer políticas de data tiering: hot (< 30 días), warm (30-180 días), cold (> 180 días).

□ Implementar monitorización de costes: alertas cuando consumo semanal supera baseline +20%.

□ Mantener catálogo de datos actualizado: automatizar descubrimiento de esquemas.

□ Documentar patrones de acceso y optimizaciones: knowledge base para el equipo.

□ Realizar reviews trimestrales de arquitectura: ¿sigue siendo óptima para cargas de trabajo actuales?

□ Evaluar nuevas características de plataformas: Delta Lake, Iceberg, y data warehouses evolucionan rápido.

□ Formación continua: certificaciones en plataforma elegida para el equipo core.

□ Disaster recovery: tests de recuperación semestrales (no solo backups, sino restauración completa).

12. El futuro: hacia dónde evoluciona el almacenamiento analítico

12.1 Tendencias emergentes

Formatos de tabla abiertos como estándar: Los tres grandes (Delta, Iceberg, Hudi) están convergiendo en funcionalidades. Iceberg gana tracción como estándar verdaderamente neutral (Apache, sin vendor principal). Esperamos ver en 2025-2026 mayor interoperabilidad: un motor que pueda leer/escribir cualquier formato sin fricción.

Query engines desacoplados: Motores como Trino, Presto, DuckDB y Apache Datafusion permiten consultar data lakes sin mover datos. Esto reduce la dependencia de data warehouses propietarios y habilita arquitecturas de "query federation" donde un SQL puede tocar data warehouse, data lake, bases operacionales y SaaS APIs simultáneamente.

Streaming como default: La distinción entre batch y streaming se difumina. Apache Flink, Kafka Streams y Delta Live Tables permiten pipelines que procesan datos en "micro-batches" continuos. El lakehouse mantiene tablas actualizadas con latencias de segundos, no horas.

AI-native data platforms: Las plataformas empiezan a integrar capacidades de búsquedas de vector nativas (embeddings para LLMs), permitiendo que el mismo lakehouse almacene datos estructurados y representaciones vectoriales para retrieval-augmented generation (RAG).

Compute pushdown e in-situ processing: En lugar de mover datos al compute, el compute se ejecuta donde residen los datos. S3 Select, Snowflake's Iceberg Tables, y BigQuery's external tables muestran esta tendencia. Reduce latencia y costes de transferencia.

12.2 Predicciones para 2026-2028

El data warehouse tradicional se convierte en nicho premium: Seguirá existiendo para casos de altísima concurrencia (cientos de usuarios simultáneos) y SLAs estrictos, pero la mayoría de nuevas implementaciones elegirán lakehouse.

Consolidación de plataformas: Esperamos adquisiciones. Los grandes clouds (AWS, Azure, GCP) mejorarán sus ofertas lakehouse nativas para competir con Databricks. Snowflake integrará más profundamente capacidades de lake (ya lo hace con Iceberg support).

Open table formats como commodity: Delta, Iceberg y Hudi serán tan comunes como Parquet lo es hoy. La elección se basará en ecosistema de herramientas, no en funcionalidades (que serán equivalentes).

Gobernanza descentralizada (data mesh): En lugar de un lakehouse monolítico, las organizaciones grandes implementarán múltiples lakehouses por dominio (ventas, finanzas, operaciones), con catálogo y lineage federados.

Costes de almacenamiento seguirán cayendo, el de computación se mantiene: S3 Glacier Deep Archive ya está en $0.99/TB/mes. Esto hace inviable competir en almacenamiento. La diferenciación será en eficiencia computacional, optimización de queries y experiencia de desarrollo.

12.3 Implicaciones para su estrategia

No apueste por una única arquitectura a perpetuidad: La tecnología evoluciona rápido. Diseñe con interfaces y abstracciones que permitan cambiar componentes sin reescribir todo (ej. dbt como capa de transformación, abstrayendo el motor subyacente).

Invierta en formatos abiertos: Evite formatos propietarios. Iceberg y Delta (open-source) le dan más portabilidad que un formato exclusivo de un proveedor.

Las capacidades de gobernanza serán diferenciadoras: La plataforma que mejor resuelva el linaje automático, la monitorización de la caildad de datos y el control de acceso fino ganará. Priorice esto sobre rendimiento marginal.

Prepárese para arquitecturas híbridas complejas: La mayoría de empresas tendrán warehouse + lakehouse + bases de datos operacionales + data mesh. La complejidad está en la orquestación y gobernanza unificada, no en cada componente individual.

13. Recursos y lecturas recomendadas

Libros fundamentales:

- "The Data Warehouse Toolkit" - Ralph Kimball y Margy Ross

Clásico sobre modelado dimensional. Aunque enfocado en warehouses tradicionales, los principios de diseño de modelos estrella son aplicables a lakehouses. - "Designing Data-Intensive Applications" - Martin Kleppmann

Capítulos sobre almacenamiento columnar, LSM-trees y sistemas distribuidos son esenciales para entender lakehouse internals. - "Data Mesh" - Zhamak Dehghani

Perspectiva sobre arquitecturas descentralizadas. Complementario para organizaciones grandes que consideran múltiples lakehouses por dominio.

Whitepapers y artículos técnicos:

- "Lakehouse: A New Generation of Open Platforms that Unify Data Warehousing and Advanced Analytics" (Databricks, 2021)

Paper original que define el concepto lakehouse. Lectura obligatoria. - "Delta Lake: High-Performance ACID Table Storage over Cloud Object Stores" (VLDB 2020)

Paper académico con detalles de implementación de transacciones ACID sobre S3.

Documentación oficial:

- Databricks Lakehouse Platform Docs: docs.databricks.com

Arquitectura de referencia, best practices, Unity Catalog guides. - AWS Lake Formation Workshop: github.com/aws-samples/aws-lake-formation-workshop

Labs prácticos para implementar lakehouse en AWS con Glue, Athena y Lake Formation. - Snowflake Architecture Guide: docs.snowflake.com/architecture

Documentación técnica sobre separación compute/storage, micro-partitions y clustering.

Comparativas y benchmarks:

- "Cloud Data Warehouse Benchmark Report" - Fivetran (anual)

Comparativa de Snowflake, BigQuery, Redshift y Azure Synapse en queries TPC-DS. - "Lakehouse Performance Study" - OneHouse (2025)

Benchmark de Delta Lake vs Iceberg vs Hudi en escenarios de upserts masivos y queries analíticas.

Blogs y recursos continuos:

- Databricks Blog (https://databricks.com/blog): Casos de uso, nuevas features de Delta Lake, best practices.

- AWS Big Data Blog (aws.amazon.com/blogs/big-data): Arquitecturas de referencia para lakehouses en AWS.

- Select Star SQL (selectstarsql.com): Tutoriales SQL interactivos útiles para usuarios migrando a nuevas plataformas.

Comunidades y eventos:

- Data Council Conference: Conferencia anual con tracks sobre data architecture. Talks disponibles en YouTube.

- Subsurface Data Conference: Evento de Databricks con deep-dives técnicos en lakehouse.

- dbt Community: Aunque centrado en transformación, muchas discusiones sobre arquitecturas warehouse vs lakehouse.

Cursos y certificaciones:

- "Data Engineering on Google Cloud" (Coursera)

Incluye módulos sobre BigQuery, Dataflow y arquitectura lakehouse en GCP. - "Databricks Certified Data Engineer Professional"

Certificación que cubre Delta Lake, Spark optimization y Unity Catalog en profundidad. - "AWS Certified Data Analytics - Specialty"

Certificación que incluye Lake Formation, Redshift Spectrum y arquitecturas híbridas.

Herramientas de evaluación:

- Calculadora TCO de Snowflake: snowflake.com/pricing-calculator

Estima costes basándose en volumetría y patrones de uso. - AWS Pricing Calculator: calculator.aws

Para modelar costes de Redshift, Athena, EMR, S3 en arquitectura lakehouse. - Databricks Pricing Tool: Disponible bajo request con sales team. Útil para comparar con warehouse actual.

14. Conclusión: la arquitectura correcta es la que evoluciona con usted

No existe una respuesta universal a "¿data warehouse, data lake o lakehouse?". La decisión correcta depende de su contexto específico: volumetría actual y proyectada, composición de los datos, madurez del equipo, restricciones presupuestarias y objetivos de negocio.

Algunas organizaciones prosperan con un Snowflake simple y elegante que resuelve el 90% de necesidades sin complejidad. Otras requieren la flexibilidad de un lakehouse sobre S3 para manejar petabytes heterogéneos. Muchas necesitan arquitecturas híbridas que combinan ambos paradigmas.

Los principios que perduran:

1. Comience simple, evolucione cuando el dolor lo justifique.

Una startup con 50 GB de datos no necesita un lakehouse distribuido. PostgreSQL es suficiente. Evolucione cuando los síntomas (costes, performance, complejidad de queries) sean evidentes.

2. La gobernanza no es opcional, es foundational.

Sin catálogo, lineage y políticas de calidad, cualquier arquitectura degenera en caos. Invierta en gobernanza desde día uno, no como afterthought.

3. El coste total incluye operaciones, no solo licencias.

Un data warehouse gestionado puede costar más en licencias pero ahorrar en personal operativo. Un data lakehouse puede ser más barato en computación pero requerir ingenieros especializados. Calcule TCO honestamente.

4. Pruebe con datos reales antes de decidir.

Los benchmarks sintéticos (TPC-H, TPC-DS) son orientativos, pero sus queries reales, con sus datos reales y sus patrones de concurrencia reales, son lo único que importa. Invierta 4-6 semanas en una PoC seria.

5. Mantenga opciones abiertas.

Use formatos abiertos (Parquet, Iceberg, Delta open-source), herramientas de transformación portables (dbt), y evite APIs propietarias profundamente acopladas. La portabilidad le da poder de negociación y flexibilidad estratégica.

6. La arquitectura de datos es un viaje, no un destino.

Lo que funciona hoy puede no funcionar en 18 meses. Diseñe para evolucionar: modularidad, observabilidad y capacidad de migrar componentes sin reescribir todo el stack.

En el próximo capítulo exploraremos cómo diseñar esquemas y modelos de datos que escalen, independientemente de la arquitectura de almacenamiento que haya elegido. Exploraremos cuándo normalizar, cuándo desnormalizar, y cómo adaptar el modelado dimensional clásico a las realidades de los sistemas distribuidos modernos. Porque incluso la plataforma más sofisticada fracasa si los datos están mal modelados.

Puntos clave para llevarse:

- Data warehouses brillan en consultas estructuradas predecibles con gobernanza estricta, pero su coste escala linealmente con volumetría.

- Data lakes ofrecen economía y flexibilidad para datos heterogéneos, pero requieren disciplina férrea para no convertirse en data swamps.

- Lakehouses prometen lo mejor de ambos mundos mediante formatos transaccionales (Delta, Iceberg, Hudi), pero requieren madurez técnica y expertise en Spark.

- Arquitecturas híbridas son la norma en empresas maduras: warehouse para BI crítico, lake para experimentación, coexistiendo de manera orquestada.

- La migración es un proyecto de 6-12 meses que requiere sponsor ejecutivo, equipo dedicado, PoC rigurosa y período de validación dual.

- La decisión correcta no es permanente: diseñe para evolucionar usando formatos abiertos, abstracciones portables y métricas objetivas de éxito.