Descubriendo el Business Intelligence

Descubriendo el Business Intelligence respinosamilla 25 Febrero, 2010 - 17:27.gif) Hola a todos:

Hola a todos:

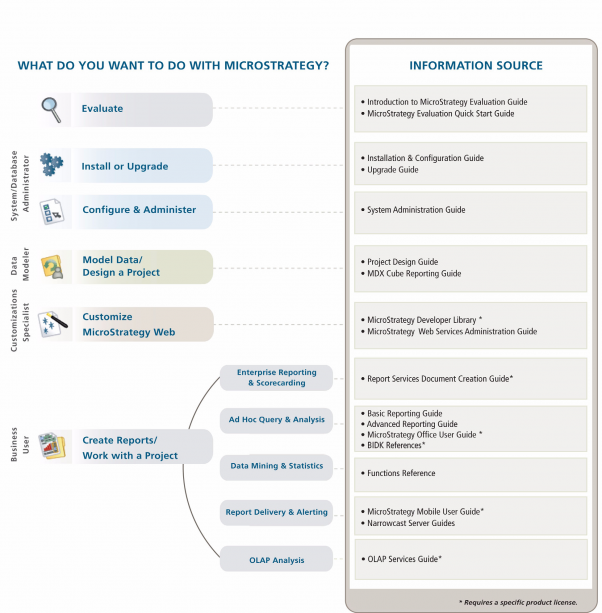

Soy Roberto, un profesional de la informática en el mundo SAP. Hace unos años trabaje en un proyecto de Business Intelligence en una de las empresas donde estuve, con un Datawarehouse para Analisis de Ventas utilizando herramientas de MicroStrategy.

Desde ese momento, siempre me quedo el gusanillo de dedicarme a profundizar en esa materia, quedandome con las ganas de especializarme en algo tan interesante y con tanto potencial de futuro.

Ahora, diez años despues (debe de ser la llegada de los 40, que están a la vuelta de la esquina), he recogido fuerzas para retomar el tema. Desde este foro espero ir contandoos mis evoluciones, descubrimientos e inquietudes.

Objetivo: formarme en el mundo BI y compartir con vosotros la experiencia (por si a alguien le puede ayudar o resultar interesante).

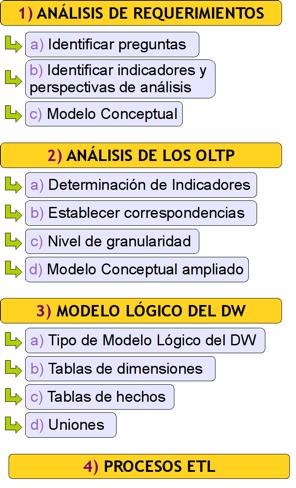

Roadmap:

1) Introducción y profundización en la teoría del Business Intelligence.

2) Definición de un proyecto base enfocado a una experiencia de empresa final.

3) Diseño e Implementación del proyecto utilizando herramientas Open y herramientas Propietarias.

4) Seguimiento del proyecto, documentación y comparativas entre las herramientas utilizadas.

5) Publicación de los resultados. Conclusiones

Cualquier ayuda se agradece de antemano

Empecemos…

¿Qué es Business Intelligence?

¿Qué es Business Intelligence? respinosamilla 25 Febrero, 2010 - 17:29Qué es Business Intelligence o Inteligencia de Negocio exactamente? Ha llegado el momento de entenderlo.

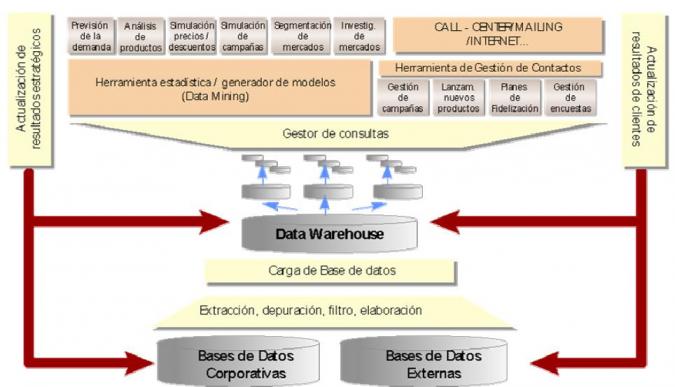

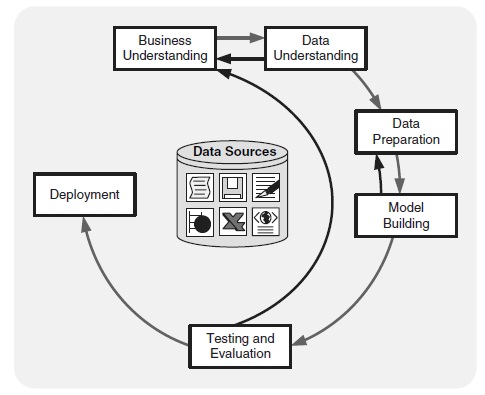

De forma general, el BI suele definirse como la transformación de datos de la compañia en conocimiento para obtener una ventaja competitiva. Si lo asociamos directamente a las tecnologías de la información, podemos definir Business Intelligence como el conjunto de metodologías, aplicaciones y tecnologías que permiten reunir, depurar y transformar datos de los sistemas transaccionales e información desestructurada (interna y externa a la compañia) en información estructurada para su explotación directa (reporting, análisis OLAP, mineria de datos, etc.) o para su análisis y conversión en conocimiento como soporte a la toma de decisiones sobre el negocio.

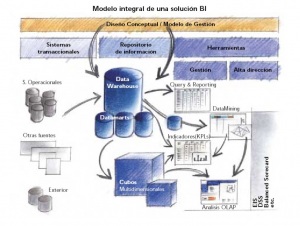

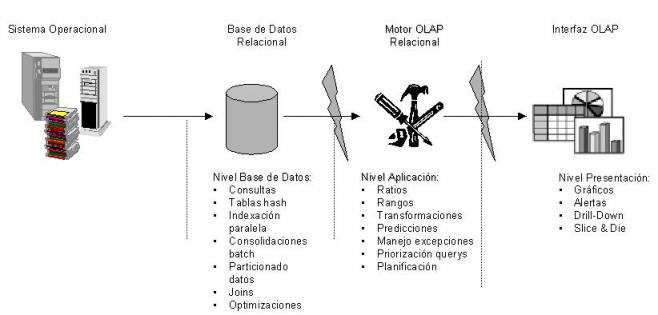

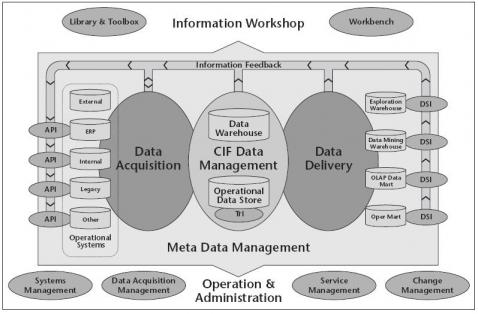

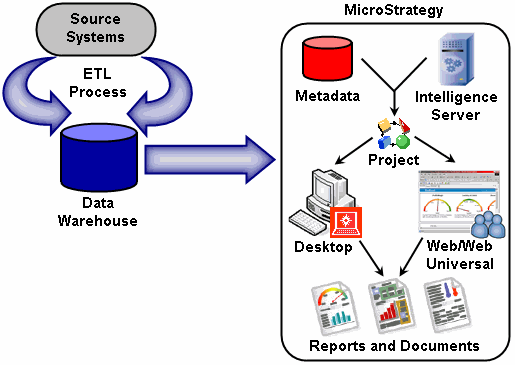

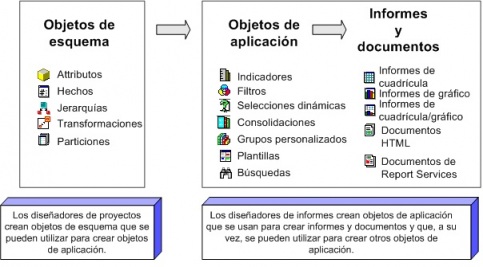

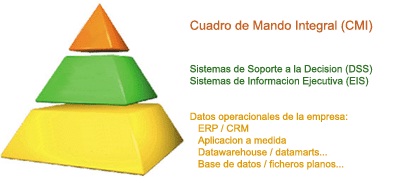

Para empezar a entender conceptos, nada mejor que un esquema básico que incluye los elementos mas comunes de un sistema BI.

Imagen obtenida del documento de la empresa Ibermatica (muy buenas definiciones sobre qué es Business Intelligence para entrar en calor):

En la Wikipedia también se define qué son los sistemas de Business Intelligence

Definición de Business Intelligence

El término Business Intelligence o inteligencia empresarial se refiere al uso de datos en una empresa para facilitar la toma de decisiones. Abarca la comprensión del funcionamiento actual de la empresa, bien como la anticipación de acontecimientos futuros, con el objetivo de ofrecer conocimientos para respaldar las decisiones empresariales.

También lo podriamos definir como el proceso de convertir datos en conocimiento y conocimiento en acción, para la toma de decisiones. Algo así como la siguiente ecuacción:

Datos + Análisis = CONOCIMIENTO

Podriamos igualmente describir BI como el concepto que integra por un lado el almacenamiento y por otro lado el procesamiento de grandes cantidades de datos, con el principal objetivo de transformarlos en conocimiento y en decisiones en tiempo real, a través de un sencillo análisis y exploración. Al contar con la información exacta y en tiempo real, es posible identificar y corregir situaciones antes de que se conviertan en problemas o perdidas de control, permitiendonos igualmente identificar oportunidades o readaptarnos antes los cambios que se vayan produciendo.

Las herramientas de inteligencia se basan en la utilización de un sistema de información de inteligencia que se forma con distintos datos extraídos de los datos de producción, con información relacionada con la empresa o sus ámbitos y con datos económicos.

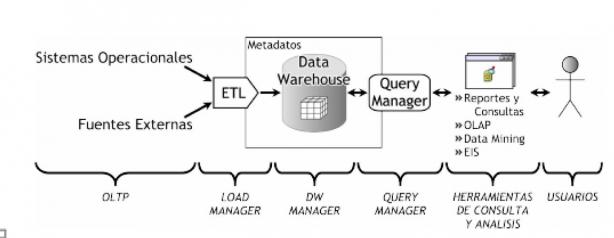

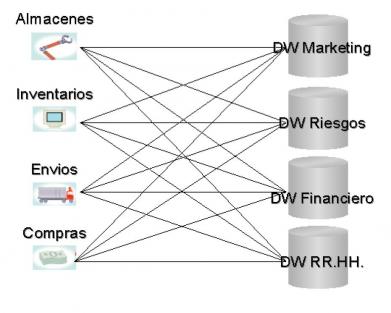

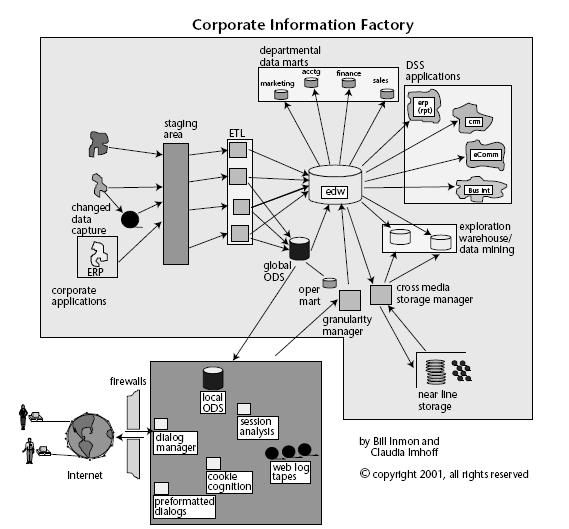

Mediante las herramientas y técnicas ELT (extraer, cargar y transformar), o actualmente ETL (extraer, transformar y cargar) se extraen los datos de distintas fuentes, se depuran y preparan (homogeneización de los datos) para luego cargarlos en un almacén de datos. Los origenes de datos habituales pueden ser las aplicaciones de Gestión Empresarial (ERP´s), estudios de mercado, ficheros de datos internos o externos a la empresa en diferentes formatos y destructurados, etc. El almacén de datos o Datawarehouse es una base de datos enfocada exclusivamente al análisis de la información, por lo que se utiliza, según el uso que se la vaya a dar, técnicas especificas de diseño a la hora de construirla. Los datos provenientes de diferentes fuentes se normalizan para poder integrarlos de forma conjunta y posibilitar el posterior análisis.

Por último, las herramientas de inteligencia analítica posibilitan el analísis de esta información que hemos incluido en el DataWarehouse con diferentes metodologías, objetivos y tecnologías, como veremos mas adelante en mas detalle.

Características de herramientas y metodologías de BI

Este conjunto de herramientas y metodologías tienen en común las siguientes características:

- Accesibilidad a la información. Los datos son la fuente principal de este concepto. Lo primero que deben garantizar este tipo de herramientas y técnicas será el acceso de los usuarios a los datos con independencia de la procedencia de estos.

- Apoyo en la toma de decisiones. Se busca ir más allá en la presentación de la información, de manera que los usuarios tengan acceso a herramientas de análisis que les permitan seleccionar y manipular sólo aquellos datos que les interesen.

- Orientación al usuario final. Se busca independencia entre los conocimientos técnicos de los usuarios y su capacidad para utilizar estas herramientas.

Niveles de realización de BI (Herramientas de Explotacion)

De acuerdo a su nivel de complejidad se pueden clasificar las soluciones de Business Intelligence en:

- Consultas e informes simples (Querys y reports).

- Cubos OLAP (On-Line Analytic Processing). Exploración, tablas dinámicas, etc.

- EIS: Soluciones que permiten visualizar, de una forma rápida y fácil, el estado de una determinada situación empresarial, presente o pasada, y que permite detectar anomalías o oportunidades.

- DSS: Aplicación informática que basándose en modelos matemáticos y mediante análisis de sensibilidad permite ayudar a la toma de decisiones.

- Data Mining o minería de datos: Pueden considerarse sistemas expertos que nos permiten “interrogar a los datos” para obtener información

- KMS: nuevas tecnologias para la gestión del conocimiento y su integración en una única plataforma.

En definitiva, una solución BI completa, utilizando la combinación de estos elementos, nos permitiria:

- Observar ¿qué está ocurriendo?

- Comprender ¿por qué ocurre?

- Predecir ¿qué ocurriría?

- Colaborar ¿qué debería hacer el equipo?

- Decidir ¿qué camino se debe seguir?

A continuación, veremos un poco mas en profundidad en que consiste el Datawarehouse, así las diferentes soluciones de BI que podremos desarrollar, profundizando en la teoría de cada una de ellas.

Y como para aprender no hay nada como escuchar y leer a los que hace algún tiempo tuvieron el mismo proposito que nosotros (aprender sobre el mundo BI), os recomiendo el link:

Business Intelligence, por donde empezar, donde el bloguero Salvador Ramos contesta a un hipotetico asistente a un curso sobre los pasos a seguir para formarse en la materia.

Recomendación eBook de BI

Para terminar, os recomiendo que os leais el libro: Business Intelligence: Competir con información de Josep Lluis Cano (gracias a Miguel Angel Perez por encontrarlo).

El libro es un recorrido muy completo por todos los componentes y terminologia del Business Intelligence, desde aspectos generales, teoria, modelado de datos, componentes que forman un sistema BI, elementos a considerar en un proyecto, criterios para selección de herramientas. Incluye lista de herramientas de BI mas importantes (también OpenSource) y ejemplos prácticos de proyectos en diferentes compañias (Cortefiel, Codorniu, Loteria y Apuestas del Estado, etc.), identificando las herramientas que se usaron en cada uno de ellos, objetivos, implementadores. Ademas incluye muchos ejemplos prácticos de cada concepto conforme se van desarrollando dentro del libro.

Totalmente recomendable.

Hola buen dia Primeramente

Hola buen dia

Primeramente felicitando por este blog, interesante informacion respecto a BI.

He estado tratando de bajar las herramientas que mencionas para el trabajo del proyecto que expones.

Solo que algunas versiones se batalla para bajarlas. Tendras las herramientas ya disponibles para poderlas

bajar desde este blog.

Saludos.

- Inicie sesión para enviar comentarios

Hola, ¿puedes concretar a qué

Hola, ¿puedes concretar a qué herramientas de BI te refieres?

- Inicie sesión para enviar comentarios

Soluciones de Business Intelligence

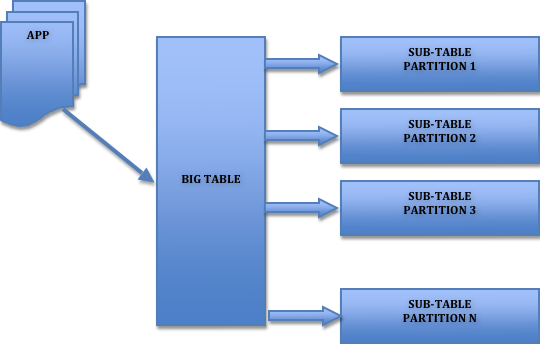

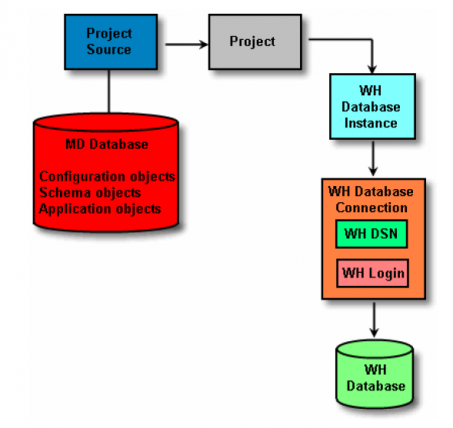

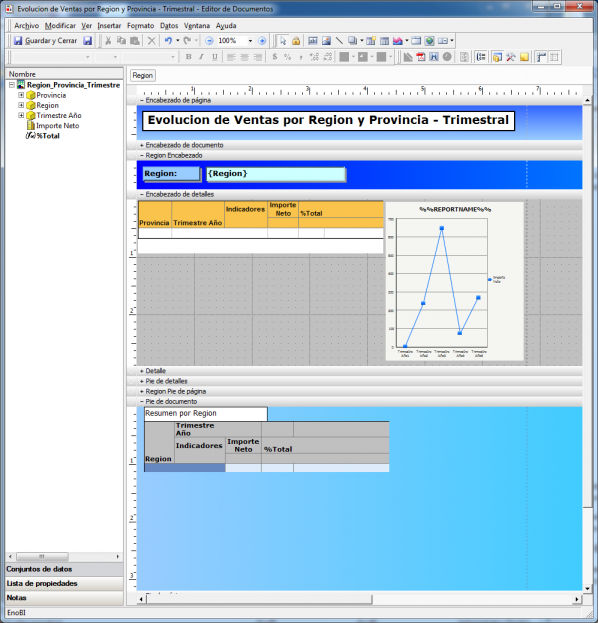

Soluciones de Business Intelligence respinosamilla 25 Febrero, 2010 - 20:55Un esquema simplificado de los elementos que conforman un sistema Business Intelligence podría ser el siguiente:

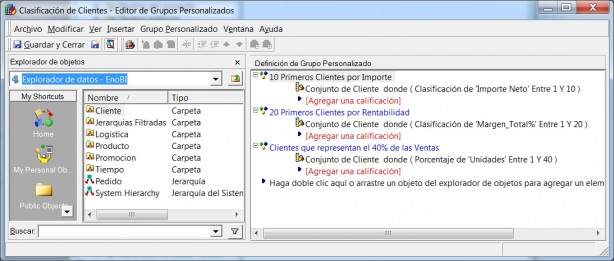

De acuerdo a su nivel de complejidad se pueden clasificar las soluciones de Business Intelligence en:

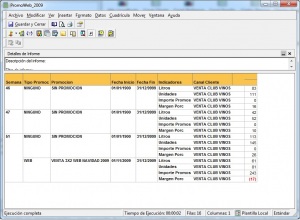

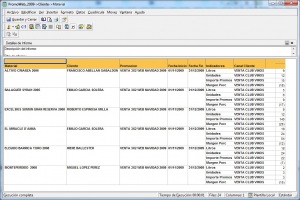

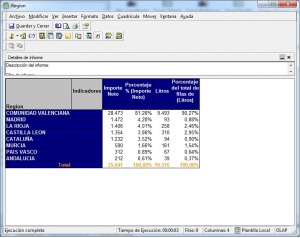

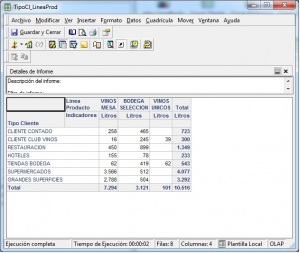

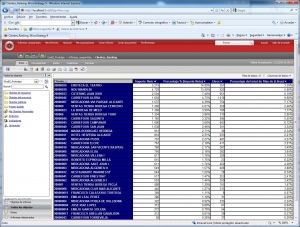

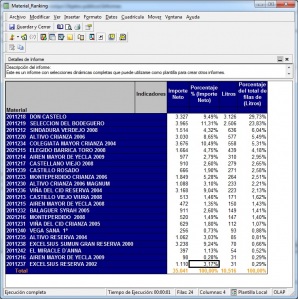

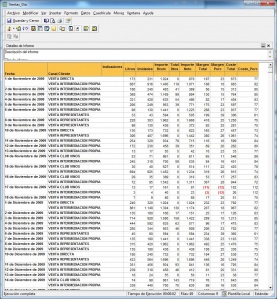

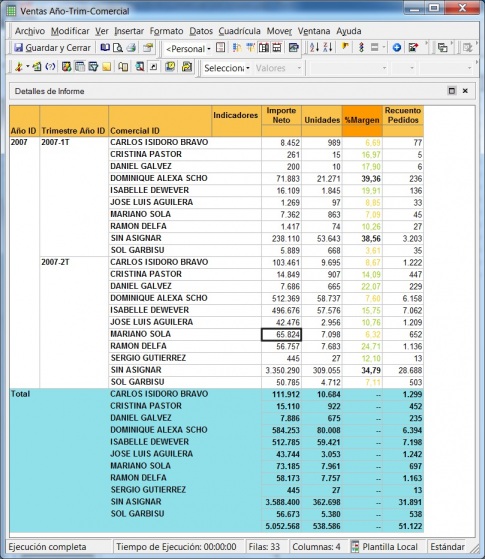

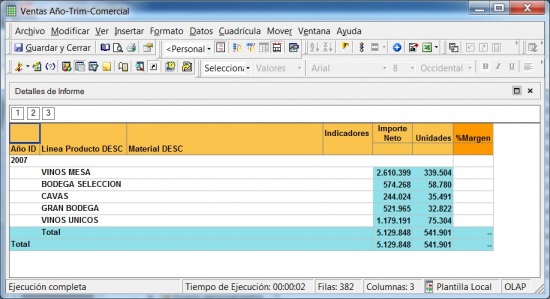

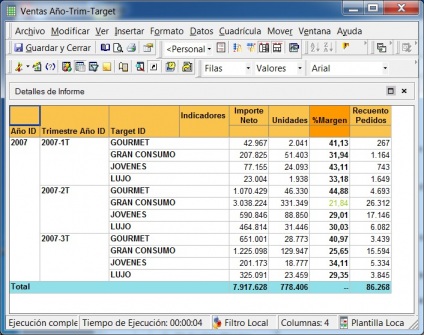

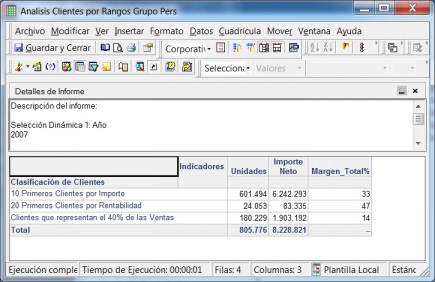

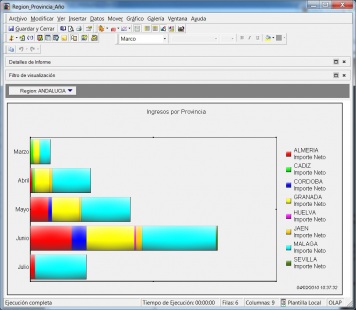

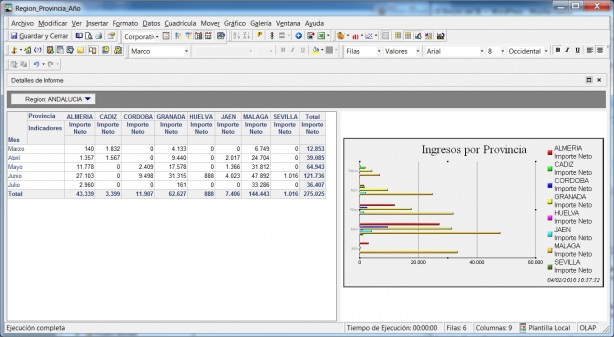

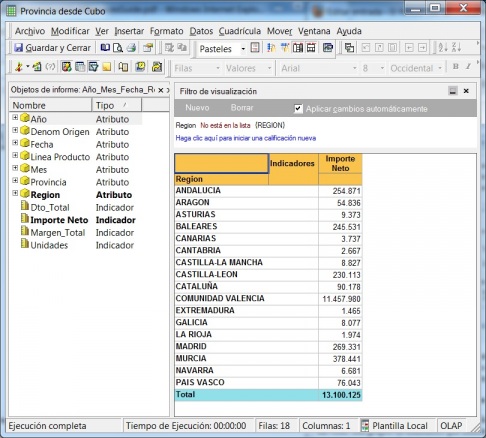

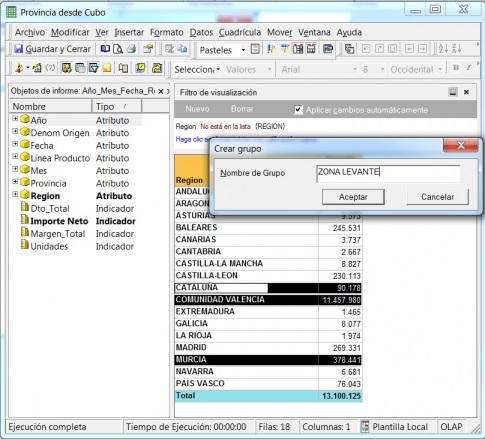

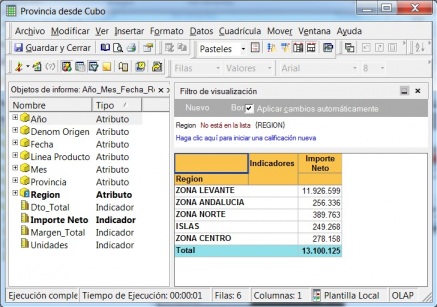

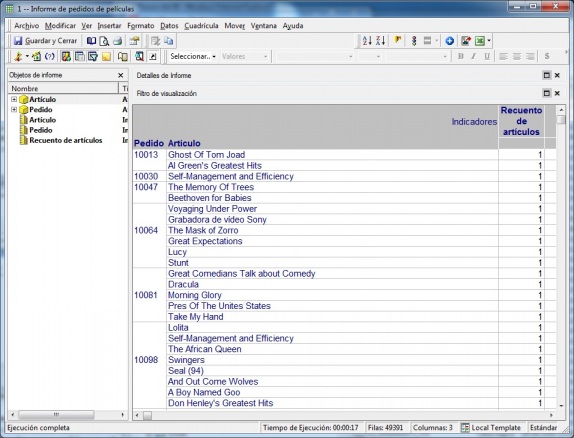

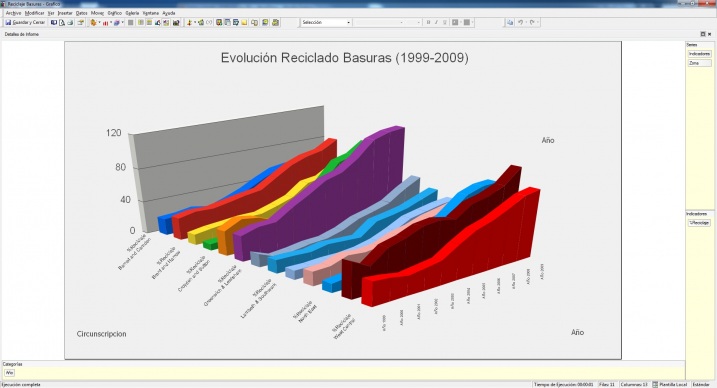

•Consultas e informes simples (Querys y reports): mediante consultas sobre la base de datos o con herramientas de generación de informes, podemos obtener información simple en multiples formatos. Serían las herramientas que nos permiten que el usuario se construya sus propios reportes. Es el nivel mas simple de solución dentro del BI. Por ejemplo, un informe típico podrían ser las ventas por familia, por zona geográfica, el número de empleados y coste salarial por delegación, etc. Estaría destinado a usuarios con una aptitud técnica limitada y orientado a analizar de una forma sencilla tipo foto la información histórica. Los generadores de informes son cada vez mas avanzados, permitiendonos definir multiples formatos de presentación, definición de filtros, exportación de los datos obtenidos a multiples formatos (excel, pdf, etc), plantillas, campos calculados, totalización, agrupación, etc. Nos permitirian contestar a la pregunta “¿que sucedio?”.

•Cubos OLAP (On-Line Analytic Processing). Exploración, tablas dinámicas, etc. El siguiente paso es pasar de la visión estática de los datos a una visión dinámica, donde podemos ir “navegando” por los datos, bajando en el nivel de detalle, cambiando la dimensión por la cual analizamos la información. El tipico ejemplo sería una tabla con los datos de ventas y margenes por delegación de una empresa, y cuando observamos un indicador de rentabilidad negativa, buceamos en los datos de esta delegación hasta dar con el producto que se esta vendiendo a precios de coste con margen negativo. Este sería el tipico ejemplo de los Cubos Olap y los visores multidimensionales que nos permiten “profundizar en los datos”. Nos permitirían contestar a la pregunta: ¿que sucedio y por que?.

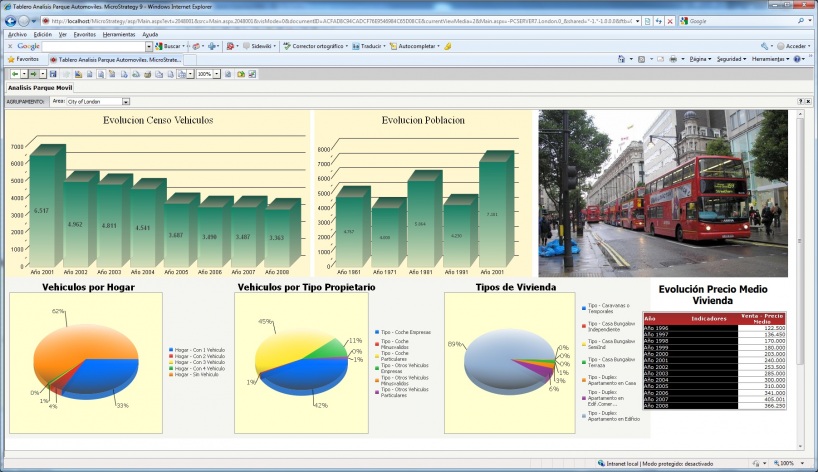

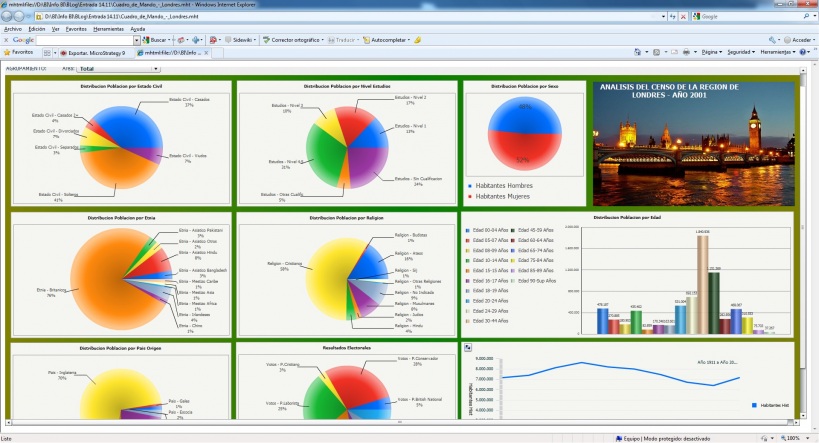

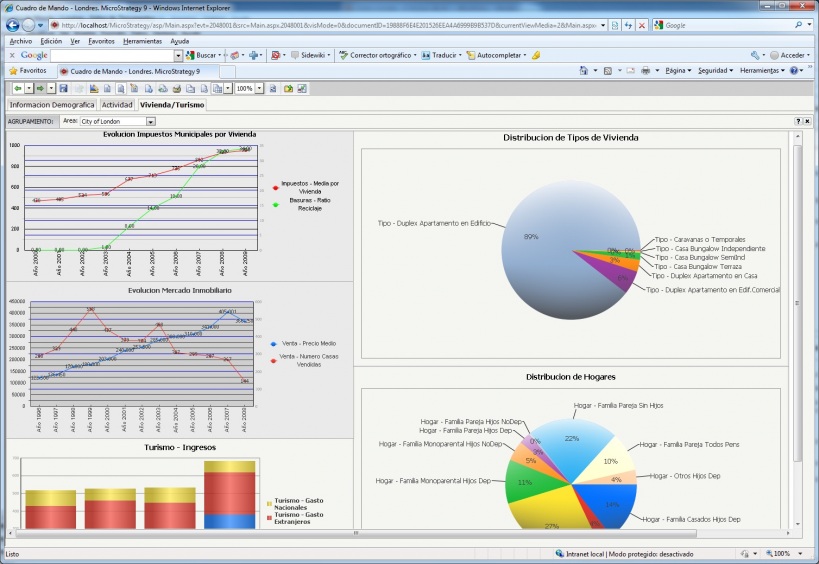

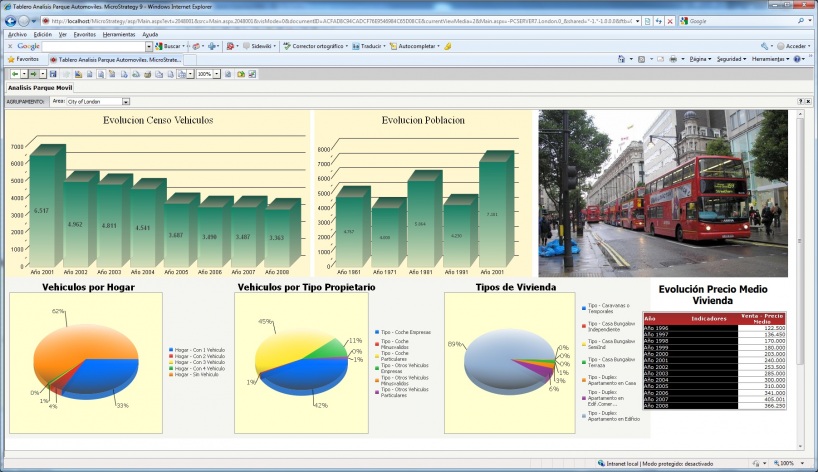

•EIS (Executive information system): Soluciones que permiten visualizar, de una forma rápida y fácil, el estado de una determinada situación empresarial, presente o pasada, y que permite detectar anomalías o oportunidades. Aplicaciones de alto nivel que pretenden, mediante el acceso a las diferentes bases de datos de una empresa, ofrecer a sus directivos los elementos clave para que puedan tomar decisiones sobre la marcha de sus negocios. Generalmente el directivo accede a pantallas gráficas o cuadros de mando en las que se resumen los elementos más importantes que debe tener en cuenta para la toma de decisiones. Podrían contestar a la pregunta: ¿que necesito conocer ahora?.

•DSS: Aplicación informática que basándose en modelos matemáticos y mediante análisis de sensibilidad permite ayudar a la toma de decisiones.

•Data Mining o minería de datos: Pueden considerarse sistemas expertos que nos permiten “interrogar a los datos” para obtener información. Consiste en la extracción no trivial de información que reside de manera implícita en los datos. Dicha información era previamente desconocida y podrá resultar útil para algún proceso. En otras palabras, la minería de datos prepara, sondea y explora los datos para sacar la información oculta en ellos. Las bases de la minería de datos se encuentran en la inteligencia artificial y en el análisis estadístico. Mediante los modelos extraídos utilizando técnicas de minería de datos se aborda la solución a problemas de predicción, clasificación y segmentación. Un ejemplo podría ser una entidad bancaria que buceando en los datos de sus clientes puede determinar nuevos segmentos de mercado a los que ofrecer determinados productos o el tipico supermercado que analizando las ventas en una franja horaria determinada, es capaz de realizar promociones de determinados productos que se venden mas en determinadas horas (el tipico ejemplo de las ventas de pañales y cerveza). Contestarian a las preguntas: ¿que es interesante?, ¿que podría pasar?.

•KMS: nuevas tecnologicas para la gestión del conocimiento y su integración en una única plataforma. Son herramienta no relacionadas directamente con el Business Intelligence, pero nos permiten gestionar toda la información y el conocimiento que hay en la empresa para poder sacar un mayor partido de ella. Por ejemplo, toda la documentación interna, manuales, procedimientos que existe en la empresa esta guardada en un gestor documental que una vez indexado, se puede consultar por los integrantes de la organización de una forma ágil. Al fin y al cabo, la información es poder y cuanto mas rapida se pueda obtener, mas beneficios genera.

Las soluciones de Bussiness Intelligence varían según las necesidades de los usuarios, sus perfiles, su necesidad de información, etcetera. Estos elementos serán los que determinen el tipo de herramienta a elegir, aunque muchas veces podremos utilizar combinaciones de ellas para cubrir nuestras necesidades.

Vamos a profundizar en cada una de las soluciones de Business Intelligence, con aspectos más especificos, presentado ejemplos de cada una de las soluciones y enumerando las mas importantes que encontramos en el mercado (tanto a nivel propietario como de Open Source).

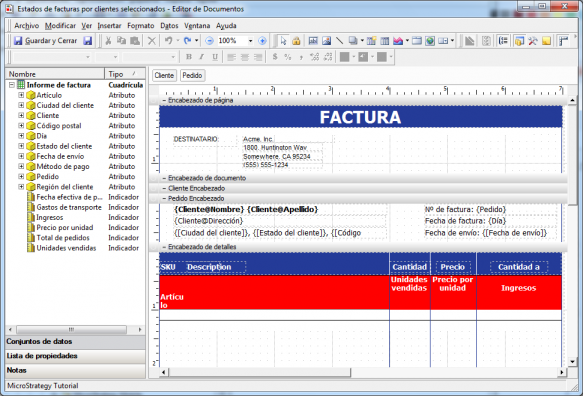

Consultas e informes simples (Querys y reports)

Consultas e informes simples (Querys y reports) respinosamilla 25 Febrero, 2010 - 21:00Serian todas aquellas herramientas que nos van a permitir realizar consultas o informes (querys o reports) para obtener información sobre los datos.

Este tipo de herramientas las podemos utilizar en dos ambitos:

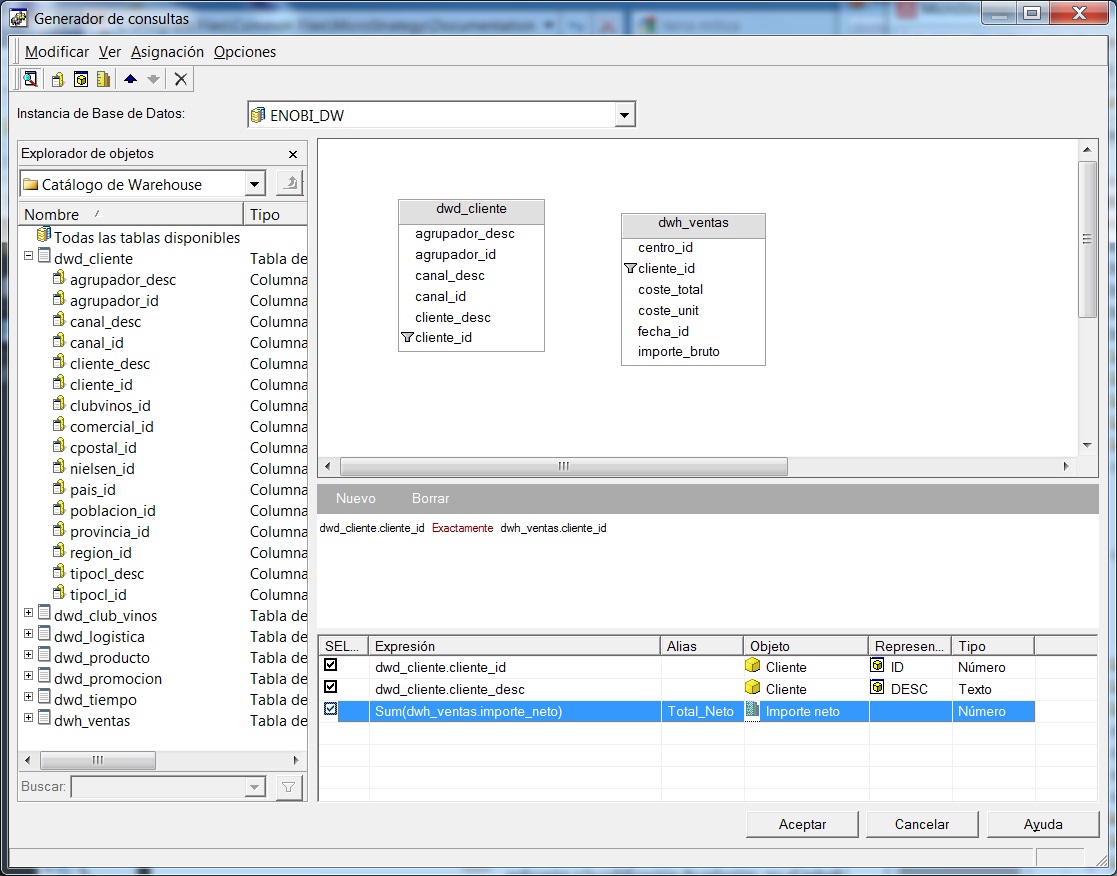

-Entorno transaccional: desde las herramientas de informes o querys, atacamos directamente a la base de datos donde se registran las transacciones cotidianas de la empresa. En este entorno, las consultas son mucho mas complejas, los tiempos de respuesta son mayores y seguramente estaremos interfiriendo con otros procesos informaticos que comparten la plataforma (imaginemos el ejemplo de una lectura historica de datos años atras, en el mismo servidor donde se esta realizando la facturación de clientes).

-Entorno del Data warehouse: atacamos directamente a la base de datos que esta optimizada para el análisis. Utilizamos una estructura y tecnología muchos mas apropiada y obtenemos mejores resultados, velocidad, etc.

Por ejemplo, un informe típico podrían ser las ventas por familia, por zona geográfica, el número de empleados y coste salarial por delegación, etc. Estaría destinado a usuarios con una aptitud técnica limitada y orientado a analizar de una forma sencilla tipo foto la información histórica.

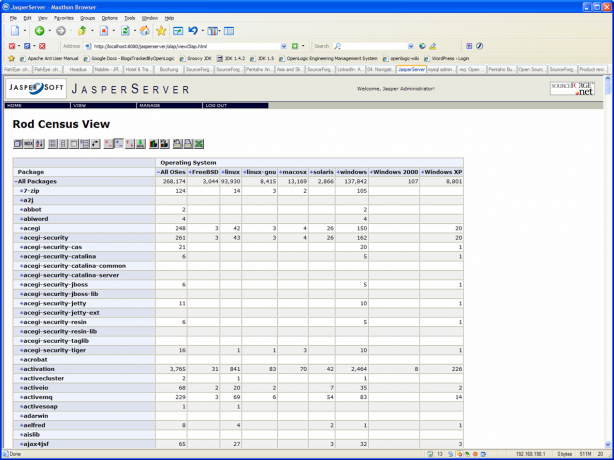

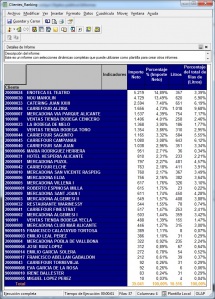

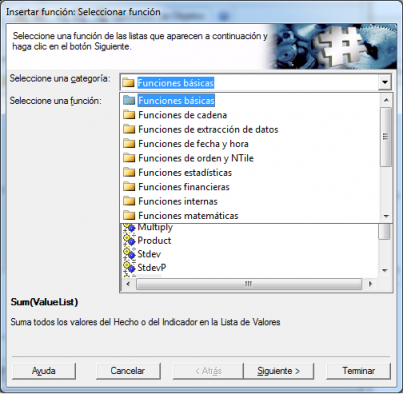

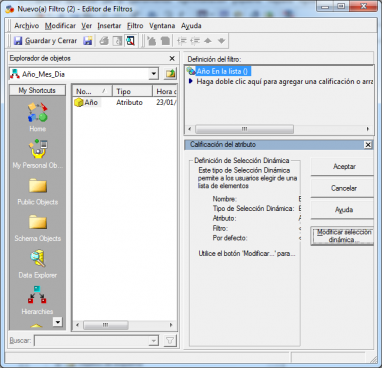

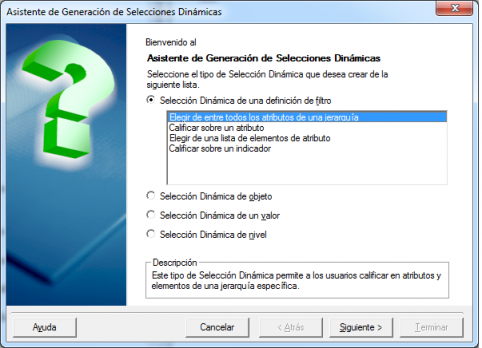

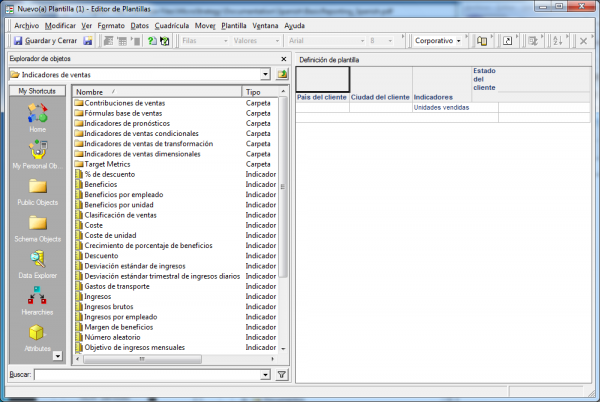

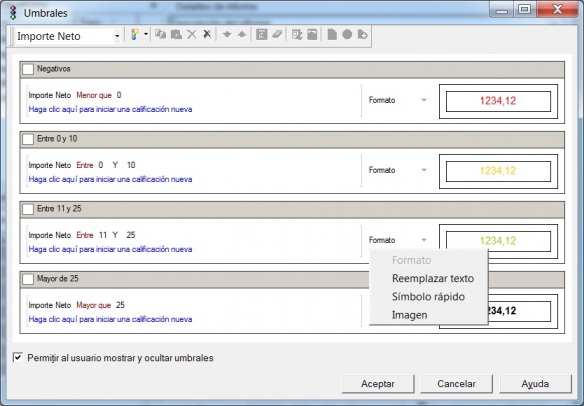

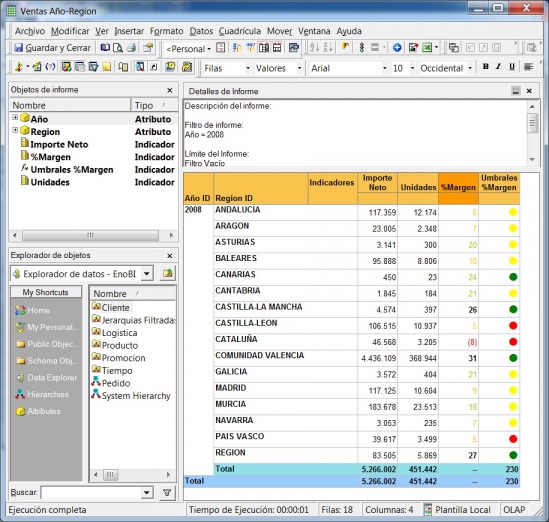

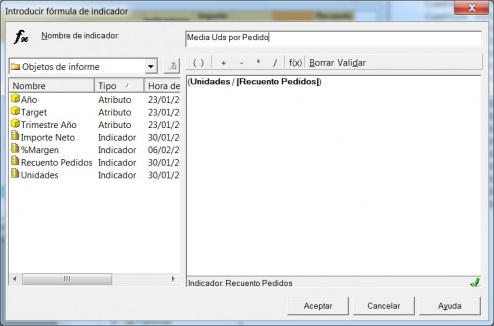

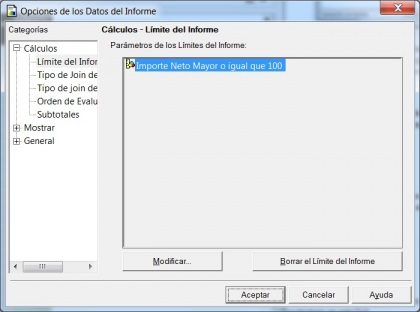

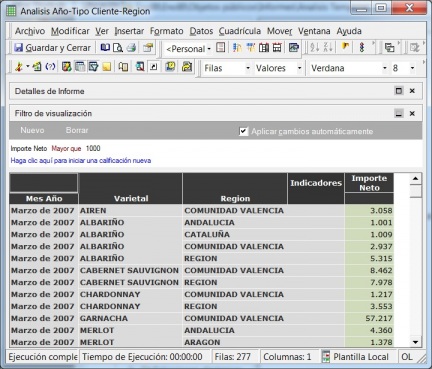

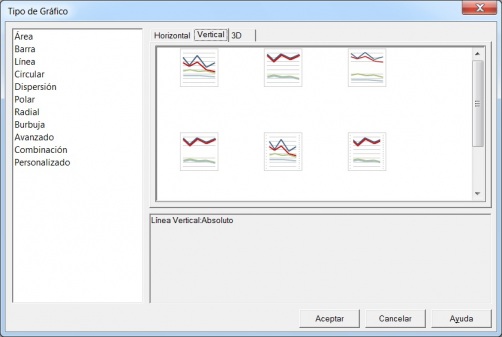

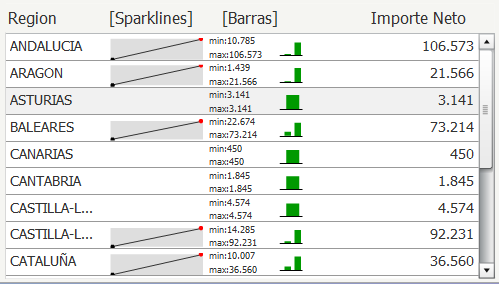

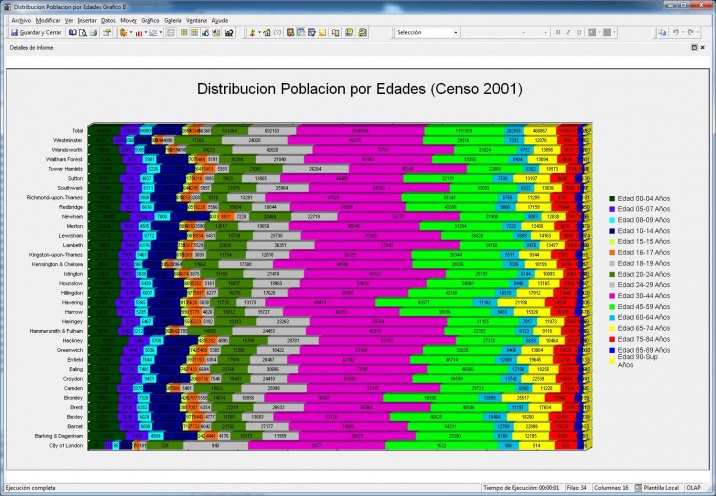

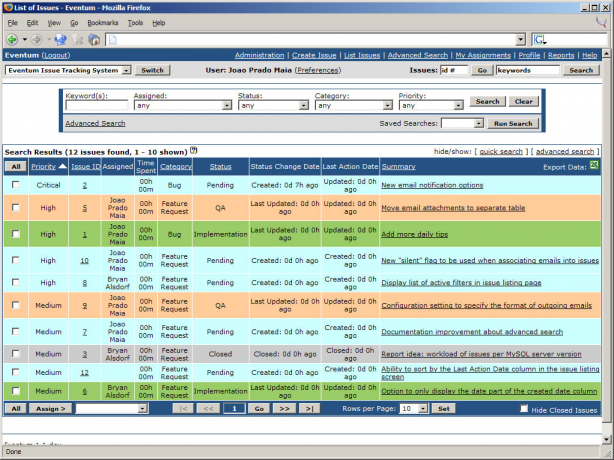

Las herramientas de informes y querys son cada vez mas avanzadas, permitiendonos definir multiples formatos de presentación, definición de filtros, exportación de los datos obtenidos a multiples formatos (excel, pdf, etc), plantillas, campos calculados, totalización, agrupación, etc. Igualmente, dispondremos de diferentes tipos de gráficos que nos permitiran ver la información de diferentes modos (charts, semaforos, graficos de barras, de tarta,etc, etc). Nos permitirian contestar a la pregunta “¿que sucedio?”.

De cara a la utilización de este tipo de herramientas, podemos definir varios niveles de utilización según la experiencia y formación del usuario, que podrían ser:

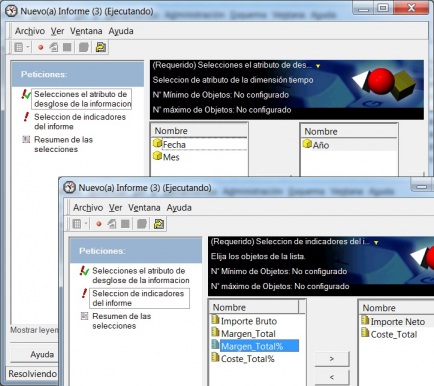

•Los usuarios poco expertos podrán solicitar la ejecución de informes

o querys predefinidas según unos parámetros predeterminados (preparamos un repositorio de informes ya diseñados, y el usuario simplemente indicara los criterios de selección al ejecutarlos).

•Los usuarios con cierta experiencia podrán generar querys flexibles mediante una aplicación que proporcione una interfaz gráfica de ayuda.

•Los usuarios altamente experimentados podrán escribir, total o parcialmente, la consulta en un lenguaje de interrogación de datos.

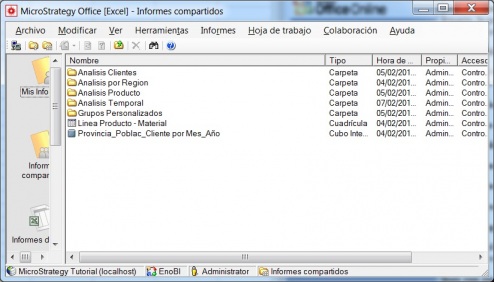

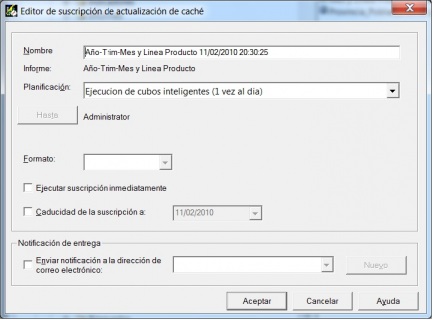

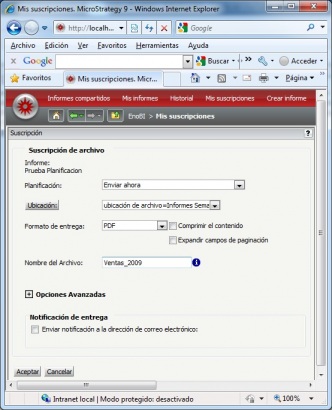

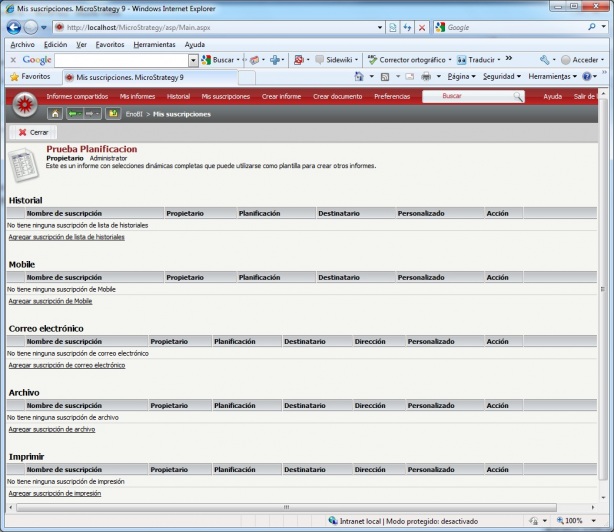

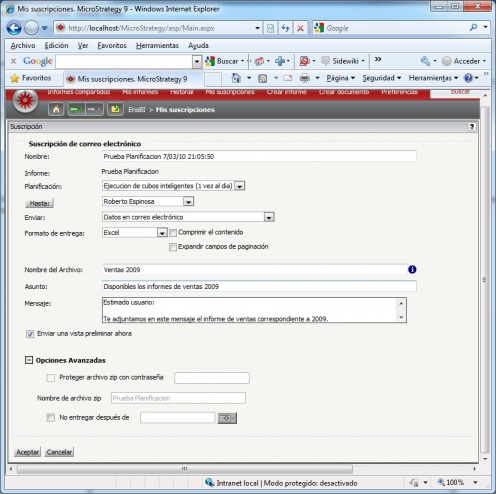

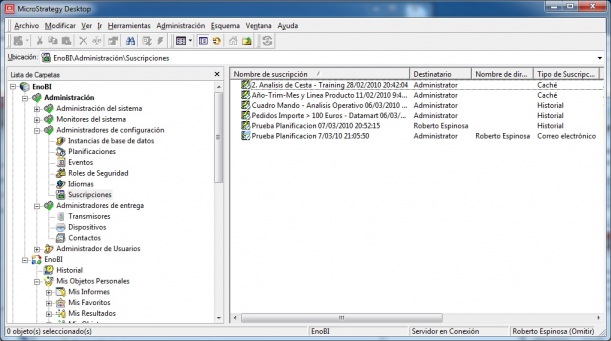

Las herramientas igualmente nos pueden ofrecer funcionalidades adicionales para la distribución de los informes realizados en el ambito de la organización, scheduling para la realización de cálculos, utilización de plantillas e informes predefinidos, repositorios de informes, filtros, etc.

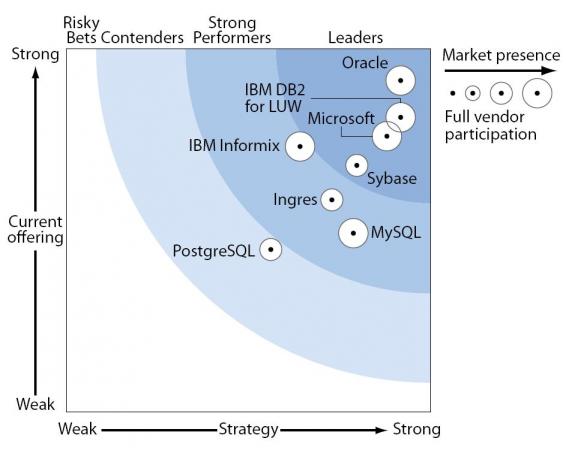

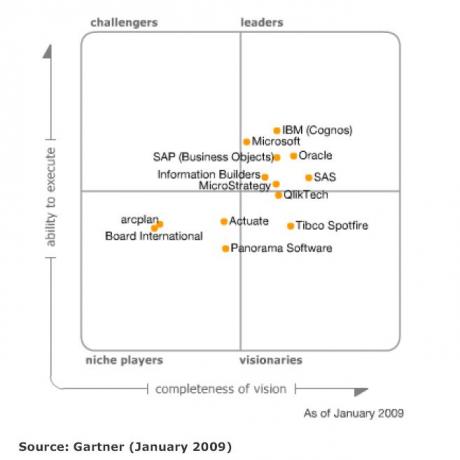

Algunas herramientas para reporting Propietarias son (aunque existen una multitud de herramientas y cada una de ellas podrá ser apropiada según nuestras necesidades):

1. Oracle BI Publisher

2. Microsoft Reporting Services

3. BusinessObjects Crystal Reports (SAP)

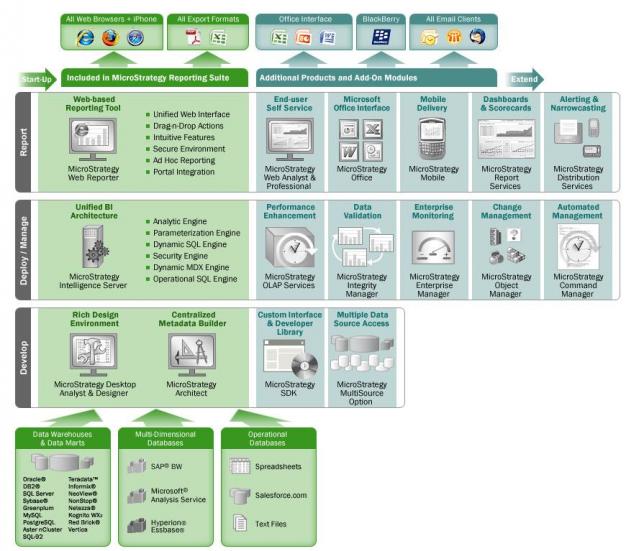

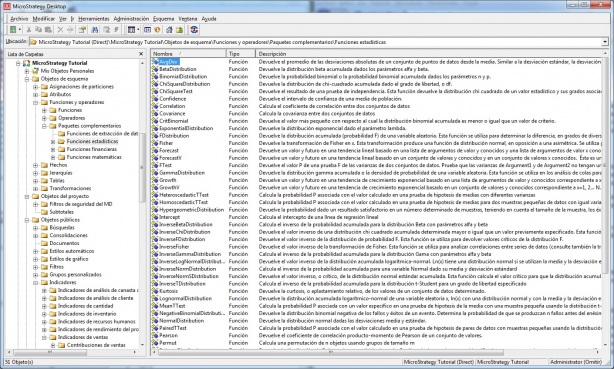

4. Microstrategy

5. Information Builders

6. IBM Cognos

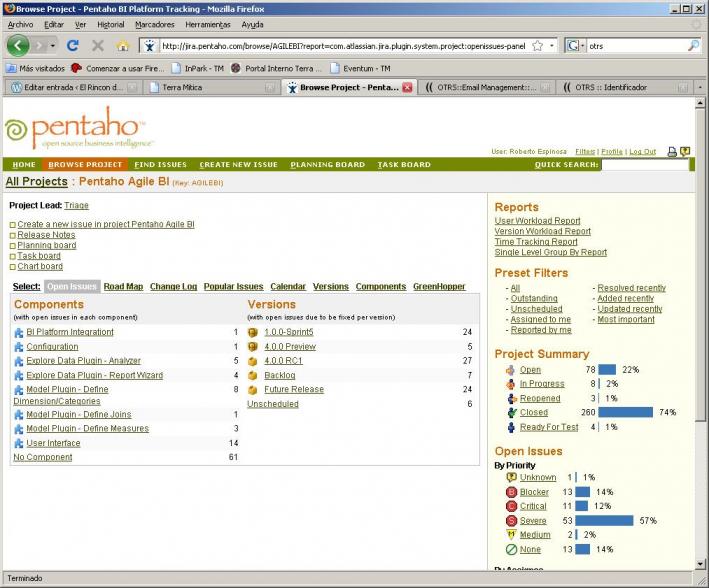

Algunas herramientas para reporting de Opensource ( gracias a Todobi.com):

1. BIRT Project (Actuate)

2. Pentaho

3. OpenRPT

4. OpenReports

5. FreeReportBuilder

6. Magallanes

7. ART – A lightweight reporting solution

8. DataVision

9. The Wabit – Open Source Reporting Tool

10. Rilb

11. JavaEye Reporting Tool – JERT

12. iReport

Cubos OLAP (On-Line Analytic Processing)

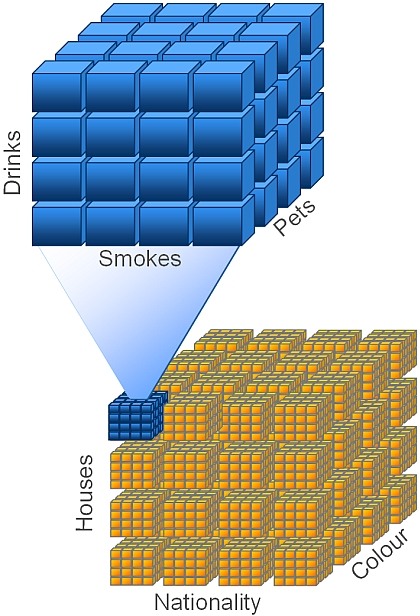

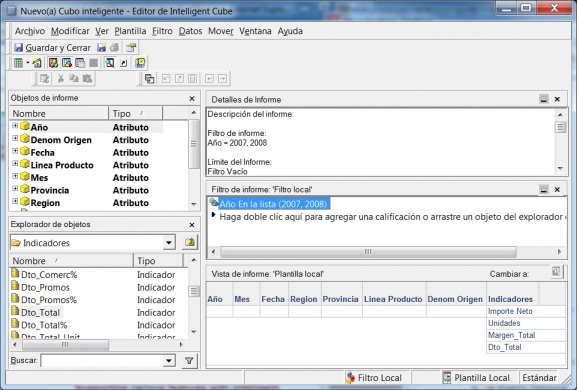

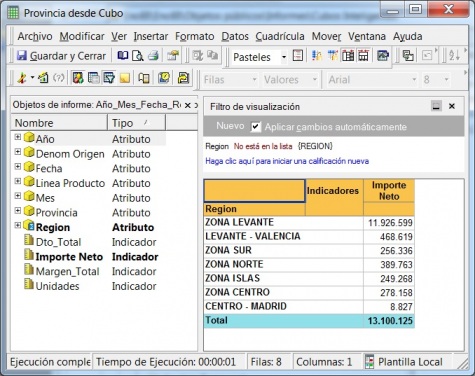

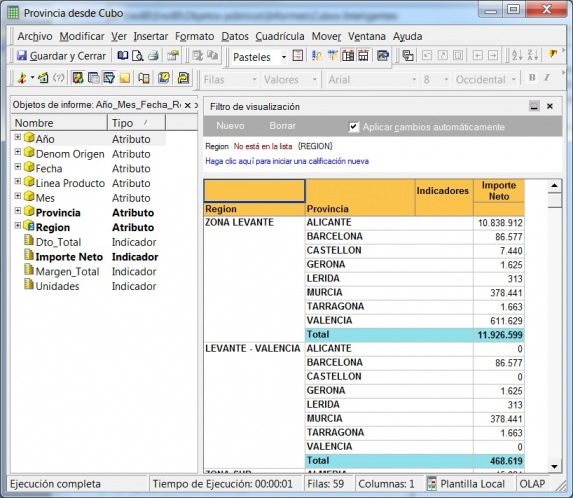

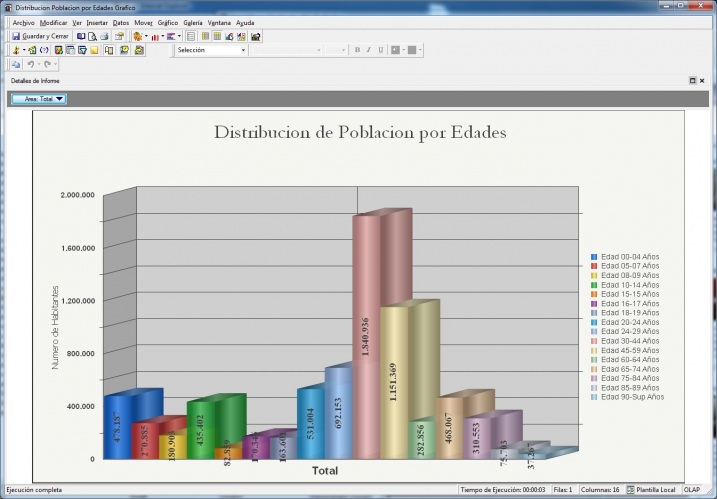

Cubos OLAP (On-Line Analytic Processing) respinosamilla 25 Febrero, 2010 - 09:50Cubos OLAP (On-Line Analytic Processing): Son las herramientas que se basan en la capacidad de analizar y explorar por los datos. Nos permiten cambiar el enfoque del “¿que esta pasando?” que podemos obtener a través de las herramientas de reporting al “¿por que esta pasando?”.

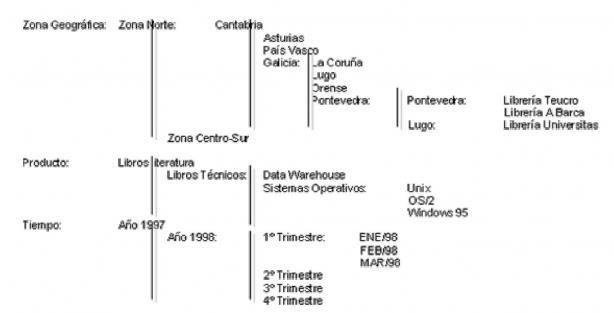

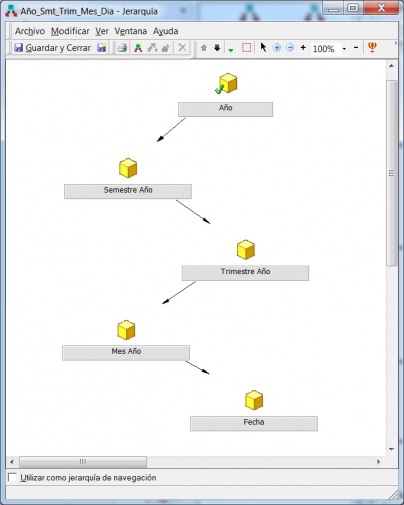

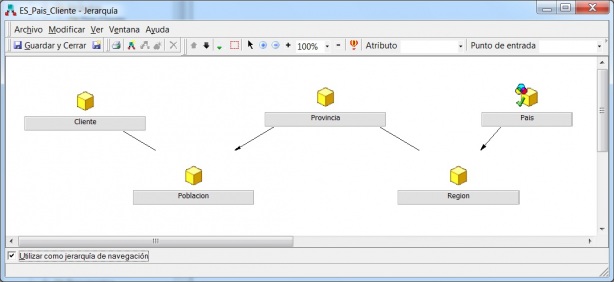

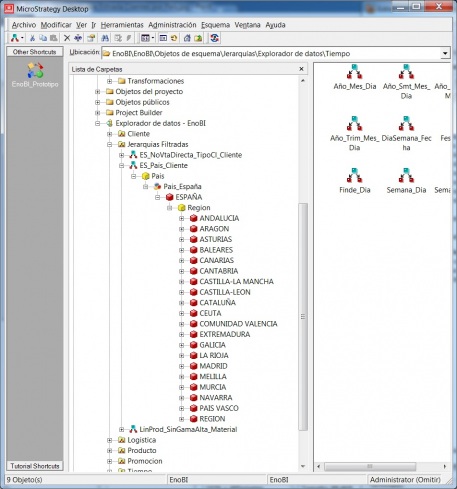

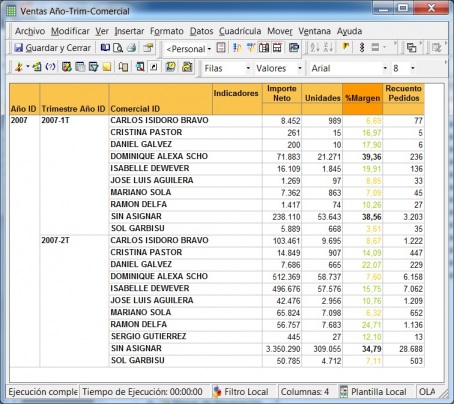

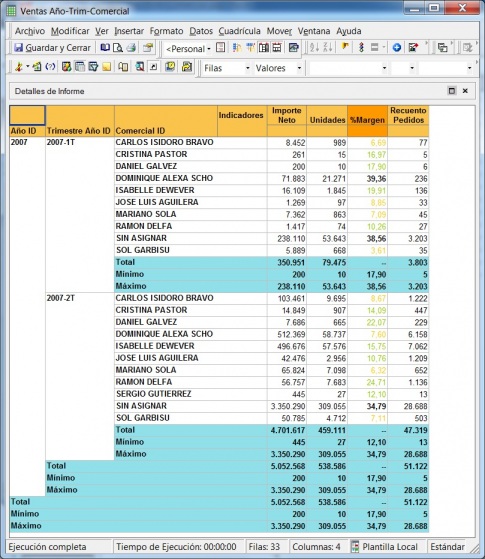

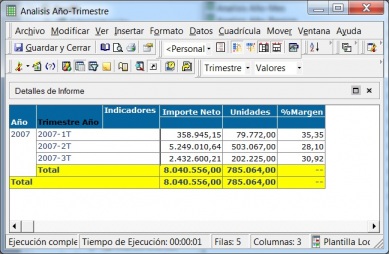

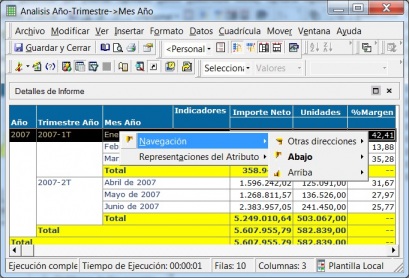

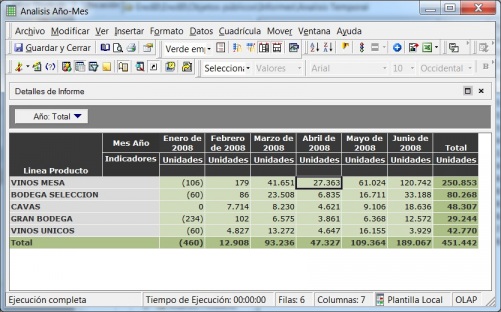

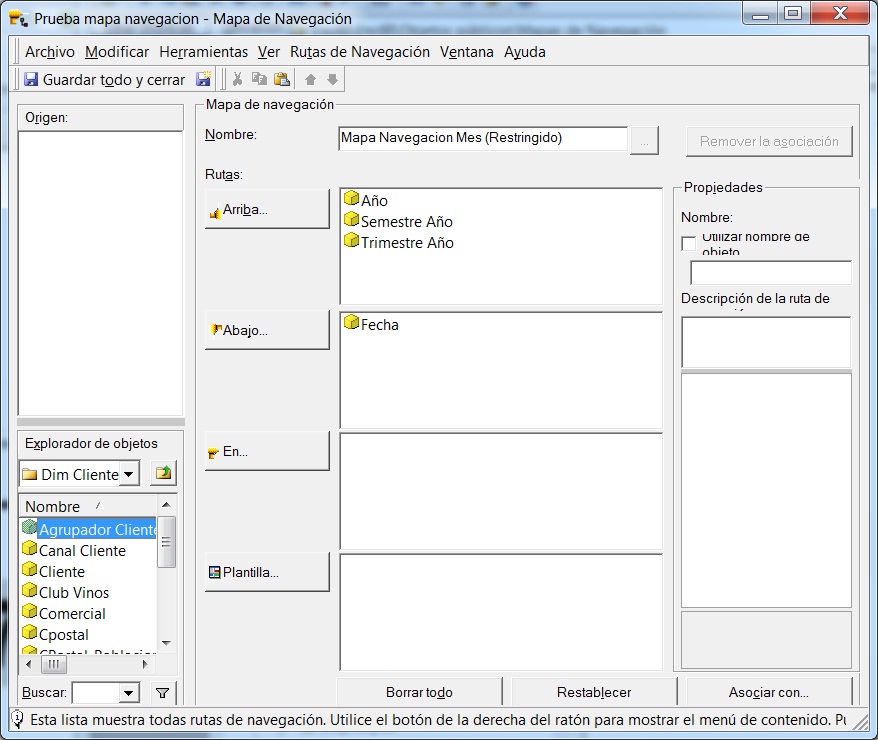

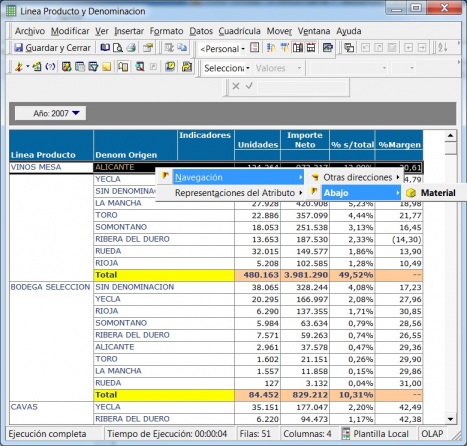

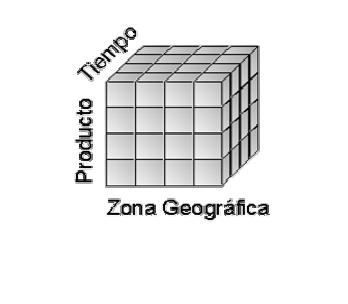

Para descubrir el “por que”, los usuarios pueden navegar y profundizar en los datos para analizar los detalles o patrones.Las herramientas OLAP nos proporcionan analisis interactivo por las diferentes dimensiones de los datos (por ejemplo, tiempo, producto, cliente, criterios geográficos, etc) y por los diferentes niveles de detalle (para la dimensión tiempo, habrá nivel de detalle año, trimestre, mes, dia).

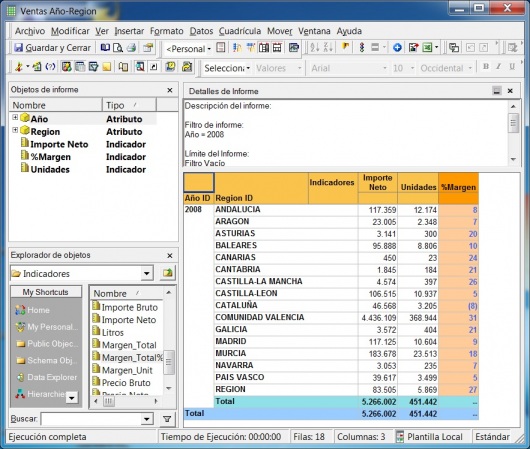

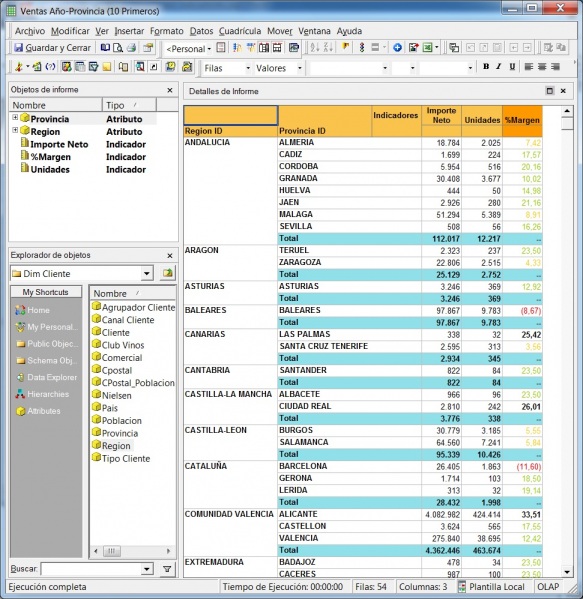

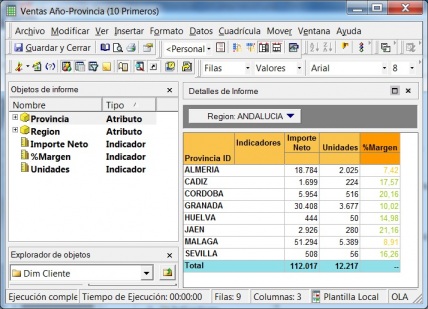

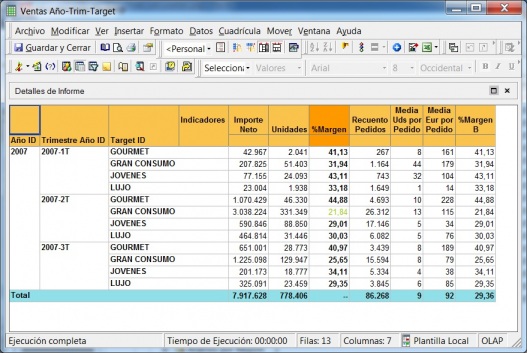

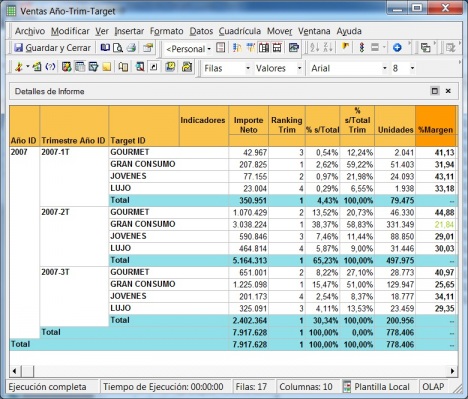

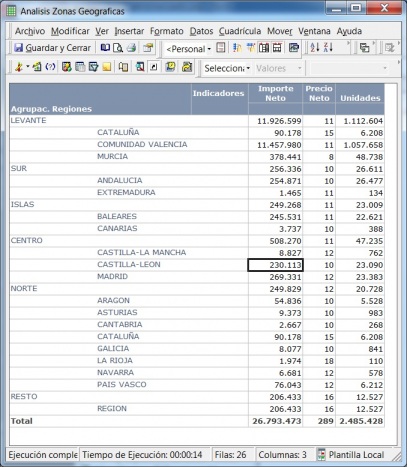

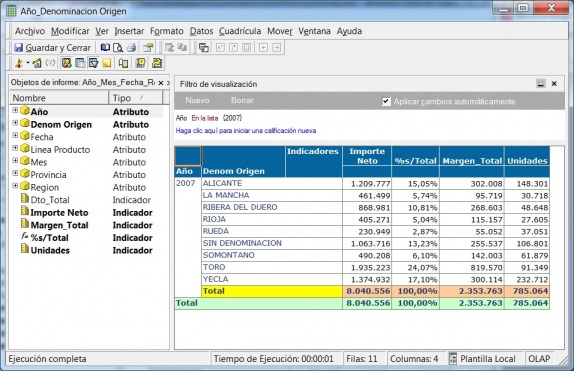

Esto significaría pasar de la visión estática de los datos a una visión dinámica, donde podemos ir “navegando” por los datos, bajando en el nivel de detalle, cambiando la dimensión por la cual analizamos la información. El tipico ejemplo sería una tabla con los datos de ventas y margenes por delegación de una empresa, y cuando observamos un indicador de rentabilidad negativa, buceamos en los datos de esta delegación hasta dar con el producto que se esta vendiendo a precios de coste con margen negativo. Este sería el tipico ejemplo de los Cubos Olap y los visores multidimensionales que nos permiten “profundizar en los datos”. Nos permitirían contestar a la pregunta: ¿que sucedio y por que?.

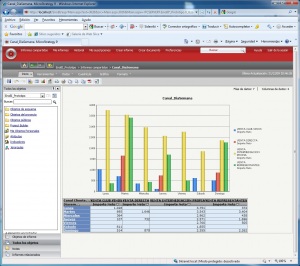

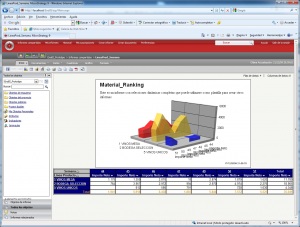

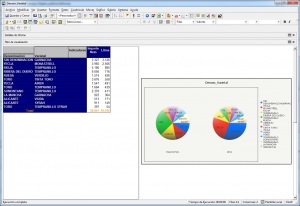

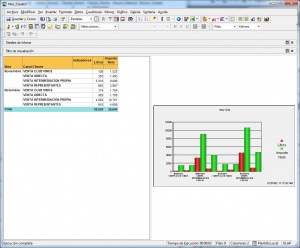

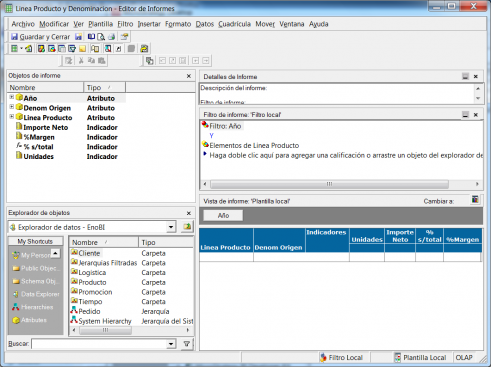

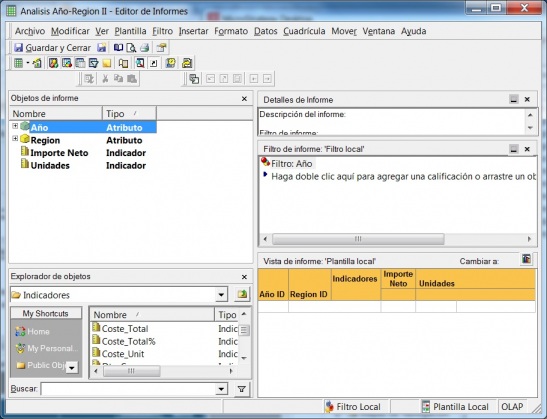

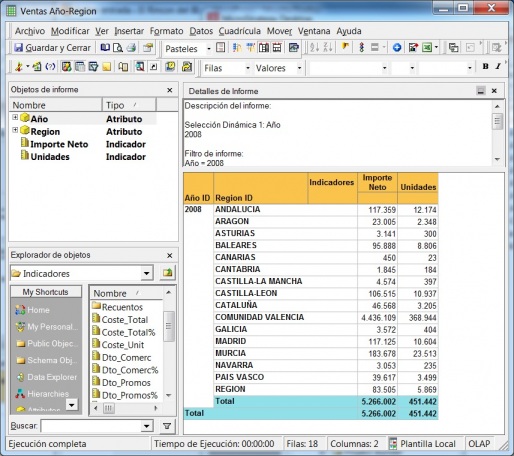

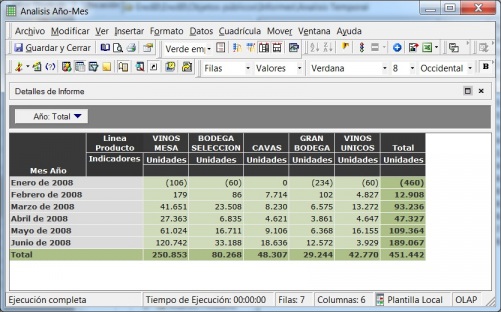

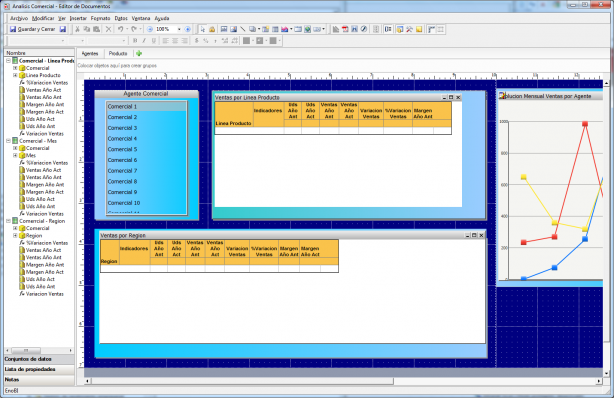

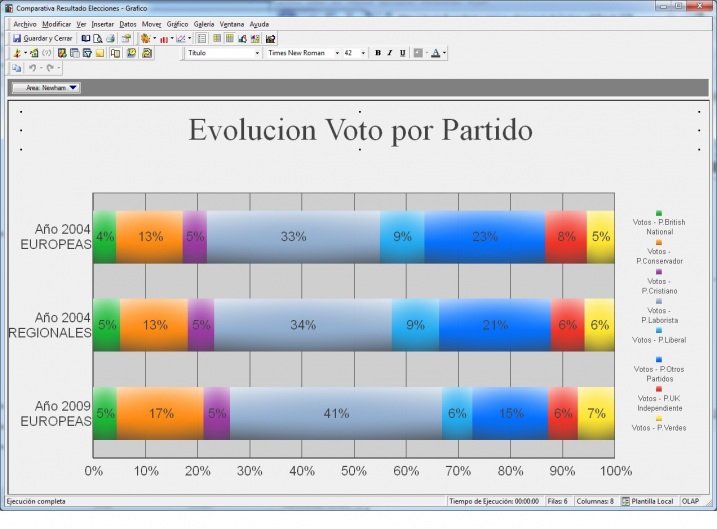

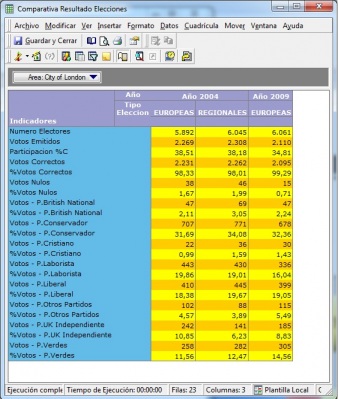

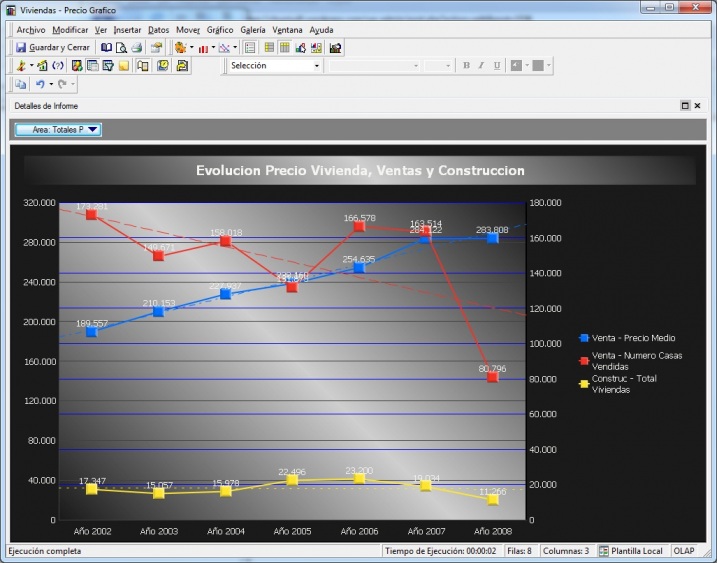

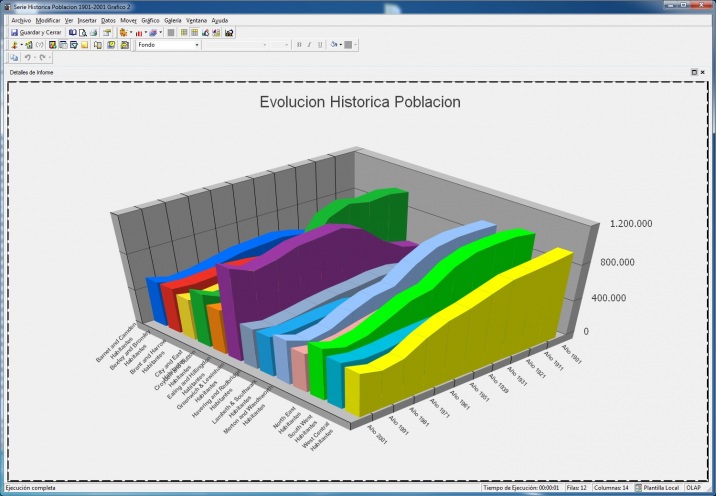

Ejemplo de Visor Olap (Palo Web Client)

Para entender qué se analiza mediante los cubos Olap, hemos de saber que la información de gestión se compone de conceptos de información (dimensiones) y coeficientes de gestión (indicadores), que los cuadros directivos de la empresa pueden consultar según las dimensiones de negocio que se definan.Dichas dimensiones de negocio se estructuran a su vez en distintos niveles de detalle (por ejemplo, la dimensión geográfica puede constar de los niveles nacional, provincial, ayuntamientos y sección censal).

Este tipo de sistemas ha existido desde hace tiempo, en el mundo de la informática bajo distintas denominaciones: cuadros de mando, MIS, EIS, etc.

En general, los sistemas OLAP deben:

- Soportar requerimientos complejos de análisis.

- Analizar datos desde diferentes perspectivas.

- Soportar análisis complejos contra un volumen ingente de datos.

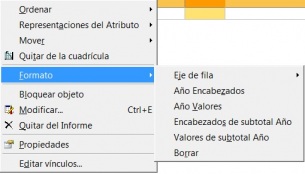

La funcionalidad de los sistemas OLAP se caracteriza por ser un análisis multidimensional de datos corporativos, que soportan los análisis del usuario y unas posibilidades de navegación, seleccionando la información a obtener. Normalmente este tipo de selecciones se ve reflejada en la visualización de la estructura multidimensional, en unos campos de selección que nos permitan elegir el nivel de agregación (jerarquía) de la dimensión, y/o la elección de un dato en concreto, la visualización de los atributos del sujeto, frente a una(s) dimensiones en modo tabla, pudiendo con ello realizar, entre otras las siguientes acciones:

- Rotar (Swap): alterar las filas por columnas (permutar dos dimensiones de análisis)

- Bajar (Down): bajar el nivel de visualización en las filas a una jerarquía inferior.

- Detallar (Drilldown): informar para una fila en concreto, de datos a un nivel inferior.

- Expandir (Expand): id. anterior sin perder la información a nivel superior para éste y el resto de los valores.

- Colapsar (Collapse): operación inversa de la anterior.

Para ampliar el glosario de conceptos OLAP y de otros relacionados con el mundo BI, os recomiendo la visita a la página:

http://www.dssresources.com/glossary/olaptrms.html

Tal y como la tecnología y los usuarios han evolucionado y madurado, las distinciones entre OLAP y las herramientas de reporting se han vuelto considerablemente confusas. Podemos tener informes bien formateados o sumarizados basados en datos multidimensionales y el usuario querrá enseguida navegar y bucear en los datos para ver el problema con una metrica en particular. En este caso, el usuario no querra ser forzado a tener que pasar a una herramienta separada para analizar y explorar. Las siguientes características continuan distinguiendo las herramientas OLAP de las herramientas de query y reporting tools:

- En una herramienta Multidimensional los usuarios analizan los valores numericos de diferentes dimensiones (como producto, tiempo, geografia). En un informe, por otro lado, solo hay una dimensión de análisis.

- El cambio entre las diferentes dimensionales de analisis y los diferentes niveles de ellas es muy rápido en este tipo de herramientas. Si un usuario hace un doble click en la dimensión tiempo, en el nivel Año, rapidamente va a poder ver la información de un mes o de un día en concreto, sin tiempos de espera excesivos. En un informe, los tiempos de calculo pueden ser muy considerables (hasta llegar incluso al punto de tener que se programados en procesos batch su ejecución).

- La herramienta Olap es sumamente interactiva, permitiendonos pivotar sobre la información viendola desde diferentes perspectivas y cambiar dichas perspectivas de una forma muy rapida. Analizando las ventas por mes, podremos cambiar la visión de la información para verla por producto o por tipo de cliente. Ademas se pueden establecer filtrados interactivos y el desglose de la información se puede realizar para un subconjunto de la dimension en concreto. Este tipo de interacción con los datos es imposible con los informes (aunque posible en algunos productos).

Para distinguir los requerimientos OLAP, es importante distinguir entre las plataformas OLAP y los interfases de usuario OLAP.

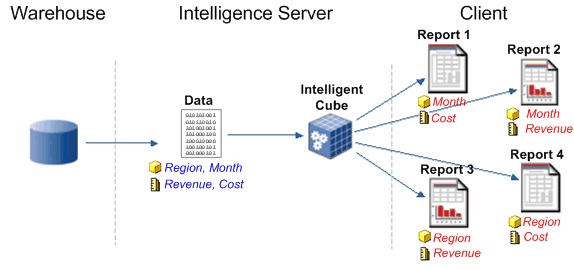

Plataformas OLAP

La plataforma OLAP es aquella en la que se almacenan los datos para permitir el análisis multidimensional. El cubo mostrado en la imagen superior representa una base de datos OLAP. En este contexto, los usuarios finales no tendrán que preocuparse como se almacena la información, si se replica, tiene cache o que tipo de arquitectura utiliza, pero todos estos aspectos si influiran en que tipo de herramienta front-end puede utilizar, que podrá analizar y como.

Hay cuatro tipos de arquitectura OLAP:

1.Relational OLAP (ROLAP): este tipo de plataforma almacena los datos en una base de datos relacional, lo que implica que no es necesario que los datos se repliquen en un almacenamiento separado para el análisis (veremos que en la mayoría de los casos es preferible esta diferenciación). Los calculos se realizan en una base de datos relacional, con grandes volumenes de datos y tiempos de navegación no predecibles. Parte de la premisa que las capacidades Olap se desarrollan mejor contra este tipo de bases de datos.

El sistema ROLAP utiliza una arquitectura de tres niveles. La base de datos relacional maneja los requerimientos de almacenamiento de datos, y el motor ROLAP proporciona la funcionalidad analítica.

- El nivel de base de datos usa bases de datos relacionales para el manejo, acceso y obtención del dato.

- El nivel de aplicación es el motor que ejecuta las consultas multidimensionales de los usuarios.

- El motor ROLAP se integra con niveles de presentación, a través de los cuales los usuarios realizan los análisis OLAP.

Los usuarios finales ejecutan sus análisis multidimensionales, a través del motor ROLAP, que transforma dinámicamente sus consultas a consultas SQL. Se ejecutan estas consultas SQL en las bases de datos relacionales, y sus resultados se relacionan mediante tablas cruzadas y conjuntos multidimensionales para devolver los resultados a los usuarios.

La arquitectura ROLAP es capaz de usar datos precalculados si estos están disponibles, o de generar dinámicamente los resultados desde los datos elementales si es preciso. Esta arquitectura accede directamente a los datos del Data Warehouse, y soporta técnicas de optimización de accesos para acelerar las consultas. Estas optimizaciones son, entre otras, particionado de los datos a nivel de aplicación, soporte a la desnormalización y joins múltiples.

Algunos fabricantes son: Oracle’s BI EE, SAP Netweaver BI, MicroStrategy, Cognos 8, BusinessObjects Web Intelligence.

2. Multidimensional OLAP (MOLAP):los datos son replicados en plataformas con un almacenamiento construido a proposito que asegura mayor velocidad en los análisis. Los calculos se llevan a cabo en un servidor con una base de datos multidimensional, partiendo de la premisa que un sistema OLAP estara mejor implantado almacenando los datos multidimensionalmente.

El sistema MOLAP utiliza una arquitectura de dos niveles: La bases de datos multidimensionales y el motor analítico.

- La base de datos multidimensional es la encargada del manejo, acceso y obtención del dato.

- El nivel de aplicación es el responsable de la ejecución de los requerimientos OLAP. El nivel de presentación se integra con el de aplicación y proporciona un interfaz a través del cual los usuarios finales visualizan los análisis OLAP. Una arquitectura cliente/servidor permite a varios usuarios acceder a la misma base de datos multidimensional.

La información procedente de los sistemas operacionales, se carga en el sistema MOLAP, mediante una serie de rutinas batch. Una vez cargado el dato elemental en la Base de Datos multidimensional (MDDB), se realizan una serie de cálculos en batch, para calcular los datos agregados, a través de las dimensiones de negocio, rellenando la estructura MDDB. Tras rellenar esta estructura, se generan unos índices y algoritmos de tablas hash para mejorar los tiempos de accesos a las consultas.

Una vez que el proceso de compilación se ha acabado, la MDDB está lista para su uso. Los usuarios solicitan informes a través del interface, y la lógica de aplicación de la MDDB obtiene el dato. La arquitectura MOLAP requiere unos cálculos intensivos de compilación. Lee de datos precompilados, y tiene capacidades limitadas de crear agregaciones dinámicamente o de hallar ratios que no se hayan precalculados y almacenados previamente.

Algunos fabricantes son: Oracle’s Hyperion Essbase, Microsoft Analysis Services, TM1, SAS OLAP, Cognos PowerCubes.

3. Hybrid OLAP (HOLAP): plataformas que usan una combinación de varias técnicas de almacenamiento.Las agregaciones se realizan en cache, pero el drill-down a traves de la base de datos relacional. Algunos fabricantes son: Microsoft Analysis Services, SAS OLAP, Oracle’s Hyperion Essbase.

4. Dynamic OLAP (DOLAP): generan una pequeña cache multidimensional cuando los usuarios ejecutan las consultas contra la base de datos. Algunos fabricantes son: BusinessObjects Web Intelligence, Oracle’s Hyperion Interactive Reporting(formerly Brio).

ROLAP vs. MOLAP (Comparativa)

Cuando se comparan las dos arquitecturas, se pueden realizar las siguientes observaciones:

El ROLAP delega la negociación entre tiempo de respuesta y el proceso batch al diseño del sistema. Mientras, el MOLAP, suele requerir que sus bases de datos se precompilen para conseguir un rendimiento aceptable en las consultas, incrementando, por tanto los requerimientos batch.

- Los sistemas con alta volatilidad de los datos (aquellos en los que cambian las reglas de agregación y consolidación), requieren una arquitectura que pueda realizar esta consolidación ad-hoc. Los sistemas ROLAP soportan bien esta consolidación dinámica, mientras que los MOLAP están más orientados hacia consolidaciones batch.

- Los ROLAP pueden crecer hasta un gran número de dimensiones, mientras que los MOLAP generalmente son adecuados para diez o menos dimensiones.

- Los ROLAP soportan análisis OLAP contra grandes volúmenes de datos elementales, mientras que los MOLAP se comportan razonablemente en volúmenes más reducidos (menos de 5 Gb).

- Por ello, y resumiendo, el ROLAP es una arquitectura flexible y general, que crece para dar soporte a amplios requerimientos OLAP. El MOLAP es una solución particular, adecuada para soluciones departamentales con unos volúmenes de información y número de dimensiones más modestos.

Visores OLAP

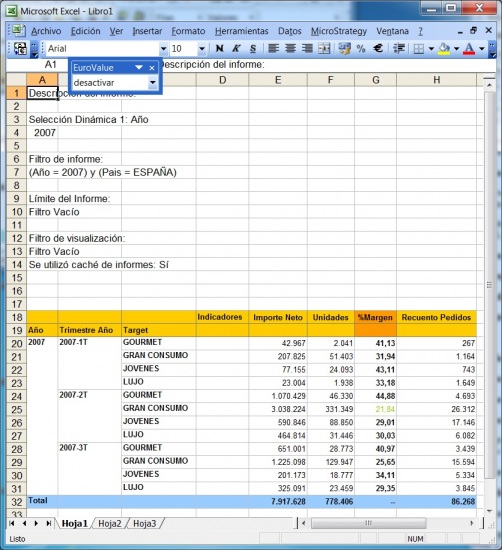

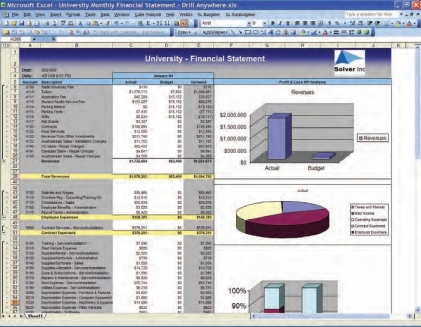

Los visores Olap son las herramientas que nos permiten “atacar” a la base de datos OLAP para sacar todo el partido a los datos con las consideraciones que hemos indicado. Una de las herramientas mas utilizada para visualizar el cubo es Microsoft Excel. De hecho, tres de los productos Olap lideres la utilizaron inicialmente como unico interfaz (Oracle’s Hyperion Essbase, Microsoft Analysis Services, SAP Business Explorer). Con Excel, los usuarios abren su hoja e inmediatamente pueden hacen drill en las celdas y en las Excel Pivot Tables para recuperar y explorar sus datos.

Ejemplo de Excel comoVisor Olap

Hoy en dia, Excel continua siendo una importante interfaz OLAP, pero ademas, los usuarios pueden explorar los datos a traves de los visores OLAP. Hay visores basados en Web, que ademas tienen capacidades de navegacion y charting avanzadas. Tambien pueden disponer de herramientas de query y de generación de informes.

Expresiones Multidimensionales (MDX): en un lenguaje query similar al SQL que nos permite realizar consultas sobre una base de datos OLAP. Microsoft desarrollo este lenguaje para trabajar con su servidor OLAP, y al ganar el MDX aceptación entre la industria, un gran numero de fabricantes la incorporaron a sus bases de datos, de forma que hoy muchos visores OLAP generan MDX para acceder y analizar los datos de diferentes bases de datos OLAP.

Igual que las herramientas de query y reporting permiten a los usuarios recuperar información de las bases de datos relaciones sin conocer el lenguaje SQL, los visores OLAP nos permiten acceder a los datos de un BD Olap sin necesidad de conocer las expresiones multidimiensionales del lenguaje MDX.

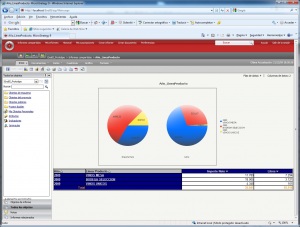

Ejemplo de Visor Olap (Jpivot)

Una relación de visores OLAP Open Source la podemos encontrar en la web de todobi.com.

Hola a todos los lectores de

Hola a todos los lectores de este comentario, en realidad soy nuevo en este tema de las bases de datos y los cubos de datos; pero me han resultado muy interesantes estos temas, la forma de trabajar la información y lo excelentes resultados que se pueden llegar a tener. actualmente estoy cursando una materia en la universidad, en la cual estamos aprendiendo un poco de lo que son las bases de datos trabajando con SQL SERVER 2012, y además de eso nos han pedido que investiguemos sobre PENTAHO y su aplicación con MYSQL, ya que debemos realizar un trabajo hasta lograr crear los cubos de datos.

Sera posible que alguien pudiera proporcionarme algún manual de la instalación de PENTAHO y como se trabaja en combinación con MYSQL. Se los agradeceré muchísimo.

Soy un estudiante de la Universidad Tecnologica de El Salvador, de la carrera Licenciatura en Informatica.

Es un gustazo formar parte de esta pagina tan interesante.

saludos a todos.

- Inicie sesión para enviar comentarios

Puedes encontrar una guía muy

Puedes encontrar una guía muy completa para arrancar Pentaho BI Server con diferentes bases de datos en el blog Analyse this. Tienes hasta cómo hacerlo con SQL Server, por si quieres probar.

En el Wiki de Pentaho Community también puedes encontrar bastante información.

Saludos,

- Inicie sesión para enviar comentarios

Hola a todos tengo un archivo

- Inicie sesión para enviar comentarios

EIS (Executive information system). Cuadros de Mando Integral. DSS (Decission Support System)

EIS (Executive information system). Cuadros de Mando Integral. DSS (Decission Support System) respinosamilla 25 Febrero, 2010 - 10:00Sistema de Información para Ejecutivos

Definiciones obtenidas de la web: http://www.sinnexus.com/business_intelligence/

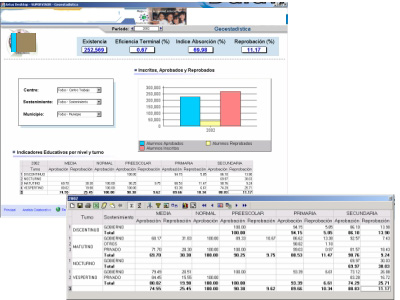

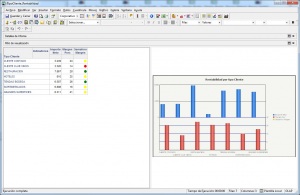

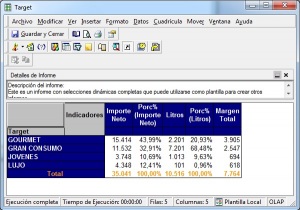

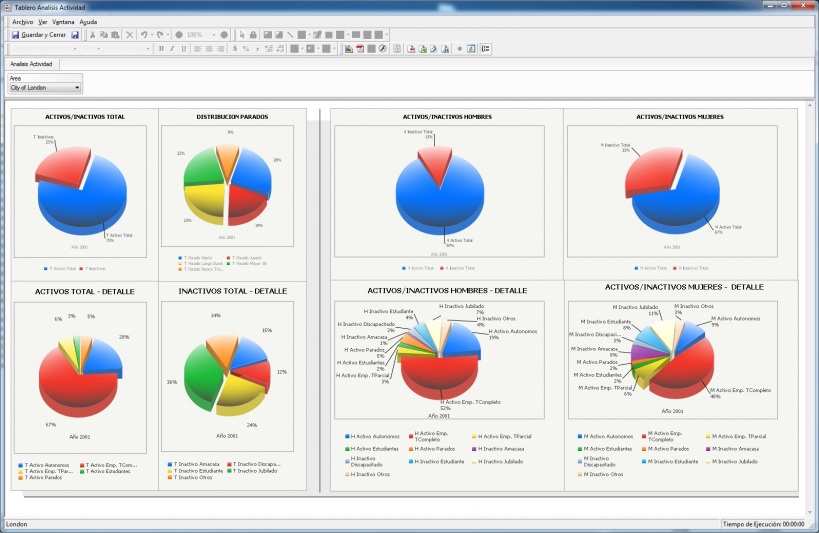

Soluciones que permiten visualizar, de una forma rápida y fácil, el estado de una determinada situación empresarial, presente o pasada, y que permite detectar anomalías o oportunidades. Aplicaciones de alto nivel que pretenden, mediante el acceso a las diferentes bases de datos de una empresa, ofrecer a sus directivos los elementos clave para que puedan tomar decisiones sobre la marcha de sus negocios. Generalmente el directivo accede a pantallas gráficas o cuadros de mando en las que se resumen los elementos más importantes que debe tener en cuenta para la toma de decisiones. Podrían contestar a la pregunta: ¿que necesito conocer ahora?.

Un Sistema de Información para Ejecutivos o Sistema de Información Ejecutiva es una herramienta software, basada en un DSS, que provee a los gerentes de un acceso sencillo a información interna y externa de su compañía, y que es relevante para sus factores clave de éxito.

La finalidad principal es que el ejecutivo tenga a su disposición un panorama completo del estado de los indicadores de negocio que le afectan al instante, manteniendo también la posibilidad de analizar con detalle aquellos que no estén cumpliendo con las expectativas establecidas, para determinar el plan de acción más adecuado.

De forma más pragmática, se puede definir un EIS como una aplicación informática que muestra informes y listados (query & reporting) de las diferentes áreas de negocio, de forma consolidada, para facilitar la monitorización de la empresa o de una unidad de la misma.

El EIS se caracteriza por ofrecer al ejecutivo un acceso rápido y efectivo a la información compartida, utilizando interfaces gráficas visuales e intutivas. Suele incluir alertas e informes basados en excepción, así como históricos y análisis de tendencias. También es frecuente que permita la domiciliación por correo de los informes más relevantes.

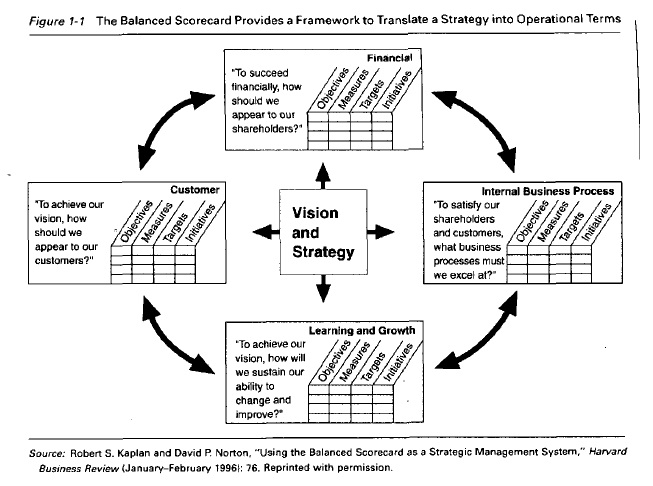

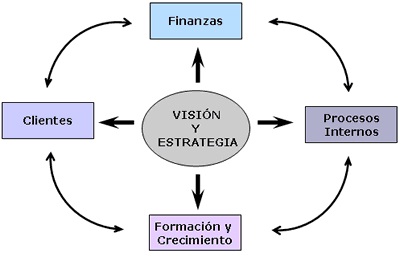

A través de esta solución se puede contar con un resumen del comportamiento de una organización o área específica, y poder compararla a través del tiempo. Es posible, además, ajustar la visión de la información a la teoría de Balanced Scorecard o Cuadro de Mando Integral impulsada por Norton y Kaplan, o bien a cualquier modelo estratégico de indicadores que maneje la compañía.

Cuadro de Mando Integral

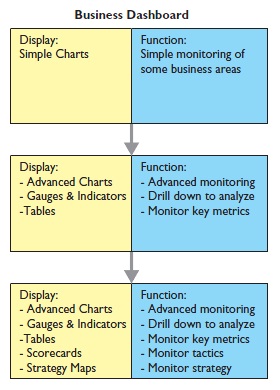

El Cuadro de Mando Integral (CMI), también conocido como Balanced Scorecard (BSC) o dashboard, es una herramienta de control empresarial que permite establecer y monitorizar los objetivos de una empresa y de sus diferentes áreas o unidades.

También se puede considerar como una aplicación que ayuda a una compañía a expresar los objetivos e iniciativas necesarias para cumplir con su estrategia, mostrando de forma continuada cuándo la empresa y los empleados alcanzan los resultados definidos en su plan estratégico.

Diferencia con otras herramientas de Business Intelligence

El Cuadro de Mando Integral se diferencia de otras herramientas de Business Intelligence, como los Sistemas de Soporte a la Decisión (DSS) o los Sistemas de Información Ejecutiva (EIS), en que está más orientados al seguimiento de indicadores que al análisis minucioso de información. Por otro lado, es muy común que un CMI sea controlado por la dirección general de una compañía, frente a otras herramientas de Business Intelligence más enfocadas a a la dirección departamental. El CMI requiere, por tanto, que los directivos analicen el mercado y la estrategia para construir un modelo de negocio que refleje las interrelaciones entre los diferentes componentes de la empresa (plan estratégico). Una vez que lo han construido, los responsables de la organización utilizan este modelo como mapa para seleccionar los indicadores del CMI.

Tipos de Cuadros de Mando

El Cuadro de Mando Operativo (CMO), es una herramienta de control enfocada al seguimiento de variables operativas, es decir, variables pertenecientes a áreas o departamentos específicos de la empresa. La periodicidad de los CMO puede ser diaria, semanal o mensual, y está centrada en indicadores que generalmente representan procesos, por lo que su implantación y puesta en marcha es más sencilla y rápida. Un CMO debería estar siempre ligado a un DSS (Sistema de Soporte a Decisiones) para indagar en profundidad sobre los datos.

El Cuadro de Mando Integral (CMI), por el contrario, representa la ejecución de la estrategia de una compañía desde el punto de vista de la Dirección General (lo que hace que ésta deba estar plenamente involucrada en todas sus fases, desde la definición a la implantación). Existen diferentes tipos de cuadros de mando integral, si bien los más utilizados son los que se basan en la metodología de Kaplan & Norton. La principales características de esta metodología son que utilizan tanto indicadores financieros como no financieros, y que los objetivos estratégicos se organizan en cuatro áreas o perspectivas: financiera, cliente, interna y aprendizaje/crecimiento.

La perspectiva financiera incorpora la visión de los accionistas y mide la creación de valor de la empresa. Responde a la pregunta: ¿Qué indicadores tienen que ir bien para que los esfuerzos de la empresa realmente se transformen en valor? Esta perspectiva valora uno de los objetivos más relevantes de organizaciones con ánimo de lucro, que es, precisamente, crear valor para la sociedad.

La perspectiva financiera incorpora la visión de los accionistas y mide la creación de valor de la empresa. Responde a la pregunta: ¿Qué indicadores tienen que ir bien para que los esfuerzos de la empresa realmente se transformen en valor? Esta perspectiva valora uno de los objetivos más relevantes de organizaciones con ánimo de lucro, que es, precisamente, crear valor para la sociedad.

La perspectiva del cliente refleja el posicionamiento de la empresa en el mercado o, más concretamente, en los segmentos de mercado donde quiere competir. Por ejemplo, si una empresa sigue una estrategia de costes es muy posible que la clave de su éxito dependa de una cuota de mercado alta y unos precios más bajos que la competencia. Dos indicadores que reflejan este posicionamiento son la cuota de mercado y un índice que compare los precios de la empresa con los de la competencia.

La perspectiva del cliente refleja el posicionamiento de la empresa en el mercado o, más concretamente, en los segmentos de mercado donde quiere competir. Por ejemplo, si una empresa sigue una estrategia de costes es muy posible que la clave de su éxito dependa de una cuota de mercado alta y unos precios más bajos que la competencia. Dos indicadores que reflejan este posicionamiento son la cuota de mercado y un índice que compare los precios de la empresa con los de la competencia.

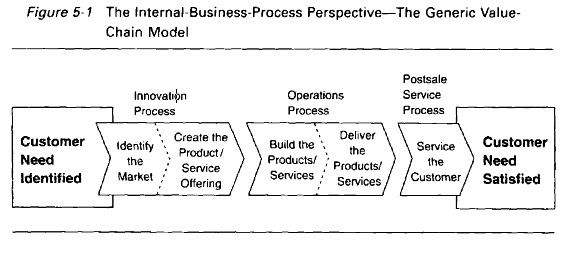

La perspectiva interna recoge indicadores de procesos internos que son críticos para el posicionamiento en el mercado y para llevar la estrategia a buen puerto. En el caso de la empresa que compite en coste, posiblemente los indicadores de productividad, calidad e innovación de procesos sean importantes. El éxito en estas dimensiones no sólo afecta a la perspectiva interna, sino también a la financiera, por el impacto que tienen sobre las rúbricas de gasto.

La perspectiva interna recoge indicadores de procesos internos que son críticos para el posicionamiento en el mercado y para llevar la estrategia a buen puerto. En el caso de la empresa que compite en coste, posiblemente los indicadores de productividad, calidad e innovación de procesos sean importantes. El éxito en estas dimensiones no sólo afecta a la perspectiva interna, sino también a la financiera, por el impacto que tienen sobre las rúbricas de gasto.

La perspectiva de aprendizaje y crecimiento es la última que se plantea en este modelo de CMI. Para cualquier estrategia, los recursos materiales y las personas son la clave del éxito. Pero sin un modelo de negocio apropiado, muchas veces es difícil apreciar la importancia de invertir, y en épocas de crisis lo primero que se recorta es precisamente la fuente primaria de creación de valor: se recortan inversiones en la mejora y el desarrollo de los recursos.

La perspectiva de aprendizaje y crecimiento es la última que se plantea en este modelo de CMI. Para cualquier estrategia, los recursos materiales y las personas son la clave del éxito. Pero sin un modelo de negocio apropiado, muchas veces es difícil apreciar la importancia de invertir, y en épocas de crisis lo primero que se recorta es precisamente la fuente primaria de creación de valor: se recortan inversiones en la mejora y el desarrollo de los recursos.

Pese a que estas cuatro son las perspectivas más genéricas, no son “obligatorias”. Por ejemplo, una empresa de fabricación de ropa deportiva tiene, además de la perspectiva de clientes, una perspectiva de consumidores. Para esta empresa son tan importantes sus distribuidores como sus clientes finales.

Una vez que se tienen claros los objetivos de cada perspectiva, es necesario definir los indicadores que se utilizan para realizar su seguimiento. Para ello, debemos tener en cuenta varios criterios: el primero es que el número de indicadores no supere los siete por perspectiva, y si son menos, mejor. La razón es que demasiados indicadores difuminan el mensaje que comunica el CMI y, como resultado, los esfuerzos se dispersan intentando perseguir demasiados objetivos al mismo tiempo. Puede ser recomendable durante el diseño empezar con una lista más extensa de indicadores. Pero es necesario un proceso de síntesis para disponer de toda la fuerza de esta herramienta.

No obstante, la aportación que ha convertido al CMI en una de las herramientas más significativas de los últimos años es que se cimenta en un modelo de negocio. El éxito de su implantación radica en que el equipo de dirección se involucre y dedique tiempo al desarrollo de su propio modelo de negocio.

Beneficios de la implantación de un Cuadro de Mando Integral

- La fuerza de explicitar un modelo de negocio y traducirlo en indicadores facilita el consenso en toda la empresa, no sólo de la dirección, sino también de cómo alcanzarlo.

- Clarifica cómo las acciones del día a día afectan no sólo al corto plazo, sino también al largo plazo.

- Una vez el CMI está en marcha, se puede utilizar para comunicar los planes de la empresa, aunar los esfuerzos en una sola dirección y evitar la dispersión. En este caso, el CMI actúa como un sistema de control por excepción.

- Permita detectar de forma automática desviaciones en el plan estratégico u operativo, e incluso indagar en los datos operativos de la compañía hasta descubrir la causa original que dió lugar a esas desviaciones.

Riesgos de la implantación de un Cuadro de Mando Integral

- Un modelo poco elaborado y sin la colaboración de la dirección es papel mojado, y el esfuerzo será en vano.

- Si los indicadores no se escogen con cuidado, el CMI pierde una buena parte de sus virtudes, porque no comunica el mensaje que se quiere transmitir.

- Cuando la estrategia de la empresa está todavía en evolución, es contraproducente que el CMI se utilice como un sistema de control clásico y por excepción, en lugar de usarlo como una herramienta de aprendizaje.

- Existe el riesgo de que lo mejor sea enemigo de lo bueno, de que el CMI sea perfecto, pero desfasado e inútil.

Podeis ampliar información en la monografía realizada por Francisco Martínez Fernández.

Sistemas de Soporte a la Decisión (DSS)

Un Sistema de Soporte a la Decisión (DSS) es una herramienta de Business Intelligence enfocada al análisis de los datos de una organización.

En principio, puede parecer que el análisis de datos es un proceso sencillo, y fácil de conseguir mediante una aplicación hecha a medida o un ERP sofisticado. Sin embargo, no es así: estas aplicaciones suelen disponer de una serie de informes predefinidos en los que presentan la información de manera estática, pero no permiten profundizar en los datos, navegar entre ellos, manejarlos desde distintas perspectivas… etc.

El DSS es una de las herramientas más emblemáticas del Business Intelligence ya que, entre otras propiedades, permiten resolver gran parte de las limitaciones de los programas de gestión. Estas son algunas de sus características principales:

Informes dinámicos, flexibles e interactivos, de manera que el usuario no tenga que ceñirse a los listados predefinidos que se configuraron en el momento de la implantación, y que no siempre responden a sus dudas reales.

Informes dinámicos, flexibles e interactivos, de manera que el usuario no tenga que ceñirse a los listados predefinidos que se configuraron en el momento de la implantación, y que no siempre responden a sus dudas reales.

No requiere conocimientos técnicos. Un usuario no técnico puede crear nuevos gráficos e informes y navegar entre ellos, haciendo drag&drop o drill through. Por tanto, para examinar la información disponible o crear nuevas métricas no es imprescindible buscar auxilio en el departamento de informática.

No requiere conocimientos técnicos. Un usuario no técnico puede crear nuevos gráficos e informes y navegar entre ellos, haciendo drag&drop o drill through. Por tanto, para examinar la información disponible o crear nuevas métricas no es imprescindible buscar auxilio en el departamento de informática.

Rapidez en el tiempo de respuesta, ya que la base de datos subyacente suele ser un datawarehouse corporativo o un datamart, con modelos de datos en estrella o copo de nieve. Este tipo de bases de datos están optimizadas para el análisis de grandes volúmenes de información (vease ánalisis OLTP-OLAP).

Rapidez en el tiempo de respuesta, ya que la base de datos subyacente suele ser un datawarehouse corporativo o un datamart, con modelos de datos en estrella o copo de nieve. Este tipo de bases de datos están optimizadas para el análisis de grandes volúmenes de información (vease ánalisis OLTP-OLAP).

Integración entre todos los sistemas/departamentos de la compañía. El proceso de ETL previo a la implantación de un Sistema de Soporte a la Decisión garantiza la calidad y la integración de los datos entre las diferentes unidades de la empresa. Existe lo que se llama: integridad referencial absoluta.

Integración entre todos los sistemas/departamentos de la compañía. El proceso de ETL previo a la implantación de un Sistema de Soporte a la Decisión garantiza la calidad y la integración de los datos entre las diferentes unidades de la empresa. Existe lo que se llama: integridad referencial absoluta.

Cada usuario dispone de información adecuada a su perfil. No se trata de que todo el mundo tenga acceso a toda la información, sino de que tenga acceso a la información que necesita para que su trabajo sea lo más eficiente posible.

Cada usuario dispone de información adecuada a su perfil. No se trata de que todo el mundo tenga acceso a toda la información, sino de que tenga acceso a la información que necesita para que su trabajo sea lo más eficiente posible.

Disponibilidad de información histórica. En estos sistemas está a la orden del día comparar los datos actuales con información de otros períodos históricos de la compañía, con el fin de analizar tendencias, fijar la evolución de parámetros de negocio… etc.

Disponibilidad de información histórica. En estos sistemas está a la orden del día comparar los datos actuales con información de otros períodos históricos de la compañía, con el fin de analizar tendencias, fijar la evolución de parámetros de negocio… etc.

Diferencia con otras herramientas de Business Intelligence

El principal objetivo de los Sistemas de Soporte a Decisiones es, a diferencia de otras herramientas como los Cuadros de Mando (CMI) o los Sistemas de Información Ejecutiva (EIS), explotar al máximo la información residente en una base de datos corporativa (datawarehouse o datamart), mostrando informes muy dinámicos y con gran potencial de navegación, pero siempre con una interfaz gráfica amigable, vistosa y sencilla.

Otra diferencia fundamental radica en los usuarios a los que están destinadas las plataformas DSS: cualquier nivel gerencial dentro de una organización, tanto para situaciones estructuradas como no estructuradas. (En este sentido, por ejemplo, los CMI están más orientados a la alta dirección).

Por último, destacar que los DSS suelen requerir (aunque no es imprescindible) un motor OLAP subyacente, que facilite el análisis casi ilimitado de los datos para hallar las causas raices de los problemas/pormenores de la compañía.

Tipos de Sistemas de Soporte a Decisiones

Sistemas de información gerencial (MIS)

Sistemas de información gerencial (MIS)

Los sistemas de información gerencial (MIS, Management Information Systems), tambien llamados Sistemas de Información Administrativa (AIS) dan soporte a un espectro más amplio de tareas organizacionales, encontrándose a medio camino entre un DSS tradicional y una aplicación CRM/ERP implantada en la misma compañía.

Sistemas de información ejecutiva (EIS)

Sistemas de información ejecutiva (EIS)

Los sistemas de información ejecutiva (EIS, Executive Information System) son el tipo de DSS que más se suele emplear en Business Intelligence, ya que proveen a los gerentes de un acceso sencillo a información interna y externa de su compañía, y que es relevante para sus factores clave de éxito.

Sistemas expertos basados en inteligencia artificial (SSEE)

Sistemas expertos basados en inteligencia artificial (SSEE)

Los sistemas expertos, también llamados sistemas basados en conocimiento, utilizan redes neuronales para simular el conocimiento de un experto y utilizarlo de forma efectiva para resolver un problema concreto. Este concepto está muy relacionado con el datamining.

Sistemas de apoyo a decisiones de grupo (GDSS)

Sistemas de apoyo a decisiones de grupo (GDSS)

Un sistema de apoyo a decisiones en grupos (GDSS, Group Decision Support Systems) es “un sistema basado en computadoras que apoya a grupos de personas que tienen una tarea (u objetivo) común, y que sirve como interfaz con un entorno compartido”. El supuesto en que se basa el GDSS es que si se mejoran las comunicaciones se pueden mejorar las decisiones.

Definiciones obtenidas de la web: http://www.sinnexus.com/business_intelligence/

Algunos de los productos del mercado orientados a EIS y DSS los podemos obtener en la web de Dataprix.com

DataMining o Mineria de Datos.

DataMining o Mineria de Datos. respinosamilla 25 Febrero, 2010 - 09:50Introducción

(Definiciones extraidas del Consejo Superior de Informatica, del documento Manual para la adquisición de un sistema de Data Warehouse, en http://www.csi.map.es/csi/silice/Elogicos.html ).

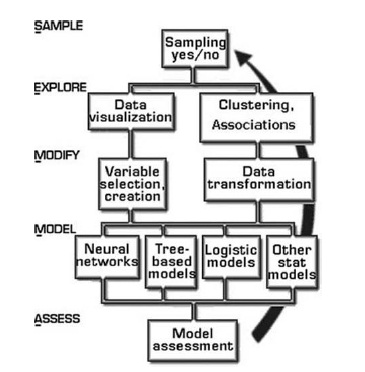

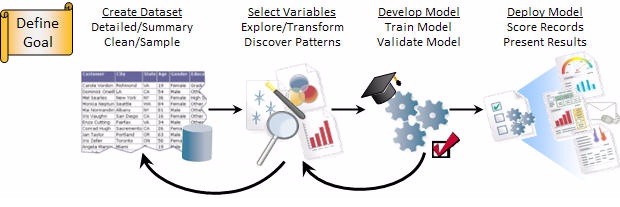

El Data Mining es un proceso que, a través del descubrimiento y cuantificacion de relaciones predictivas en los datos, permite transformar la información disponible en conocimiento útil de negocio.Esto es debido a que no es suficiente “navegar” por los datos para resolver los problemas de negocio, sino que se hace necesario seguir una metodología ordenada que permita obtener rendimientos tangibles de este conjunto de herramientas y técnicas de las que dispone el usuario.

Constituye por tanto una de las vías clave de explotación del Data Warehouse, dado que es este su entorno natural de trabajo.

Se trata de un concepto de explotación de naturaleza radicalmente distinta a la de los sistemas de información de gestión, dado que no se basa en coeficientes de gestión o en información altamente agregada, sino en la información de detalle contenida en el almacén.

Adicionalmente, el usuario no se conforma con la mera visualización de datos, sino que trata de obtener una relación entre los mismos que tenga repercusiones en su negocio.

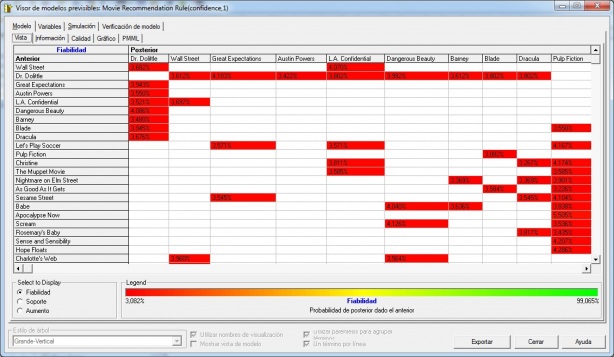

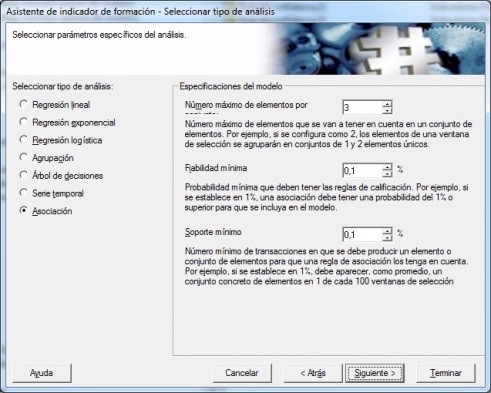

Técnicas de Data Mining

Para soportar el proceso de Data Mining, el usuario dispone de una extensa gama de técnicas que le pueden ayudar en cada una de las fases de dicho proceso, las cuales pasamos a describir:

Análisis estadístico:

Utilizando las siguientes herramientas:

1.ANOVA: o Análisis de la Varianza, contrasta si existen diferencias significativas entre las medidas de una o más variables continuas en grupo de población distintos.

2.Regresión: define la relación entre una o más variables y un conjunto de variables predictoras de las primeras.

3.Ji cuadrado: contrasta la hipótesis de independencia entre variables. Componentes principales: permite reducir el número de variables observadas a un menor número de variables artificiales, conservando la mayor parte de la información sobre la varianza de las variables.

4.Análisis cluster: permite clasificar una población en un número determinado de grupos, en base a semejanzas y desemejanzas de perfiles existentes entre los diferentes componentes de dicha población.

5.Análisis discriminante: método de clasificación de individuos en grupos que previamente se han establecido, y que permite encontrar la regla de clasificación de los elementos de estos grupos, y por tanto identificar cuáles son las variables que mejor definan la pertenencia al grupo.

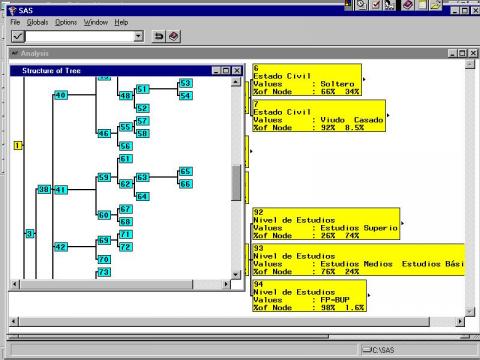

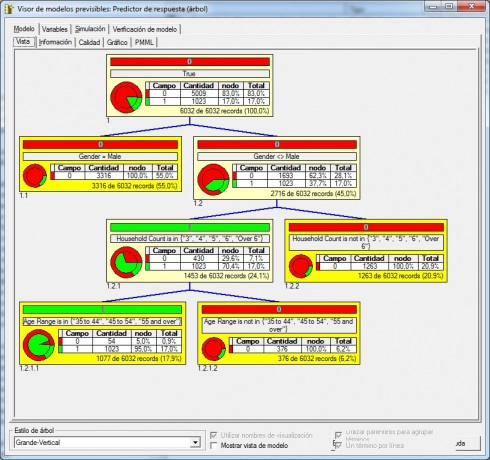

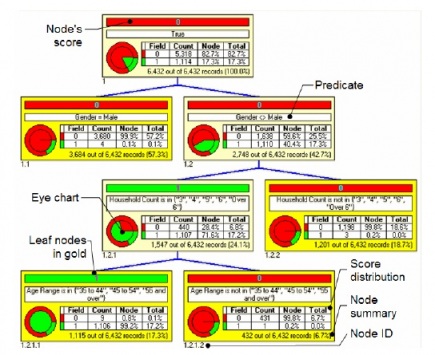

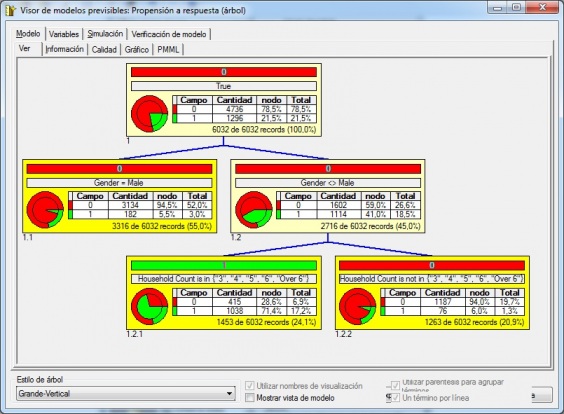

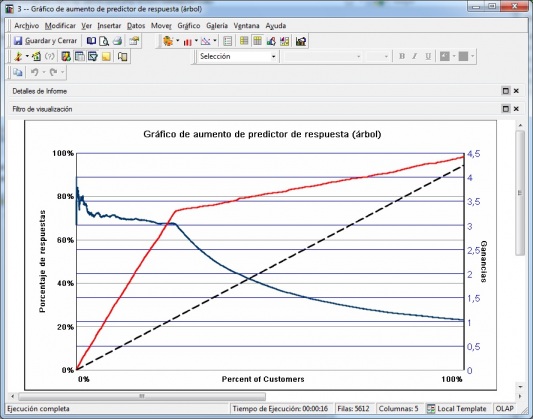

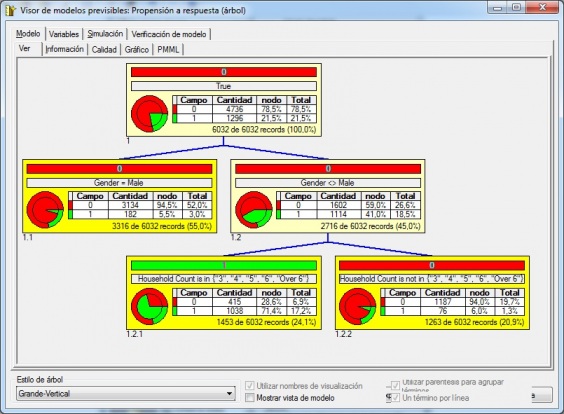

Métodos basados en árboles de decisión:

El método Chaid (Chi Squared Automatic Interaction Detector) es un análisis que genera un árbol de decisión para predecir el comportamiento de una variable, a partir de una o más variables predictoras, de forma que los conjuntos de una misma rama y un mismo nivel son disjuntos. Es útil en aquellas situaciones en las que el objetivo es dividir una población en distintos segmentos basándose en algún criterio de decisión.

El árbol de decisión se construye partiendo el conjunto de datos en dos o más subconjuntos de observaciones a partir de los valores que toman las variables predictoras. Cada uno de estos subconjuntos vuelve después a ser particionado utilizando el mismo algoritmo. Este proceso continúa hasta que no se encuentran diferencias significativas en la influencia de las variables de predicción de uno de estos grupos hacia el valor de la variable de respuesta.

La raíz del árbol es el conjunto de datos íntegro, los subconjuntos y los subsubconjuntos conforman las ramas del árbol. Un conjunto en el que se hace una partición se llama nodo.

El número de subconjuntos en una partición puede ir de dos hasta el número de valores distintos que puede tomar la variable usada para hacer la separación. La variable de predicción usada para crear una partición es aquella más significativamente relacionada con la variable de respuesta de acuerdo con test de independencia de la Chi cuadrado sobre una tabla de contingencia.

Algoritmos genéticos:

Son métodos numéricos de optimización, en los que aquella variable o variables que se pretenden optimizar junto con las variables de estudio constituyen un segmento de información. Aquellas configuraciones de las variables de análisis que obtengan mejores valores para la variable de respuesta, corresponderán a segmentos con mayor capacidad reproductiva. A través de la reproducción, los mejores segmentos perduran y su proporción crece de generación en generación. Se puede además introducir elementos aleatorios para la modificación de las variables (mutaciones). Al cabo de cierto número de iteraciones, la población estará constituida por buenas soluciones al problema de optimización.

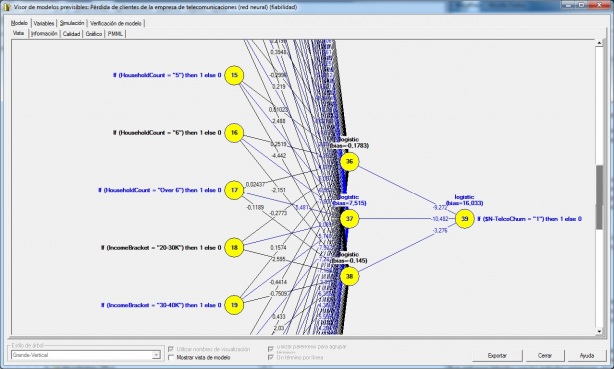

Redes neuronales:

Genéricamente son métodos de proceso numérico en paralelo, en el que las variables interactúan mediante transformaciones lineales o no lineales, hasta obtener unas salidas. Estas salidas se contrastan con los que tenían que haber salido, basándose en unos datos de prueba, dando lugar a un proceso de retroalimentación mediante el cual la red se reconfigura, hasta obtener un modelo adecuado.

Lógica difusa:

Es una generalización del concepto de estadística. La estadística clásica se basa en la teoría de probabilidades, a su vez ésta en la técnica conjuntista, en la que la relación de pertenencia a un conjunto es dicotómica (el 2 es par o no lo es). Si establecemos la noción de conjunto borroso como aquel en el que la pertenencia tiene una cierta graduación (¿un día a 20ºC es caluroso?), dispondremos de una estadística más amplia y con resultados más cercanos al modo de razonamiento humano.

Series temporales:

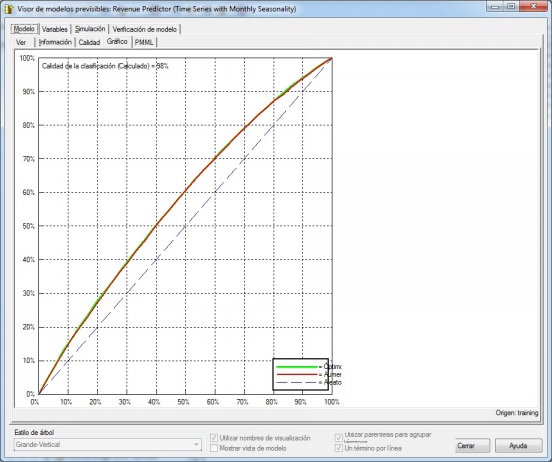

Es el conocimiento de una variable a través del tiempo para, a partir de ese conocimiento, y bajo el supuesto de que no van a producirse cambios estructurales, poder realizar predicciones. Suelen basarse en un estudio de la serie en ciclos, tendencias y estacionalidades, que se diferencian por el ámbito de tiempo abarcado, para por composición obtener la serie original. Se pueden aplicar enfoques híbridos con los métodos anteriores, en los que la serie se puede explicar no sólo en función del tiempo sino como combinación de otras variables de entorno más estables y, por lo tanto, más fácilmente predecibles.

Metodología de aplicación:

Para utilizar estas técnicas de forma eficiente y ordenada es preciso aplicar una metodología estructurada, al proceso de Data Mining. A este respecto proponemos la siguiente metodología, siempre adaptable a la situación de negocio particular a la que se aplique:

Muestreo

Extracción de la población muestral sobre la que se va a aplicar el análisis. En ocasiones se trata de una muestra aleatoria, pero puede ser también un subconjunto de datos del Data Warehouse que cumplan unas condiciones determinadas. El objeto de trabajar con una muestra de la población en lugar de toda ella, es la simplificación del estudio y la disminución de la carga de proceso. La muestra más óptima será aquella que teniendo un error asumible contenga el número mínimo de observaciones.

En el caso de que se recurra a un muestreo aleatorio, se debería tener la opción de elegir El nivel de confianza de la muestra (usualmente • el 95% o el 99%).

El tamaño máximo de la muestra (número máximo de registros), en cuyo caso el sistema deberá informar del el error cometido y la representatividad de la muestra sobre la población original.

•El error muestral que está dispuesto a cometer, en cuyo caso el sistema informará del número de observaciones que debe contener la muestra y su representatividad sobre la población original.

•Para facilitar este paso s debe disponer de herramientas de extracción dinámica de información con o sin muestreo (simple o estratificado). En el caso del muestreo, dichas herramientas deben tener la opción de, dado un nivel de confianza, fijar el tamaño de la muestra y obtener el error o bien fijar el error y obtener el tamaño mínimo de la muestra que nos proporcione este grado de error.

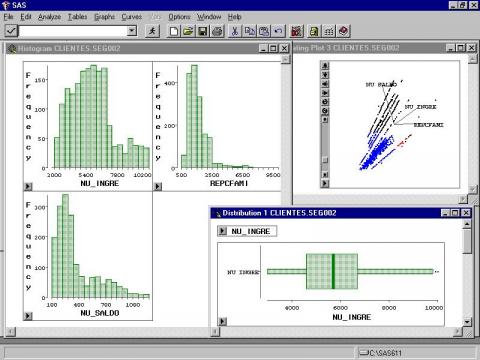

Exploración

Una vez determinada la población que sirve para la obtención del modelo se deberá determinar cuales son las variables explicativas que van a servir como “inputs” al modelo. Para ello es importante hacer una exploración por la información disponible de la población que nos permita eliminar variables que no influyen y agrupar aquellas que repercuten en la misma dirección.

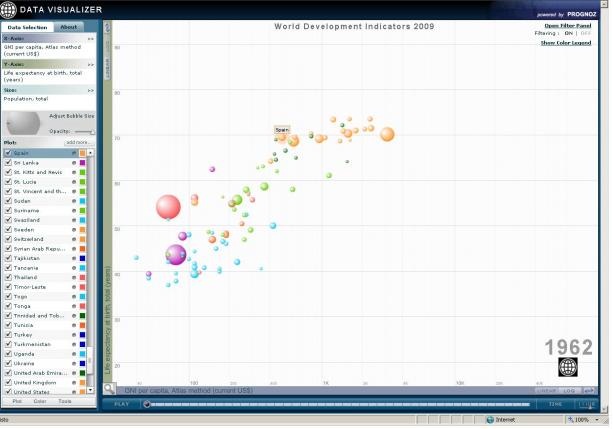

El objetivo es simplificar en lo posible el problema con el fin de optimizar la eficiencia del modelo. En este paso se pueden emplear herramientas que nos permitan visualizar de forma gráfica la información utilizando las variables explicativas como dimensiones.

También se pueden emplear técnicas estadísticas que nos ayuden a poner de manifiesto relaciones entre variables. A este respecto resultará ideal una herramienta que permita la visualización y el análisis estadístico integrados.

Manipulación

Tratamiento realizado sobre los datos de forma previa a la modelización, en base a la exploración realizada, de forma que se definan claramente los inputs del modelo a realizar (selección de variables explicativas, agrupación de variables similares, etc.).

Modelización

Permite establecer una relación entre las variables explicativas y las variables objeto del estudio, que posibilitan inferir el valor de las mismas con un nivel de confianza determinado.

Valoración

Análisis de la bondad del modelo contrastando con otros métodos estadísticos o con nuevas poblaciones muestrales.

___________________________________________________________________________________________________

En el artículo de Luis Carlos Molina, coordinador del programa de Data Mining de la UOC, también se dan definiciones interesantes desde otro punto de vista (..”torturando a los datos hasta que confiesen” ).

http://www.uoc.edu/web/esp/art/uoc/molina1102/molina1102.html

En este artículo se da una vision global de todo lo relacionado con DataMining, así como ejemplos prácticos de su utilización.

___________________________________________________________________________________________________

Mas información, igualmente, en la monografía elaborada por Cynthia Presser Carne

http://www.monografias.com/trabajos/datamining/datamining.shtml

___________________________________________________________________________________________________

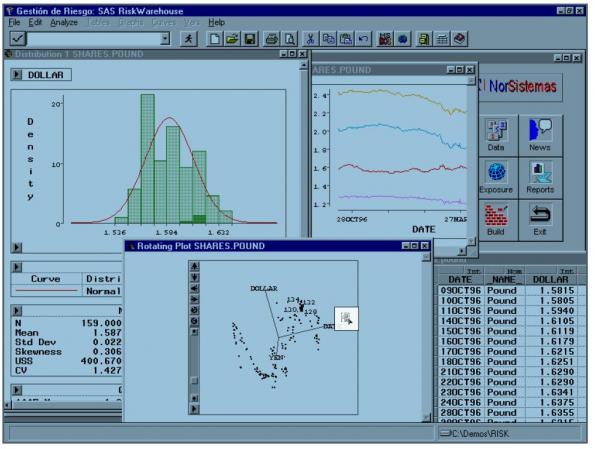

Algunas herramientas de DataMining serían las siguientes (obtenidas de las páginas www.datati.es y www.dataprix.com):

· Aqua BAS 2008 / Aqua eSolutions

· IBM / SPSS: Herramienta de data mining que permite desarrollar modelos predictivos y desplegarlos para mejorar la toma de decisiones. Está diseñada teniendo en cuenta a los usuarios empresariales, de manera que no es preciso ser un experto en data mining.

· dVelox 2.5/ Apara: Plataforma analítica para la toma de decisiones en tiempo real que predice los escenarios futuros más probables para optimizar los procesos críticos de cualquier empresa, Está orientada a los sectores de banca, finanzas y márketing.

· Microsoft SQL Server 2008 Datamining: Solución que ofrece un entorno integrado para crear modelos de minería de datos (Data Mining) y trabajar con ellos. La solución SQL Server Data Mining permite el acceso a la información necesaria para tomar decisiones inteligentes sobre problemas empresariales complejos. Data Mining es la tecnología de BI que ayuda a construir modelos analíticos complejos e integrar esos modelos con sus operaciones comerciales.

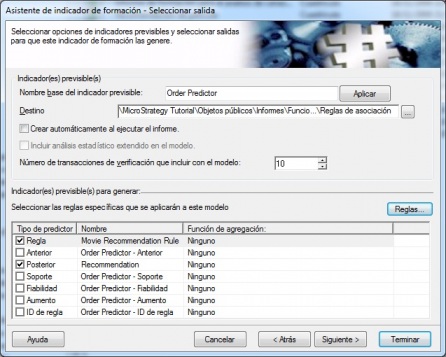

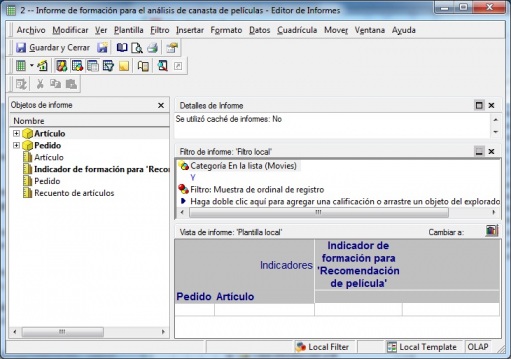

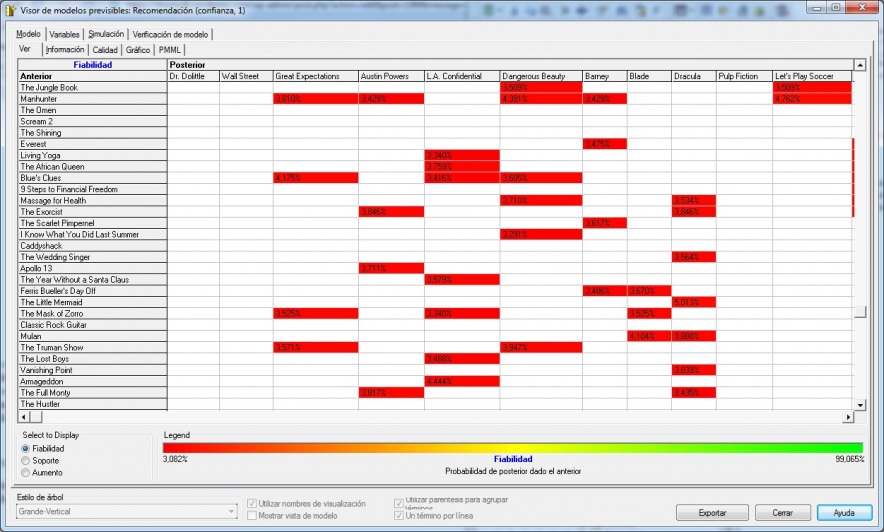

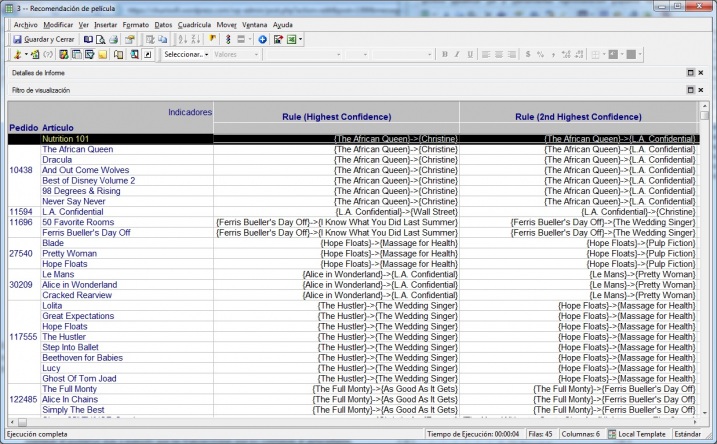

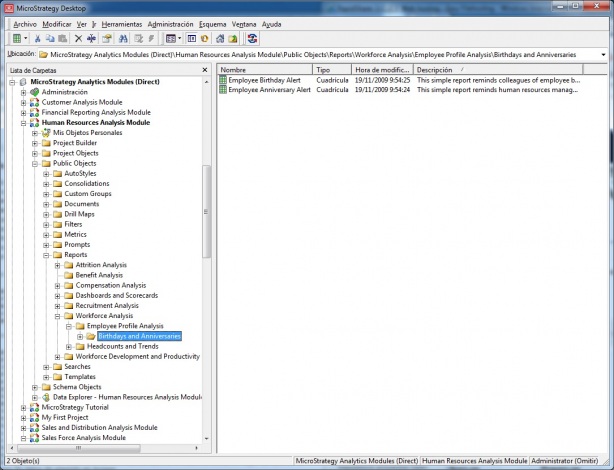

· MicroStrategy Data Mining Services /Microstrategy: Componente de la plataforma de BI de MicroStrategy que proporciona a los usuarios, modelos predictivos de data mining. Permite realizar tareas de data mining mediante el uso de métricas construidas con funciones predictivas o importadas de modelos de datos de herramientas de data mining de terceros.

· SAS Enterprise Miner / SAS: Solución de minería de datos que proporciona gran cantidad de modelos y de alternativas. Permite determinar pautas y tendencias, explica resultados conocidos e identifica factores que permiten asegurar efectos deseados. Además, compara los resultados de las distintas técnicas de modelización, tanto en términos estadísticos como de negocio, dentro de un marco sencillo y fácil de interpretar.

· Oracle DataMining: Función de Oracle 11g Enterprise Edition que permite diseñar aplicaciones de BI que más tarde realizan funciones de «minería» en las bases de datos corporativas para descubrir nueva información e integrarla con las aplicaciones de negocio.

· MIS Delta Miner / MIS: Herramienta concebida para efectuar análisis de alto nivel, detección de desviaciones y análisis interactivo sobre múltiples fuentes, tanto transaccionales (SQL Server, Oracle, DB2, etc) como multidimensionales (Hyperion Essbase, SAP BW, MS Analysis Services y Oracle Express).

· Teradata Warehouse Miner / Teradata: Solución que facilita la construcción de modelos analíticos directamente sobre la base de datos, eliminando así la necesidad de extraer muestras a sistemas del exterior. Además permite analizar datos sin cambiarlos de sitio y es capaz de visualizar la información para representar regresiones lineales o logísticas.

Dentro de las herramientas OpenSource:

· Weka: Solución de minería de datos OpenSource desarrollada en la Universidad de Waikato, que consiste en una collecion de algoritmos implementados en Java para realizar minería de datos. En la actualidad esta asociado al proyecto pentaho.

· R: proyecto OpenSource de DataMining de la Universidad de Auckland.

· RapidMiner: proyecto OpenSource de DataMining.

Una lista mas completa de herramientas datamining la encontramos en la comunidad KDNUGGETS.COM (Data Mining Community’s ) en el siguiente link.

Para terminar,os recomiendo la lectura de la serie de articulos que hablan de Data Mining publicados en dataminingarticles.com (gracias a bifacil.com).

Si quereis entrar un poco mas en profundidad, podeis ver la presentación Data Mining.Extracción de Conocimiento en Grandes Bases de Datos, realizada por José M. Gutiérrez, del Dpto. de Matemática Aplicada de la Universidad de Cantabria, Santander.

Data Mining. Extracción de Conocimiento en Grandes Bases de Datos

View more presentations from respinosamilla.

En la presentación se da una visión de la Teoria de Data Mining y se hace un repaso de las diferentes tecnicas existentes, incluyendo ejemplos prácticos. Igualmente, se habla de los programas comerciales mas importantes.

Tambien os puede ser util la documentación y materiales del curso Aprendizaje Automatico y Dataming, realizado en la Universidad Miguel Hernandez de Elche por Cesar Fernandez.

KMS: Knowledge Management System o Sistemas para gestión del Conocimiento.

KMS: Knowledge Management System o Sistemas para gestión del Conocimiento. respinosamilla 25 Febrero, 2010 - 09:50Nuevas tecnologias desarrolladas para la gestión del conocimiento y su integración en una única plataforma. Son herramientas no relacionadas directamente con el Business Intelligence, pero nos permiten gestionar toda la información y el conocimiento que hay en la empresa para poder sacar un mayor partido de ella. Por ejemplo, toda la documentación interna, manuales, procedimientos que existen en la empresa estara guardada en un gestor documental que una vez indexado, se puede consultar por los integrantes de la organización de una forma ágil. Al fin y al cabo, la información es poder y cuanto mas rapida se pueda obtener, mas beneficios genera.

Knowledge Management System (KM System) se refiere a los sistemas informáticos para gestionar el conocimiento en las organizaciones, que soportan la creación, captura, almacenamiento y distribución de la información. Estos sistemas son una parte mas de la estrategia de Gestión del Conocimiento dentro de las organizaciones.

La idea de un sistema KM es permitir a los empleados tener un acceso completo a la documentación de la organización, origenes de información y soluciones. El tipico ejemplo es la empresa donde un ingeniero conoce la composiciones de metales que podria reducir el nivel del ruidos en motores. Compartiendo esta información, se podria ayudar a diseñar motores mas efectivos o podria ayudar y dar ideas a otros componenes de la organización a diseñar mejores equipamientos o a mejorar los productos. Otro ejemplo podría ser el departamento comercial que necesita información sobre los clientes y puede consultar la información recopilada por otros compañeros al respecto. O el departamento de sistemas que tienes todos sus manuales de administración y documentación informatizados y es facil buscar soluciones a problemas presentados anteriormente en dicha información.

Un sistema KM podría incluir lo siguiente:

- Tecnologia documental que permita la creación, gestion y comparticion de documentos con un formato determinado (como Lotus Notes, portales Web de gestion documental, Bases de datos distribuidas).

- Ontologia/taxonomia: similar a la tecnologias de documentacion para crear un sistema de terminologias que son usadas por sumarizar, organizar o clasificar los documentos ( por ejemplo Autor, Materia, Organizacion, etc).

- Proporcionar mapas de red de la organización para mostar el flujo de comunicacion entre las entidades y los individuos.

- Desarrollo de herramientas sociales dentro de la organizacion para sacar un mayor aprovechamiento de la creacion del sistema KM.

Los sistemas KMS trabajan con información, aunque es una disciplina que se extiende mas alla de los sistemas informaticos. Las caracteristicas mas importantes de un sistema KMS pueden incluir:

- Proposito: un KMS tiene que tener el explicito objetivo de la gestion del conocimiento, permitiendo la colaboracion, el compartir buenas practicas y similares.

- Contexto: Una perspectiva de los sistemas KMS es ver que el conocimiento es información organizada con inteligencia, acumulada e integrada en un contexto de creación y aplicacion de dicho conocimiento.

- Procesos: el sistema KMS es desarrollado para soportar y permitir procesos de conocimiento intensivo, como tareas o proyectos de creación, construcción, identificación, captura, selección, evaluación, acceso, recuperación y aplicación, que es el llamado ciclo de vida del conocimiento.

- Participantes: Los usuarios pueden jugar roles activos de participantes involucrados en las redes del conocimiento y en las comunidades, aunque esto no tiene porque ser necesariamente el caso. Los sistemas KMS esta diseñados para que el conocimiento se desarrolle colectivamente y la distribución de dicho conocimiento sea un proceso continuo de cambio, reconstrucción y aplicación en diferentes contextos, por diferentes participantes con diferentes backgrounds y experiencias.

- Instrumentos: el sistema KMS debe soportar instrumentos de gestión del conocimiento, como la captura, creación y comparticion de aspectos codificables de la experiencia, la creacion de directorios de conocimiento corporativos, con su correcta clasificacion, taxonomia u ontologia, localizadores de experiencia, sistemas de gestion de habilidades, herramientas de colaboracion para permitir conectar personas interesadas en los mismos temas, permitiendo de esta manera la creación de redes de conocimiento.

Un KMS ofrece servicios integrados para desarrollar instrumentos KM para una red de participantes, que seran trabajadores activos del conocimiento durante todo el ciclo de vida de este. Los sistemas KMS pueden ser usados para procesos de cooperacion, colaboracion entre comunidades, organizaciones virtuales, sociedades u otras redes virtuales, para gestionar contenidos, actividades, interactuar y generar flujos de trabajo, proyectos, trabajos, departamentos, privilegios, roles, participantes con el proposito de extraer y generar nuevo conocimiento, darle valor y transferirlo, generando nuevos servicios, usando nuevos formatos e interfaces en diferentes canales de comunicacion.

El termino KMS puede ser asociado a los programas Open Source y las licencias, iniciativas y politicas Open Source Software, Open Standards, Open Protocols and Open Knowledge.

Beneficios de los sistems KM

Algunas de las ventajas mas destacables de los sistemas KM son:

- La información organizacional valiosa se comparte a traves de la estructura de la organización.

- Podemos evitar reinventar la rueda, reduciendo trabajo redundante reutilizando trabajo ya realizado por otros en la misma organizacion.

- Reducción de los tiempos de formación de los nuevos empleados.

- Retencion de la propiedad Intelectual de los trabajos despues de que el empleado abandone la empresa. Es como si el conocimiento fuera codificado.

Herramientas KMS

Opensource: Alfresco, Nuxeo, OpenKm.

Propietarias: En la web de la revista KMWorld tenemos una lista de los fabricantes mas importantes.

La base de datos analítica (el Datawarehouse o Almacén de Datos)

La base de datos analítica (el Datawarehouse o Almacén de Datos) respinosamilla 25 Febrero, 2010 - 09:50Hasta ahora, hemos visto las diferentes herramientas y técnicas que podemos utilizar para explotar nuestros sistemas de Business Intelligence, para analizar la información y obtener conocimiento de los datos.

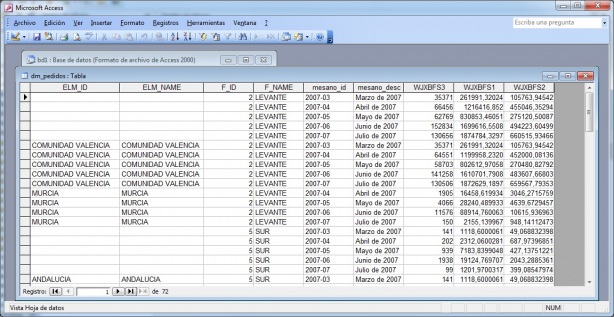

En algunos casos, desde esas mismas herramientas podríamos estar accediendo a nuestros sistemas transaccionales para analizar la información (lease ERP, CRM u otros sistemas), pero seguramente tendriamos problemas en cuanto a tiempos de respuesta; información repartida en diferentes sistemas que no son homogeneos, lo que dificulta el proceso de análisis; complejos reportes poco flexibles, etc, etc.

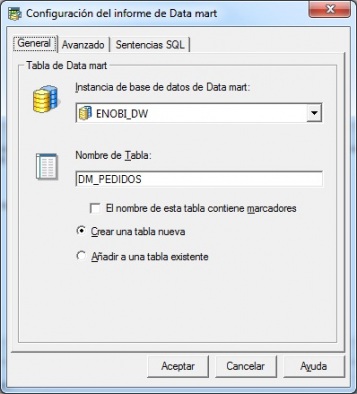

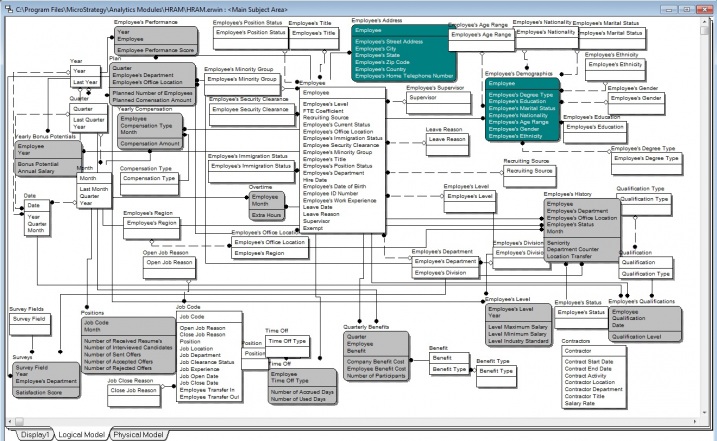

Para solucionar esto surgío el concepto de Dawarehouse o Almacen de Datos. Es una base de datos orientada al análisis y que es el CORAZON de todo proyecto de Business Intelligence. Esta base de datos deberá de poder soportar todos los tipos de herramientas de analisis que podamos utilizar.

Antes de continuar, os recomiendo visualizar el video elaborado por Josep Curto para sus alumnos de la UOC. En el se explican todos los concenptos referentes a DW, el Modelo Dimensional y todos sus componentes. También os recomiendo la serie de articulos temáticos publicados en su blog, gran trabajo.

Veamos un poco mas a fondo en que consiste:

(Definiciones extraidas del Consejo Superior de Informatica, del documento Manual para la adquisición de un sistema de Data Warehouse, en http://www.csi.map.es/csi/silice/Elogicos.html ).

3.1. Justificación histórica

En la actualidad, las tecnologías de la información han automatizado los procesos de carácter típicamente repetitivo o administrativo, haciendo uso de lo que llamaremos sistemas de información operacionales.Entendemos por aplicaciones operacionales, aquellas que resuelven las necesidades de funcionamiento de la empresa. En este tipo de sistemas, los conceptos más importantes son la actualización y el tiempo de respuesta. Una vez satisfechas las necesidades operacionales más acuciantes, surge un nuevo grupo de necesidades sobre los sistemas de la empresa, a las cuales vamos a calificar como necesidades informacionales. Por necesidades informacionales, entendemos aquellas que tienen por objeto obtener la información necesaria, que sirva de base para la toma de decisiones tanto a escala estratégica como táctica. Estas necesidades informacionales se basan en gran medida en el análisis de un número ingente de datos, en el que es tan importante el obtener un valor muy detallado de negocio como el valor totalizado para el mismo. Es fundamental también la visión histórica de todas las variables analizadas, y el análisis de los datos del entorno. Estos requerimientos no son, a priori, difíciles de resolver dado que la información está efectivamente en los sistemas operacionales. Cualquier actividad que realiza la empresa está reflejada de forma minuciosa en sus bases de datos.

La realidad, sin embargo, es distinta, puesto que al atender las necesidades de tipo informacional, los responsables de sistemas se tropiezan con múltiples problemas. En primer lugar, al realizar consultas masivas de información (con el fin de conseguir el ratio, valor agrupado o grupo de valores solicitados), se puede ver perjudicado el nivel de servicio del resto de sistemas, dado que las consultas de las que estamos hablando, suelen ser bastante costosas en recursos. Además, las necesidades se ven insatisfechas por la limitada flexibilidad a la hora de navegar por la información y a su inconsistencia debido a la falta de una visión global (cada visión particular del dato está almacenada en el sistema operacional que lo gestiona).

En esta situación, el siguiente paso evolutivo ha venido siendo la generación de un entorno gemelo del operativo, que se ha denominado comúnmente Centro de Información, en el cual la información se refresca con menor periodicidad que en los entornos operacionales y los requerimientos en el nivel de servicio al usuario son más flexibles. Con esta estrategia se resuelve el problema de la planificación de recursos ya que las aplicaciones que precisan un nivel de servicio alto usan el entorno operacional y las que precisan consultas masivas de información trabajan en el Centro de Información. Otro beneficio de este nuevo entorno, es la no inferencia con las aplicaciones operacionales.

Pero no terminan aquí los problemas. La información mantiene la misma estructura que en las aplicaciones operacionales por lo que este tipo de consultas debe acceder a multitud de lugares para obtener el conjunto de datos deseado. El tiempo de respuesta a las solicitudes de información es excesivamente elevado. Adicionalmente, al proceder la información de distintos sistemas, con visiones distintas y distintos objetivos, en muchas ocasiones no es posible obtener la información deseada de una forma fácil y además carece de la necesaria fiabilidad.

De cara al usuario estos problemas se traducen en que no dispone a tiempo de la información solicitada y que debe dedicarse con más intensidad a la obtención de la información que al análisis de la misma, que es donde aporta su mayor valor añadido.

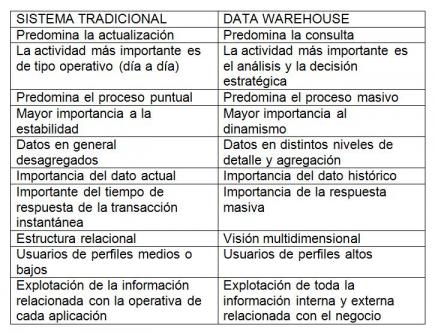

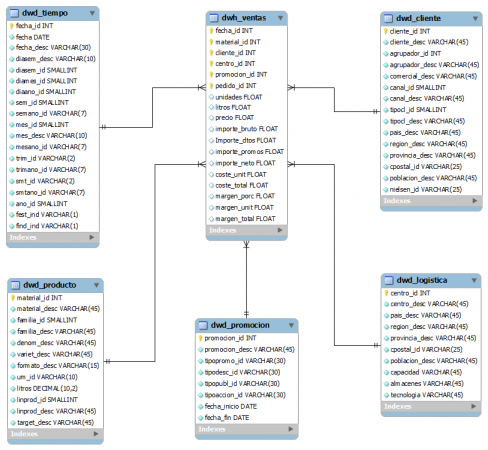

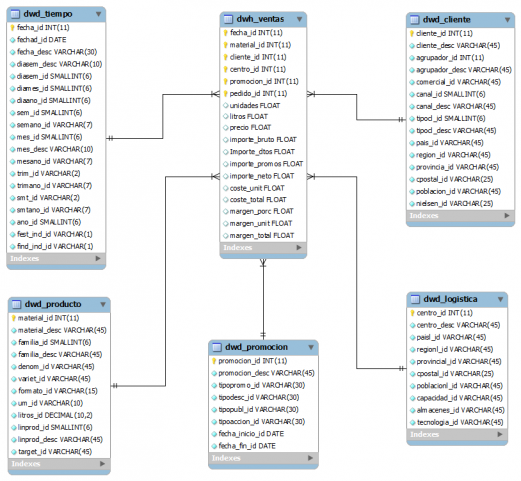

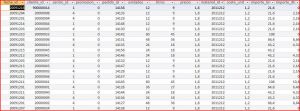

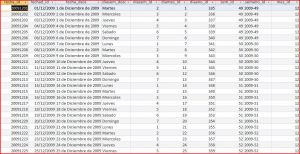

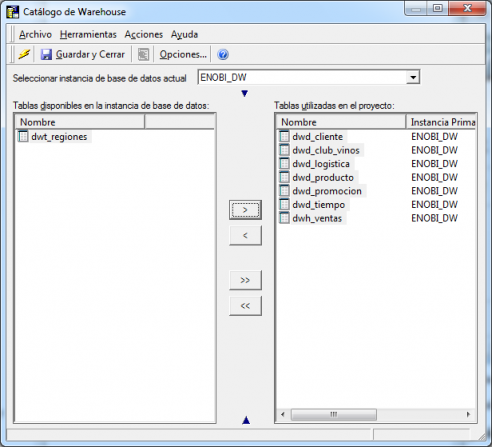

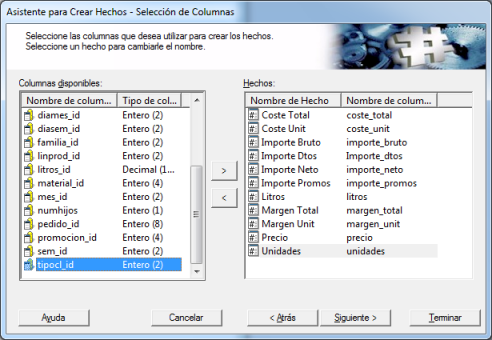

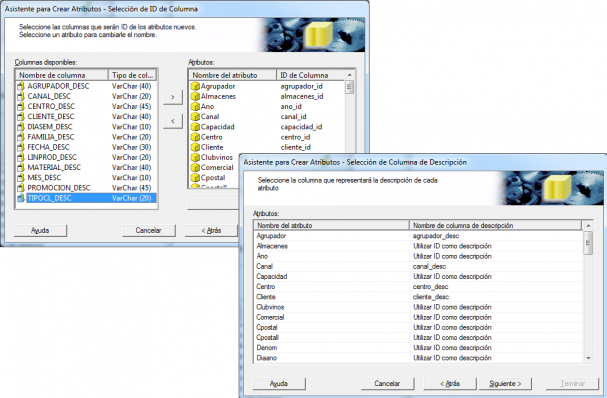

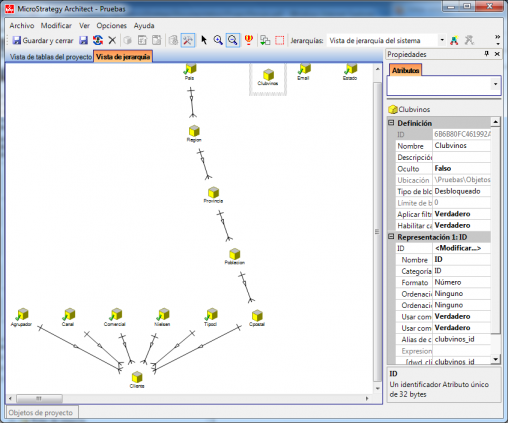

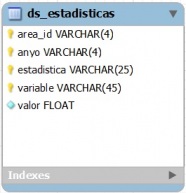

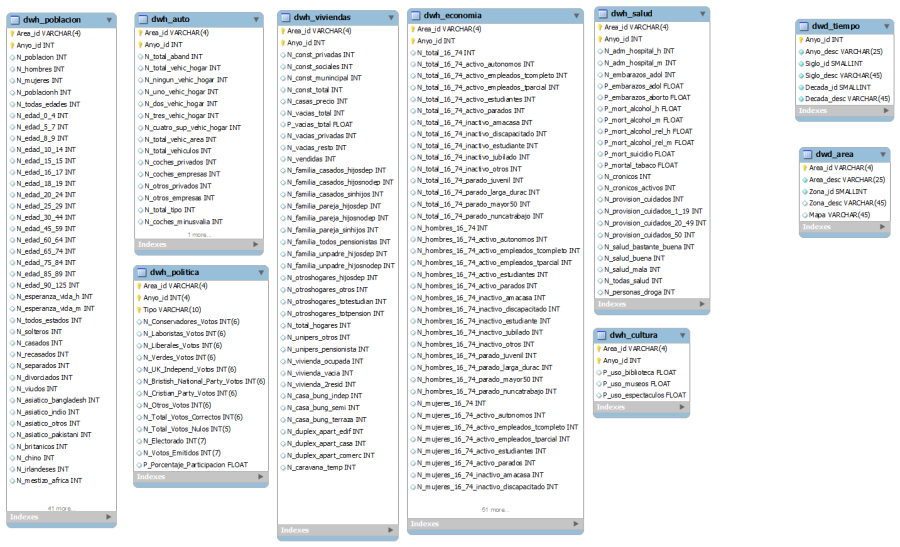

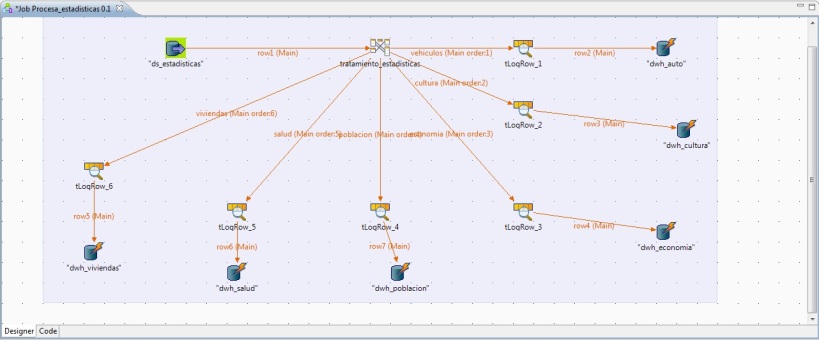

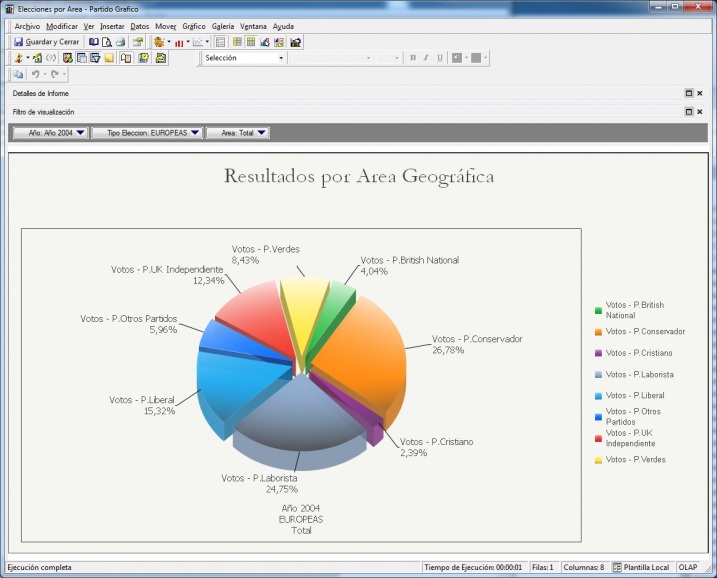

3.2.- ¿QUÉ ES UN DATA WAREHOUSE?